在AI大模型競爭白熱化的當下,高效推理與長上下文處理已成爲開發者痛點。近日,螞蟻集團旗下百靈大模型團隊正式開源Ring-flash-linear-2.0-128K,一款專爲超長文本編程設計的創新模型。該模型以混合線性注意力機制和稀疏MoE架構爲核心,激活僅6.1B參數即媲美40B密集模型,在代碼生成、智能代理等領域實現SOTA(最優)表現。AIbase基於Hugging Face官方發佈與技術報告獨家解析其突破性亮點,助力開發者擁抱“高效AI編程”新時代。

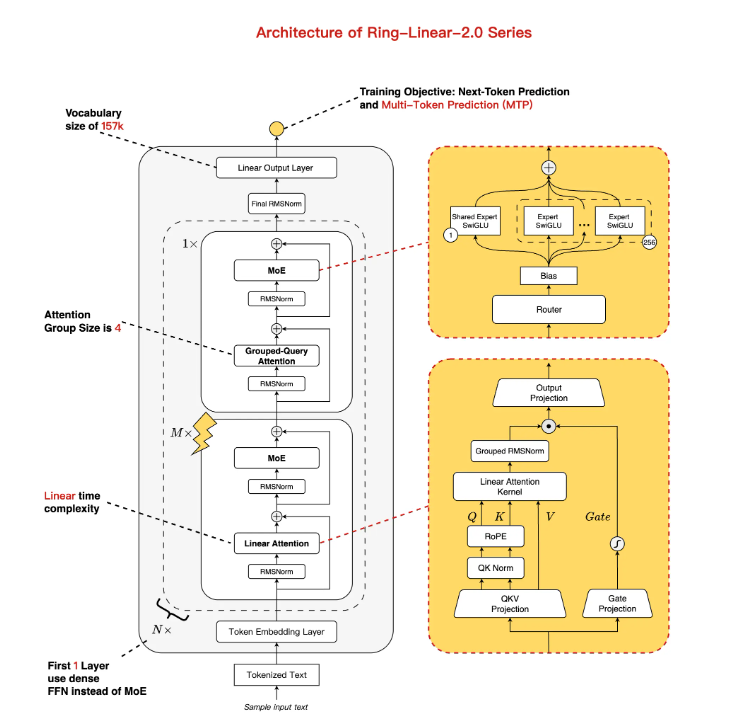

創新架構:線性+標準注意力混合,MoE優化平衡性能與效率

Ring-flash-linear-2.0-128K基於Ling-flash-base-2.0迭代升級,總參數規模達104B,但通過1/32專家激活比率和多任務處理層(MTP)等優化,僅激活6.1B參數(非嵌入4.8B),實現近線性時間複雜度和常量空間複雜度。核心亮點在於混合注意力機制:主幹採用自研線性注意力融合模塊,輔以少量標準注意力,專爲長序列計算提效。相比傳統模型,該架構在H20硬件上支持128K上下文下200+ token/s生成速度,日常使用提速3倍以上,完美適配資源受限場景。

訓練升級:1T令牌額外微調+RL穩定,複雜推理能力躍升SOTA

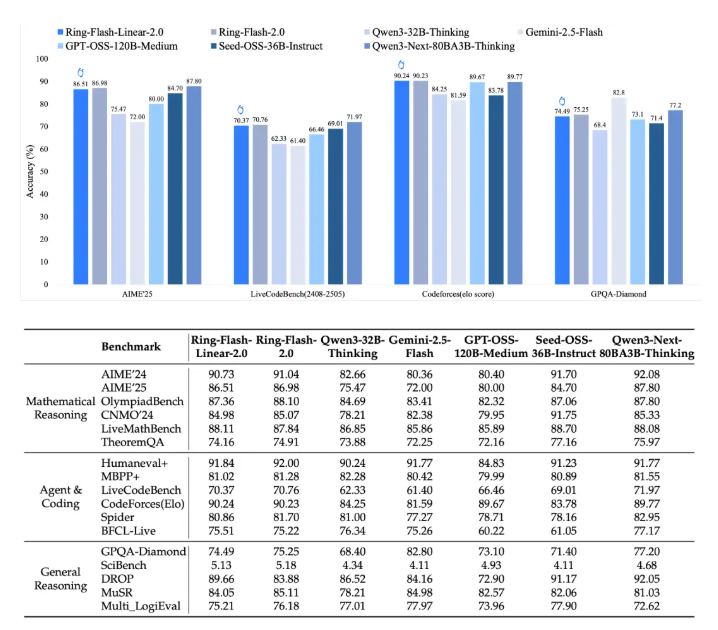

模型從Ling-flash-base-2.0轉換而來,進一步在額外1T令牌高質量數據集上訓練,結合穩定監督微調(SFT)和多階段強化學習(RL),攻克MoE長鏈推理訓練不穩定難題。得益於螞蟻自研“棒冰(icepop)”算法,該模型在高難度任務中展現卓越穩定性:在AIME2025數學競賽獲86.98高分,CodeForces編程Elo達90.23,邏輯推理與創意寫作v3均超40B以下密集模型(如Qwen3-32B)。基準測試顯示,它不僅匹敵標準注意力模型(如Ring-flash-2.0),還在多項開源MoE/Dense模型中拔得頭籌。

長上下文黑科技:原生128K+YaRN擴展至512K,長輸入輸出零卡頓

針對編程痛點,Ring-flash-linear-2.0-128K原生支持128K上下文窗口,開發者可通過YaRN外推技術輕鬆擴展至512K。在長形式輸入/輸出場景中,預填充(Prefill)階段吞吐量較Qwen3-32B提升近5倍,解碼(Decode)階段達10倍加速。實測顯示,在32K+上下文編程任務中,模型保持高精確度,無“穿模”或漂浮感問題,特別適用於前端開發、結構化代碼生成和代理模擬等複雜場景。

開源即用:Hugging Face+ModelScope雙平臺部署,零門檻上手指南

爲加速社區落地,百靈團隊已將模型權重同步開源至Hugging Face與ModelScope,支持BF16/FP8格式。安裝依賴後,即可通過Transformers、SGLang或vLLM框架一鍵加載:

- Hugging Face示例:pip install flash-linear-attention==0.3.2transformers==4.56.1,加載後直接generate長代碼提示。

- vLLM在線推理:tensor-parallel-size4下,GPU利用率90%,支持API調用。

技術報告詳見arXiv(https://arxiv.org/abs/2510.19338),開發者可立即下載體驗。

MoE線性注意力時代開啓,螞蟻百靈領跑高效編程AI

此次開源標誌着螞蟻百靈在“MoE+長思維鏈+RL”路線上的新突破,從Ling2.0系列到Ring-linear,效率提升7倍不止。AIbase認爲,在成本僅1/10的長文本推理浪潮中,該模型將重塑開發者生態:編程小白可秒生複雜腳本,代理系統更智能,企業級應用零門檻部署。未來,隨着Ring-1T萬億級旗艦跟進,國產MoE或將主導全球高效AI賽道。

結語

Ring-flash-linear-2.0-128K以“小激活大性能”詮釋AI開源新範式,爲超長編程注入強勁引擎。開發者們,速上Hugging Face/ModelScope試水吧!AIbase將追蹤其社區迭代動態。