AIの大規模モデル競争が白熱する中、効率的な推論と長文の処理は開発者にとって大きな課題となっています。最近、アリババグループ傘下のバイリン大規模モデルチームは、超長文プログラミング専用の革新モデル「Ring-flash-linear-2.0-128K」を正式にオープンソース化しました。このモデルは、混合線形アテンション機構とスパースMoEアーキテクチャを核とし、わずか6.1Bのパラメータで40Bの密なモデルと同等の性能を発揮し、コード生成やインテリジェントエージェントなどの分野で最善(SOTA)の結果を達成しています。AIbaseはHugging Faceの公式発表と技術報告書に基づき、その画期的な特徴を独自に解説し、開発者が「効率的なAIプログラミング」の新時代に挑戦できるようサポートします。

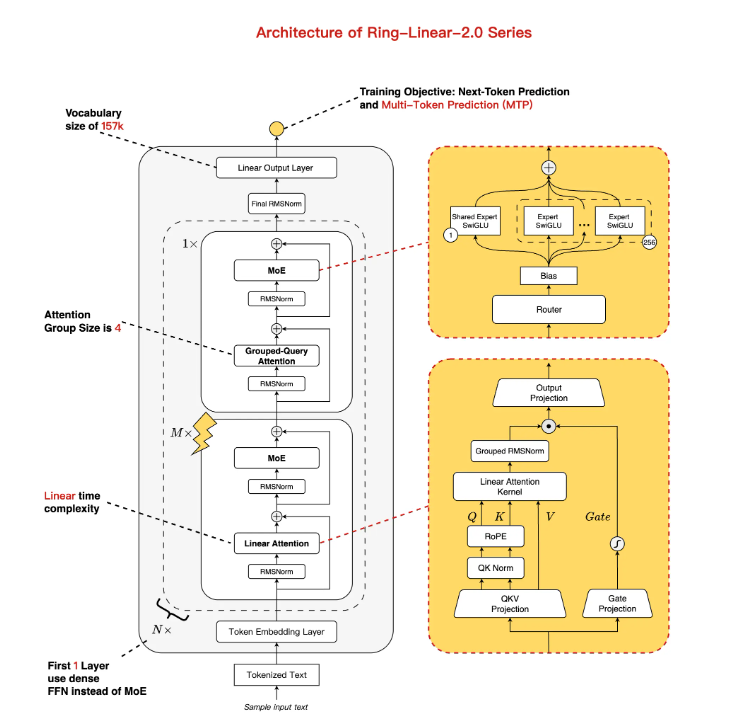

革新的なアーキテクチャ:線形+標準アテンションの混合、MoEによる性能と効率のバランス

Ring-flash-linear-2.0-128KはLing-flash-base-2.0を基盤として進化したモデルで、全体のパラメータ数は104Bですが、1/32のエキスパート活性化率とマルチタスク処理層(MTP)などの最適化により、実際には6.1Bのパラメータ(非埋め込み部は4.8B)が動作します。これにより近似線形時間複雑度と定数空間複雑度を実現しています。主なポイントは、混合アテンション機構です。メイン部分では自社開発の線形アテンション統合モジュールを採用し、少量の標準アテンションを補完して長系列計算を高速化しています。従来モデルと比較すると、H20ハードウェア上で128Kの文脈下で200以上のトークン/秒の生成速度をサポートし、日常的な使用では3倍以上速く、リソース制限のある環境にも最適です。

トレーニングのアップグレード:1Tトークンの追加微調整+RLの安定性、複雑な推論能力がSOTAへ飛躍

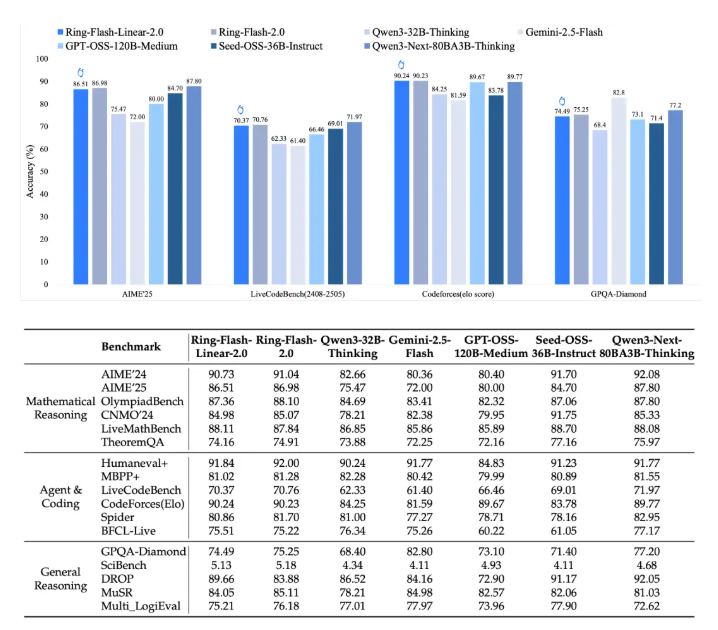

このモデルはLing-flash-base-2.0から変換され、さらに高品質なデータセットで1Tトークンの追加トレーニングを行い、安定した監督微調整(SFT)と多段階強化学習(RL)を組み合わせることで、MoEにおける長期間の推論トレーニングの不安定性問題を克服しました。アリババ自社開発の「棒冰(icepop)」アルゴリズムにより、このモデルは困難なタスクにおいて優れた安定性を示します。AIME2025数学コンテストで86.98点を獲得し、CodeForcesのプログラミング Elo は90.23、論理的推論と創造的ライティング v3 は40B以下の密なモデル(例: Qwen3-32B)を上回りました。ベンチマークテストによると、これは標準アテンションモデル(例: Ring-flash-2.0)と同等であり、多くのオープンソース MoE/Dense モデルの中で最も優れた結果を収めています。

長文ブラックテクノロジー:ネイティブ128K+YaRN拡張で512Kまで対応、長入出力でもフリーズなし

プログラミングの課題に対応するために、Ring-flash-linear-2.0-128Kはネイティブで128Kの文脈窓をサポートしており、開発者はYaRN外挿技術を使って簡単に512Kに拡張できます。長文の入出力シナリオでは、プレフィル(Prefill)フェーズでのトランジット量はQwen3-32Bよりも約5倍向上し、デコード(Decode)フェーズでは10倍の高速化が可能です。実験結果によると、32K以上の文脈を持つプログラミングタスクにおいても、モデルは高い正確性を維持し、「穿模」や浮遊感の問題はありません。特に、フロントエンド開発、構造化コード生成、エージェントシミュレーションなどの複雑なシナリオに適しています。

即座に利用可能:Hugging Face+ModelScope両プラットフォームでの展開、ゼロコストで始められるガイド

コミュニティへの導入を加速するため、バイリンチームはモデルの重みをHugging FaceとModelScopeにオープンソース化し、BF16/FP8形式をサポートしています。依存関係をインストールすれば、Transformers、SGLang、またはvLLMフレームワークでワンクリックで読み込み可能です。

- Hugging Faceの例:pip install flash-linear-attention==0.3.2 transformers==4.56.1 を実行し、読み込み後に長文コードのプロンプトを直接generateします。

- vLLMオンライン推論:tensor-parallel-size4でGPU利用率は90%となり、API呼び出しをサポートします。

技術報告書はarXiv(https://arxiv.org/abs/2510.19338)で確認できます。開発者はすぐにダウンロードして体験できます。

MoE線形アテンションの時代が到来、アリバババイリンが効率的なプログラミングAIをリード

今回のオープンソースは、アリバババイリンが「MoE+長文思考チェーン+RL」の路線で新たな突破を果たしたことを意味します。Ling2.0シリーズからRing-linearへと進化し、効率は7倍以上向上しています。AIbaseによれば、コストが1/10である長文推論の波の中、このモデルは開発者エコシステムを再構築するでしょう。初心者も複雑なスクリプトを瞬時に生成でき、エージェントシステムはより知的になり、企業向けアプリケーションはゼロコストで導入できます。今後、Ring-1Tのトレリオン級の旗艦モデルが登場し、中国製のMoEが世界の効率的なAI競争を主導することになるでしょう。

結論