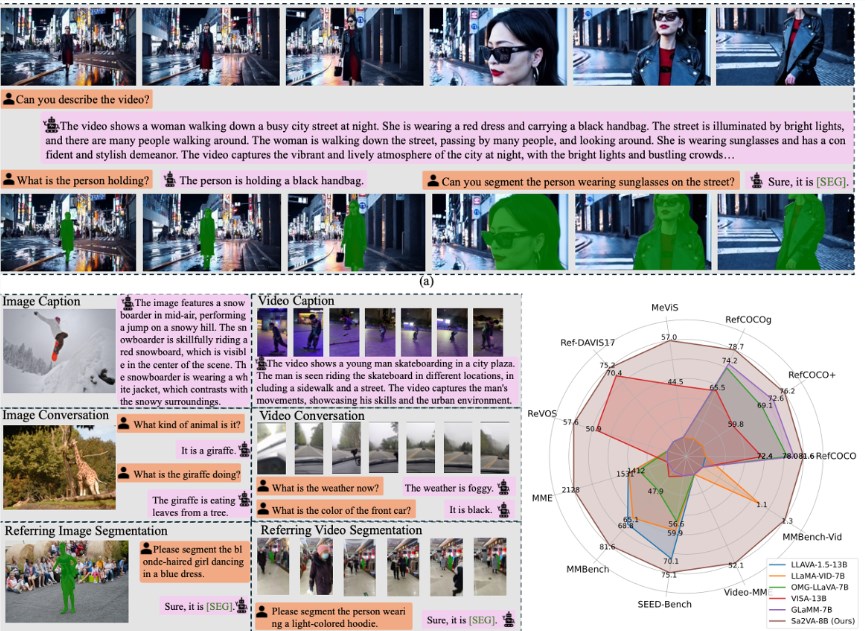

最近のAI技術の進展において、バイトダンスは多くの大学研究チームと協力し、先進的な視覚言語モデルであるLLaVAとセグメンテーションモデルのSAM-2を組み合わせ、Sa2VAという新しいモデルをリリースしました。このイノベーティブなモデルは動画の内容を理解できるだけでなく、ユーザーの指示に従って動画内のキャラクターや物体を正確にトラッキングおよびセグメント化することができます。

LLaVAはオープンソースの視覚言語モデルであり、動画の全体的な物語や内容の理解に長けていますが、細かい指示には弱いです。一方、SAM-2は画像セグメンテーションの専門家として優れており、画像中のオブジェクトを識別・セグメント化できますが、言語理解能力は欠如しています。両者の欠点を補うために、Sa2VAは簡単で効率的な「暗号」システムを通じて、これらのモデルを効果的に統合しています。

Sa2VAのアーキテクチャは、二つのコアを持つプロセッサのように考えることができます。一つのコアは言語理解と会話を担当し、もう一つのコアは動画のセグメンテーションとトラッキングを担当します。ユーザーが指示を入力すると、Sa2VAは特定の指示トークンを生成し、SAM-2に送信して具体的なセグメンテーション操作を行います。この設計により、2つのモジュールはそれぞれの分野で専門性を発揮し、効果的なフィードバック学習を行うことができ、全体の性能を継続的に向上させます。

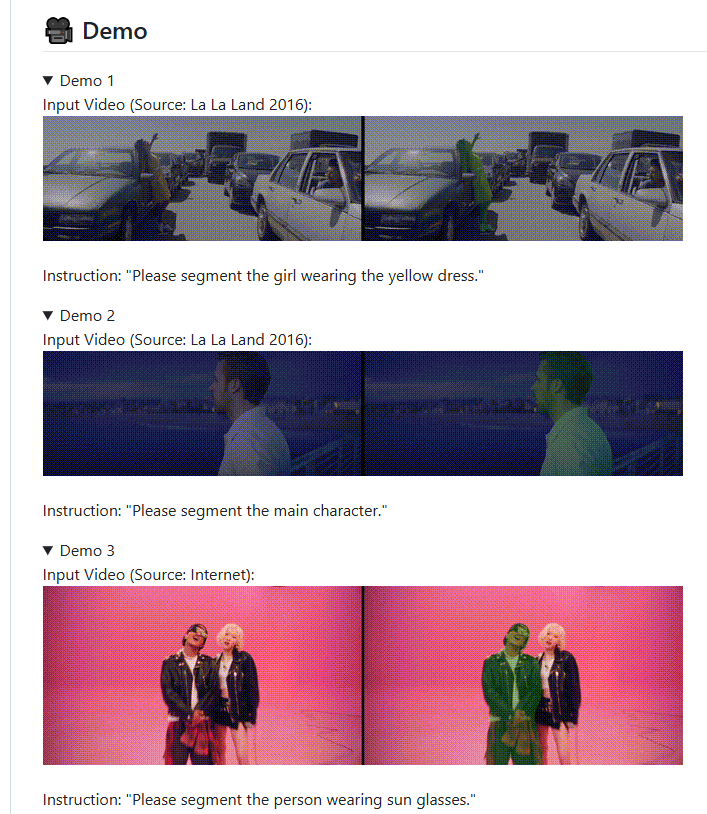

研究チームはSa2VAのために多タスク連携トレーニングコースを設計し、画像および動画の理解能力を強化しました。複数の公開テストでは、Sa2VAは優れたパフォーマンスを示し、特に動画指標表現セグメンテーションタスクにおいて目立ちました。これは複雑な現実的なシナリオで正確なセグメンテーションを実現できることを示しており、動画内で対象オブジェクトをリアルタイムでトラッキングできることから、強力な動的処理能力を備えています。

また、バイトダンスはSa2VAのさまざまなバージョンとトレーニングツールを公開し、開発者による研究と応用を奨励しています。この取り組みにより、AI分野の研究者と開発者にとって豊富なリソースが提供され、マルチモーダルAI技術の発展を促進しています。

プロジェクト:

https://lxtgh.github.io/project/sa2va/

https://github.com/bytedance/Sa2VA

ポイント:

- 🎥 Sa2VAはバイトダンスがリリースした新しいモデルで、LLaVAとSAM-2の利点を組み合わせ、動画の内容の理解とセグメンテーションを実現しています。

- 🔗 このモデルは「暗号」システムを通じて言語理解と画像セグメンテーションを効果的に接続し、インタラクティブ能力を向上させています。

- 🌍 Sa2VAのオープンリソースは開発者に豊富なツールを提供し、マルチモーダルAI技術の研究と応用を促進しています。