特斯拉前自動駕駛負責人、OpenAI聯合創始人Andrej Karpathy近日在推特上評論了開源的DeepSeek-OCR論文,提出了一個頗具啓發性的觀點:相比傳統文本輸入,圖像作爲大語言模型(LLM)的輸入形式可能更加高效。這一觀點在AI研究社區引發了關於模型輸入方式未來演進方向的討論。

Karpathy認爲,當前廣泛使用的文本token輸入方式可能既浪費又低效,未來研究或許應該轉向圖像輸入。他從幾個維度闡述了圖像輸入相比文本輸入的潛在優勢。

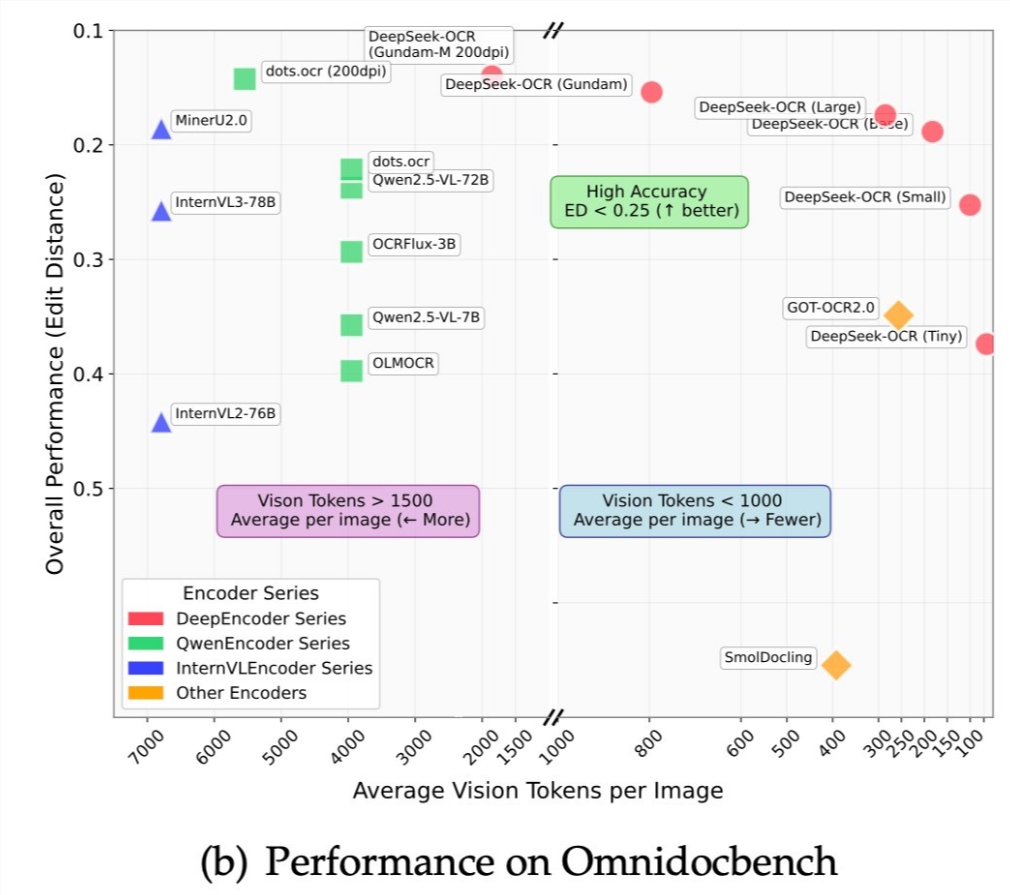

首先是信息壓縮率的提升。將文本渲染成圖像後,可以用更少的視覺token傳遞更多信息。這是因爲一個圖像patch可以包含多個字符的信息,而在傳統文本tokenization中,每個字符或子詞都需要單獨的token。在處理大規模上下文時,這種壓縮可能顯著提升模型效率,降低計算成本。

其次是信息表達的豐富性。圖像輸入天然支持加粗、顏色、字體大小、佈局等視覺元素,這些格式信息在傳統純文本輸入中要麼丟失,要麼需要通過額外的標記語言(如Markdown)來表示,後者又會增加token消耗。直接使用圖像可以讓模型更自然地理解文檔的視覺結構和強調重點。

第三是注意力機制的優化空間。圖像輸入可以使用雙向注意力機制,而傳統的文本生成任務通常採用自迴歸的因果注意力。雙向注意力能夠讓模型同時關注上下文的所有位置,通常能提供更強的理解能力。這種處理方式避免了自迴歸文本處理的一些固有限制。

Karpathy特別批評了tokenizer(分詞器)的複雜性。他認爲tokenizer是一個非端到端的歷史遺留模塊,引入了許多不必要的複雜性。例如,視覺上相同的字符可能因爲來自不同Unicode編碼而被映射到不同的token,導致模型對看似相同的輸入產生不同的理解。去掉tokenizer直接處理圖像,將使整個系統更加簡潔統一。

從技術實現角度看,Karpathy的觀點建立在視覺編碼器已經相當成熟的基礎上。Vision Transformer等架構已經能夠高效處理圖像輸入,而DeepSeek-OCR等模型證明了視覺到文本的轉換可以達到很高的準確率。將這種能力推廣到所有文本處理任務,在技術上具有可行性。

不過Karpathy也指出了一個不對稱性:雖然用戶輸入可以是圖像,但模型輸出仍需要保持爲文本形式,因爲生成逼真的圖像仍然是一個未完全解決的問題。這意味着即使採用圖像輸入,模型架構仍需要支持文本生成,不能完全摒棄文本處理能力。

這一觀點引發的討論涉及多個層面。從效率角度看,如果圖像輸入確實能提高信息密度,在處理長文檔和大規模上下文時將有明顯優勢。從統一性角度看,圖像輸入可以將文檔理解、OCR、多模態問答等任務統一到同一框架下,簡化模型架構。

但圖像輸入也面臨挑戰。首先是計算成本,雖然信息密度更高,但圖像編碼本身的計算開銷可能抵消部分收益。其次是可編輯性,純文本易於編輯和操作,而圖像形式的"文本"在後續處理中會失去這種靈活性。第三是生態兼容性,現有的大量文本數據和工具鏈都基於字符/token表示,完全轉向圖像輸入需要重建整個生態系統。

從研究方向來看,Karpathy的觀點提示了一個有趣的可能性:隨着視覺模型能力的提升,傳統的"語言模型"可能演變爲更通用的"信息處理模型",其中文本只是信息的一種呈現形式,而非唯一的輸入表示。這種轉變可能模糊語言模型和多模態模型之間的界限。

DeepSeek-OCR論文成爲這一討論的契機,說明OCR任務已經從單純的字符識別演變爲更深層的文檔理解。如果OCR模型能夠準確理解各種格式和佈局的文本,那麼將所有文本任務都視爲"視覺理解"任務在概念上是合理的。

Karpathy的自嘲——"得控制住不要立刻去開發只支持圖像輸入的聊天機器人"——既表達了對這一想法的興趣,也暗示了實際落地的複雜性。這種激進的架構轉變需要大量實驗驗證,證明其在各種任務上的有效性,同時解決上述提到的各種實際挑戰。

從產業應用角度看,即使圖像輸入最終被證明更優,過渡也會是漸進的。更可能的路徑是混合模式:在需要保留視覺格式信息的場景使用圖像輸入,在需要靈活編輯和組合的場景使用文本輸入。這種混合策略可以兼顧兩種方式的優勢。

總體而言,Karpathy的觀點提出了一個值得深入探索的研究方向,挑戰了文本token作爲語言模型標準輸入的固有假設。無論這一願景是否完全實現,它都爲思考模型輸入表示的優化提供了新的視角,可能催生新一代更高效、更統一的AI架構。