近日,DeepSeek發佈了全新的OCR文檔理解模型——DeepSeek-OCR。該模型不僅在圖像文檔解析方面取得了頂級性能,更引入了一個大膽且極具創新性的概念:“視覺記憶壓縮”機制,旨在革命性地解決大型語言模型(LLM)在處理超長上下文時計算資源爆炸性增長的難題。

核心突破:讓AI“看圖閱讀”實現高效壓縮

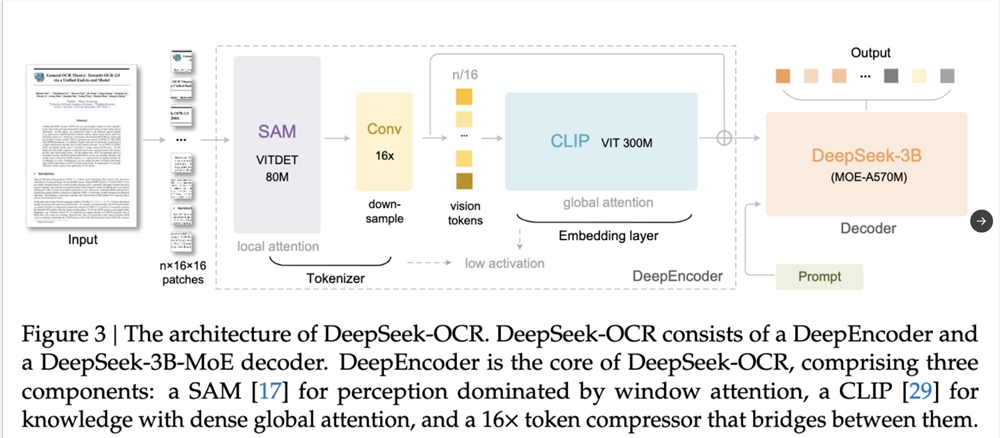

DeepSeek-OCR的核心創新在於模仿人類的視覺記憶機制,將長文本信息壓縮到圖像空間中,從而實現對語言模型“Token”消耗的顯著減少。

工作原理簡述:

該機制通過“將文本繪製爲圖像”的方式進行:首先,長文本被壓縮成單個圖像;然後,使用視覺模型將該圖像壓縮爲最少數量的“視覺標記”(Visual Tokens);最後,語言模型從這些視覺標記中解碼並恢復文本。

換言之,該技術使模型能夠**“通過看圖片閱讀”**,而非傳統的“逐字閱讀”,極大地提高了信息處理效率。

驚人效能:10倍壓縮與未來潛力

DeepSeek展示了驚人的壓縮效果:一篇1000字的文章,在壓縮成一張圖片後,僅需100個視覺Token(實現10倍壓縮)來表示,模型在解壓縮時仍能恢復97%的原始文本。

這一突破性成果不僅演示了“視覺記憶壓縮”的有效性,更揭示了其對未來AI發展的巨大潛力:

解決LLM內存限制: 有望成爲破解大模型“內存限制”的關鍵技術,使AI能夠以更少的計算量處理**“數百頁”**的超長上下文。

未來AI記憶存儲: 未來AI可將舊記憶轉化爲圖像進行存儲,實現高效的信息歸檔。

類比人類“遺忘曲線”:高保真與低密度記憶

DeepSeek將這種視覺壓縮機制比作人類的**“遺忘曲線”**,巧妙地模擬了人類的自然記憶和遺忘過程:

高保真記憶: 最近的上下文被保留爲高分辨率圖像,即高保真信息。

低密度記憶: 較舊的上下文則被壓縮成模糊的圖像,即信息密度較低。

這種分層壓縮機制,在節省計算資源的同時,也使得AI的記憶處理過程更加貼近自然。

地址:https://deepseekocr.app/