AI 技術公司 DeepSeek 近日推出了一款名爲 “DeepSeek-OCR” 的全新光學字符識別(OCR)模型。這款模型是一種端到端的視覺語言模型(VLM),旨在通過將長文本壓縮爲一小組視覺標記,隨後利用語言模型進行解碼,從而實現高效的文檔解析。

研究團隊表示,該模型在 Fox 基準測試中實現了97% 的解碼精度,當文本標記數與視覺標記數的比例爲10倍時,精度依然保持良好,甚至在20倍壓縮下也能表現出有用的特性。此外,DeepSeek-OCR 在 OmniDocBench 基準測試中也表現出色,使用的視覺標記數量遠少於傳統模型。

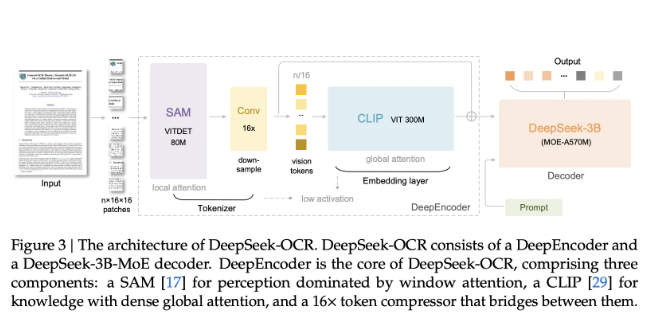

DeepSeek-OCR 的架構由兩個主要組件組成:高分辨率輸入的視覺編碼器 DeepEncoder 和一個名爲 DeepSeek3B-MoE-A570M 的專家混合解碼器。該編碼器採用了一種基於 SAM 的局部感知窗口注意機制和卷積壓縮算法,能夠有效控制高分辨率下的激活內存,並減少輸出標記的數量。解碼器則是一個擁有30億參數的模型,每個標記有約5.7億個活躍參數。

在使用不同的模式時,DeepEncoder 提供了多種分辨率選擇,包括 Tiny、Small、Base 和 Large 模式,分別對應不同的視覺標記數量和分辨率。此外,還有動態模式 Gundam 和 Gundam-Master,可以根據頁面複雜性靈活調整標記預算。

在訓練過程中,DeepSeek 團隊使用了分階段的訓練流程,首先對 DeepEncoder 進行下一個標記預測的訓練,然後在多個節點上進行全系統的訓練,最終每天能夠生成超過20萬頁的文檔。對於實際應用,團隊建議用戶從 Small 模式開始,如果頁面包含密集的小字體或高標記數量,可以選擇 Gundam 模式。

DeepSeek-OCR 的發佈標誌着文檔人工智能領域的一次重要進步。該模型的高效性和靈活性使其在處理各種文檔時都具備了良好的適應性。

論文:https://github.com/deepseek-ai/DeepSeek-OCR/blob/main/DeepSeek_OCR_paper.pdf

huggingface:https://huggingface.co/deepseek-ai/DeepSeek-OCR

劃重點:

🌟 DeepSeek-OCR 是一款新發布的3B 視覺語言模型,具備高效的 OCR 和文檔解析能力。

📊 該模型在 Fox 基準測試中實現了97% 的解碼精度,能在大幅壓縮的情況下仍保持良好表現。

🔧 DeepEncoder 支持多種模式和分辨率選擇,以適應不同文檔的複雜性和需求。