このたび、オープンソースコミュニティにはLLaVA-OneVision-1.5が登場しました。これは、技術の大きな進歩を示す新しいマルチモーダルモデルです。LLaVA(Large Language and Vision Assistant)シリーズは2年間の開発を経て、単純な画像・テキストのアライメントモデルから、画像や動画など多様な入力形式を処理できる統合的なフレームワークへと進化してきました。

LLaVA-OneVision-1.5のコアコンセプトは、オープンで効率的かつ再現可能なトレーニングフレームワークを提供することです。ユーザーが高品質なビジュアル言語モデルを簡単に構築できるようにするためのものです。トレーニングプロセスは3つの段階に分かれています。まず、言語-画像のアライメントによるプリトレーニング段階で、モデルは視覚特徴を言語の単語埋め込みに変換する学習を行います。

次に、第2段階「高品質な知識学習」において、モデルは8,500万のトレーニングサンプルで全パラメータをトレーニングし、大量の視覚的および知識情報を注入することで、モデルの能力を大幅に向上させます。最後に、ビジュアルインストラクションのファインチューニング段階では、設計されたデータセットを使用してトレーニングを行い、モデルにさまざまな複雑なビジュアルインストラクションを処理する能力を与えます。

効率面では、チームはイノベーティブなオフライン並列データパッキング方法を採用し、トレーニング効率を大幅に向上させました。8,500万のサンプルを基盤として、データ処理の圧縮比は11倍に達し、トレーニングプロセスはわずか3.7日で完了します。また、LLaVA-OneVision-1.5はRICE-ViTをビジュアルエンコーダーとして採用しており、領域感知型のビジュアル理解能力を持ち、特に文書内のテキスト処理に適しています。

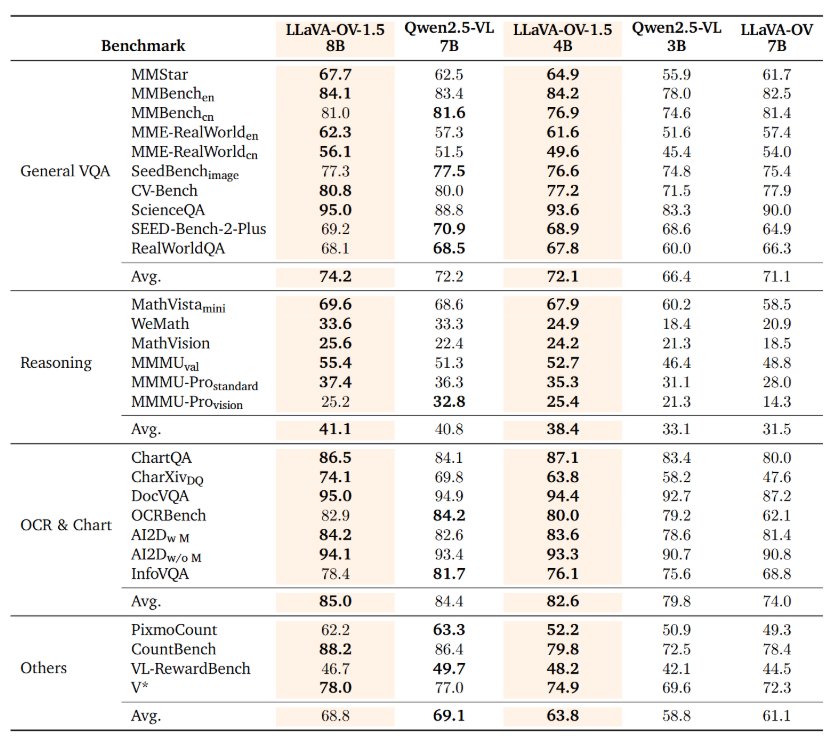

データはモデルの能力の基礎であり、LLaVA-OneVision-1.5のプリトレーニングデータセットは広範囲にわたっており、「コンセプトバランス」のサムプリング戦略を取り入れ、モデルが様々なタスクにおけるバランスの取れた性能を発揮できるようにしています。このモデルはあらゆるベンチマークテストで優れた成績を収めており、特に80億パラメータのバージョンは27のベンチマークでQwen2.5-VLを上回っています。

プロジェクト:

https://github.com/EvolvingLMMs-Lab/LLaVA-OneVision-1.5

https://huggingface.co/lmms-lab/LLaVA-OneVision-1.5-8B-Instruct

重要なポイント:

🌟 LLaVA-OneVision-1.5は最新のオープンソースマルチモーダルモデルであり、画像や動画などの多様な入力を処理できます。

📈 トレーニングプロセスは3つの段階に分かれており、モデルのビジュアルおよび言語理解能力を効率的に向上させます。

🏆 ベンチマークテストではLLaVA-OneVision-1.5が優れた性能を発揮し、Qwen2.5-VLモデルを上回りました。