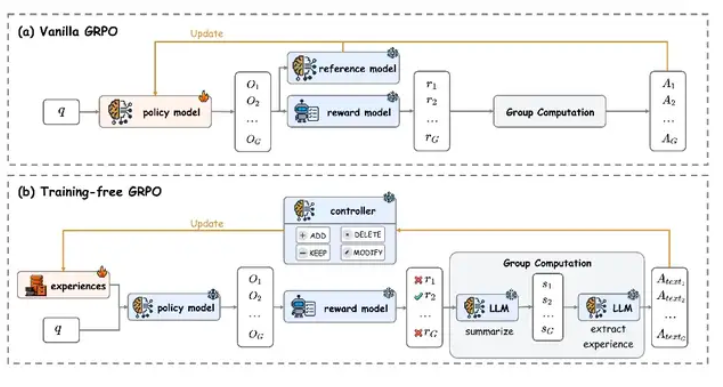

騰訊AI實驗室近期發佈了一種名爲"無訓練組相對策略優化"(Training-Free GRPO)的新型模型優化技術。這一方法通過外部知識庫更新替代傳統參數微調,在大幅降低訓練成本的同時,實現了與昂貴微調方案相當的性能提升。

該技術的核心創新在於將經驗知識轉化爲token級別的先驗信息,使大模型在參數完全凍結的狀態下完成性能優化。騰訊研究團隊在DeepSeek-V3.1-Terminus模型上進行的實驗顯示,這種方法在數學推理和網絡搜索等任務中均取得了顯著效果。

從技術實現角度看,傳統大語言模型在處理需要外部工具調用的複雜任務時常常表現欠佳。而Training-Free GRPO通過保持模型主體參數不變,僅動態維護一個外部經驗知識庫的方式來提升能力。這種設計不僅大幅削減了計算資源消耗,還增強了模型的跨領域泛化能力。

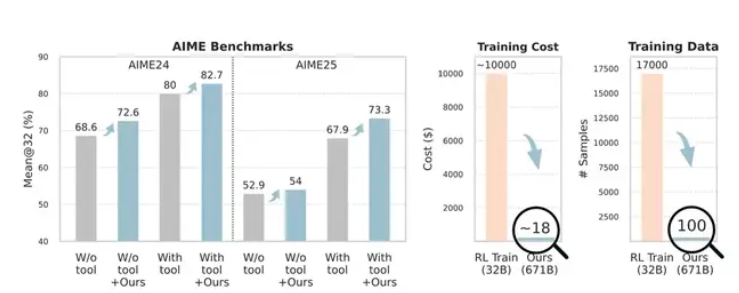

實驗數據具體體現了這一方法的有效性。在數學競賽級測試AIME24和AIME25中,經過Training-Free GRPO優化的DeepSeek-V3.1-Terminus模型準確率分別從80%和67.9%提升至82.7%和73.3%。更關鍵的是,這一提升僅使用了100個跨域訓練樣本,而傳統強化學習方法通常需要數千個樣本才能達到類似效果,後者的成本往往高達數萬美元。

在網絡搜索任務的測試中,該方法同樣表現出色,模型的Pass@1指標從63.2%提升至67.8%。這一系列測試結果表明,Training-Free GRPO在保持低成本投入的前提下,能夠在多種任務類型中實現穩定的性能改善。

從成本對比來看,官方數據顯示使用Training-Free GRPO優化一個模型僅需約120元人民幣,而傳統的參數微調方案通常需要投入7萬元左右的計算資源。這一成本差距主要源於該方法無需進行梯度回傳和參數更新等計算密集型操作。

這項技術的發佈爲AI模型優化提供了新的思路方向。特別是對於資源受限的中小企業和研究機構而言,這種低成本高效率的優化方案降低了大模型應用的門檻。不過需要注意的是,該方法的適用範圍和在更多場景下的表現還有待進一步驗證,當前公佈的測試數據主要集中在數學推理和信息檢索等特定任務上。

論文地址:https://arxiv.org/abs/2510.08191