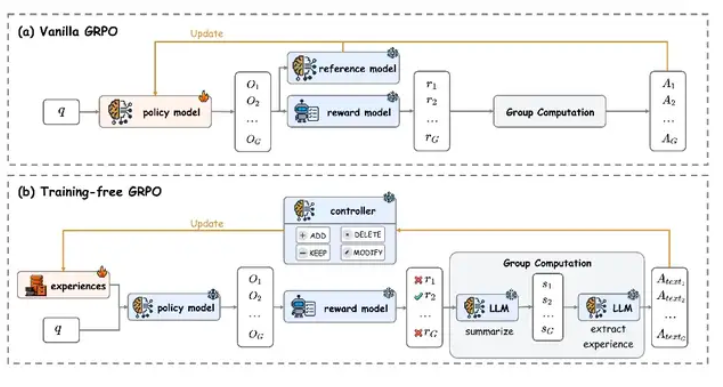

テンセントAI研究室は最近、"トレーニングフリーグローバル相対最適化"(Training-Free GRPO)という新しいモデル最適化技術を発表しました。この方法は従来のパラメータチューニングに代わって外部知識ベースを更新することで、トレーニングコストを大幅に削減しながら、高価なチューニングソリューションと同等の性能向上を実現しています。

この技術の核心的なイノベーションは、経験知をトークンレベルの事前情報に変換し、大規模モデルのパラメータを完全にロックした状態で性能を最適化することです。テンセントの研究チームによるDeepSeek-V3.1-Terminusモデルでの実験結果では、この方法が数学的推論やネットワーク検索などのタスクにおいて顕著な効果を示しています。

技術実装の観点から見ると、従来の大規模言語モデルは外部ツール呼び出しを必要とする複雑なタスクを処理する際によく機能しない傾向があります。一方で、Training-Free GRPOはモデル本体のパラメータを変更せず、外部経験知識ベースのみを動的に維持することで能力を向上させます。この設計により、計算リソースの消費を大幅に削減し、モデルの多分野への汎化能力も強化されました。

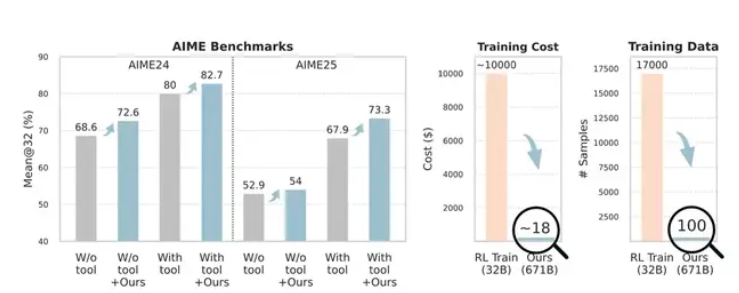

実験データはこの方法の有効性を具体的に示しています。数学コンテストレベルのテストAIME24およびAIME25において、Training-Free GRPOで最適化されたDeepSeek-V3.1-Terminusモデルの正解率はそれぞれ80%から82.7%、67.9%から73.3%に向上しました。より重要なのは、この向上にはわずか100個のクロスドメインのトレーニングサンプルしか使用されなかったことです。伝統的な強化学習方法では通常数千個のサンプルが必要であり、そのコストは数万ドルにも上ります。

ネットワーク検索タスクのテストでは、この方法も優れた成績を収めました。モデルのPass@1指標は63.2%から67.8%に上昇しました。この一連のテスト結果は、Training-Free GRPOが低コストで安定した性能改善を様々なタスクで実現できることを示しています。

コスト比較の観点から見ると、公式データによるとTraining-Free GRPOを使ってモデルを最適化するには約120元の人民元で済みますが、従来のパラメータチューニング方式では一般的に約7万元程度の計算リソースが必要です。このコスト差は主に、勾配逆伝播やパラメータ更新などの計算集約型操作を必要としないためです。

この技術の登場は、AIモデルの最適化に新たな方向性を提示しています。特に、リソースに制限がある中小企業や研究機関にとって、この低コストかつ高効率の最適化方法は大規模モデルの応用の障壁を下げます。ただし、この方法の適用範囲や他の多くのシナリオにおける性能はさらに検証する必要があります。現在公開されているテストデータは主に数学的推論や情報検索などの特定のタスクに限定されています。

論文アドレス:https://arxiv.org/abs/2510.08191