隨着生成式AI技術的飛速發展,視頻修復領域迎來了新的突破。阿里雲最新開源的Vivid-VR生成式視頻修復工具,以其出色的幀間一致性和修復效果,迅速成爲內容創作者和開發者的關注焦點。

Vivid-VR:生成式AI驅動的視頻修復新標杆

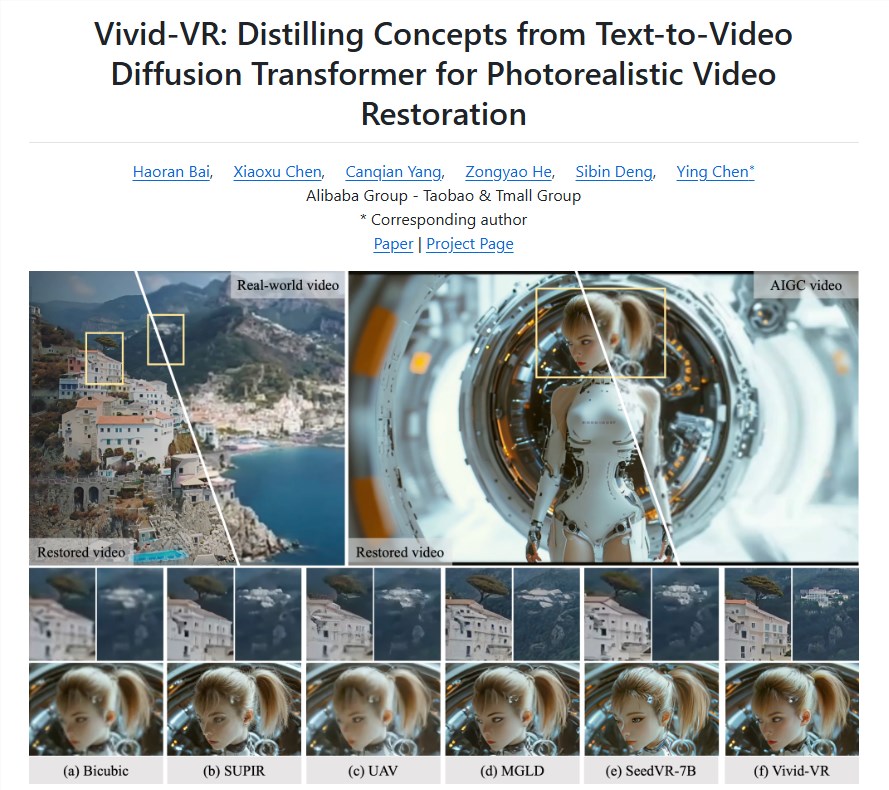

Vivid-VR是阿里雲推出的一款開源生成式視頻修復工具,基於先進的文本到視頻(T2V)基礎模型,結合ControlNet技術,確保視頻生成過程中的內容一致性。該工具能夠有效修復真實視頻或AIGC(AI生成內容)視頻中的質量問題,消除閃爍、抖動等常見缺陷,爲內容創作者提供了一個高效的素材補救方案。無論是對低質量視頻的修復,還是對生成視頻的優化,Vivid-VR都展現出了卓越的性能。

技術核心:T2V與ControlNet的完美融合

Vivid-VR的核心技術在於其結合了T2V基礎模型與ControlNet的創新架構。T2V模型通過深度學習生成高質量視頻內容,而ControlNet則通過精準的控制機制,確保修復後的視頻在幀間保持高度的時間一致性,避免了常見的閃爍或抖動問題。據悉,該工具在生成過程中能夠動態調整語義特徵,顯著提升視頻的紋理真實感和視覺生動性。這種技術組合不僅提高了修復效率,還爲視頻內容保持了更高的視覺穩定性。

廣泛適用:真實視頻與AIGC視頻全覆蓋

Vivid-VR的另一大亮點是其廣泛的適用性。無論是傳統拍攝的真實視頻,還是基於AI生成的內容,Vivid-VR都能提供高效的修復支持。對於內容創作者而言,低質量素材常常是創作過程中的痛點,而Vivid-VR能夠通過智能分析和增強,快速修復模糊、噪點或不連貫的視頻片段,爲短視頻、影視後期製作等領域提供了實用工具。此外,該工具支持多種輸入格式,開發者可以根據需求靈活調整修復參數,進一步提升創作效率。

開源生態:賦能全球開發者與創作者

作爲阿里雲在生成式AI領域的又一力作,Vivid-VR已完全開源,代碼和模型現已在Hugging Face、GitHub以及阿里雲的ModelScope平臺上免費提供。這一舉措延續了阿里雲在開源社區的領先地位。此前,阿里雲的Wan2.1系列模型已吸引超220萬次下載,位居VBench視頻生成模型榜首。Vivid-VR的開源進一步降低了內容創作者和開發者的技術門檻,讓更多人能夠基於這一工具開發定製化的視頻修復應用。

行業影響:推動內容創作的智能化升級

在2025年,視頻內容已成爲數字傳播的主導形式,但質量問題如模糊、抖動或低分辨率仍是創作者的挑戰。Vivid-VR的出現,爲內容創作者提供了一個高效、低成本的解決方案。無論是修復老舊視頻檔案,還是優化AI生成視頻的細節,Vivid-VR都展現出了強大的潛力。AIbase認爲,隨着生成式AI技術的普及,Vivid-VR不僅將助力內容創作者提升作品質量,還將推動視頻修復領域的智能化革新,爲行業帶來新的增長點。

Vivid-VR開啓視頻修復新篇章

Vivid-VR的開源發佈標誌着阿里雲在生成式AI領域的又一次突破。其強大的幀間一致性修復能力和靈活的開源特性,爲內容創作者和開發者提供了全新的工具選擇。AIbase相信,Vivid-VR不僅能解決視頻創作中的實際痛點,還將通過開源生態激發更多創新應用,助力全球內容創作行業的智能化轉型。

項目地址:https://github.com/csbhr/Vivid-VR