Liquid AI 正式推出 LFM2-VL,這是一款全新的視覺語言基礎模型系列,專爲低延遲和設備適應性部署而優化。此次發佈的 LFM2-VL 模型包括兩個高效的變體:LFM2-VL-450M 和 LFM2-VL-1.6B,這標誌着多模態 AI 在智能手機、筆記本電腦、可穿戴設備和嵌入式系統中的應用取得了重要進展,而不犧牲速度和準確性。

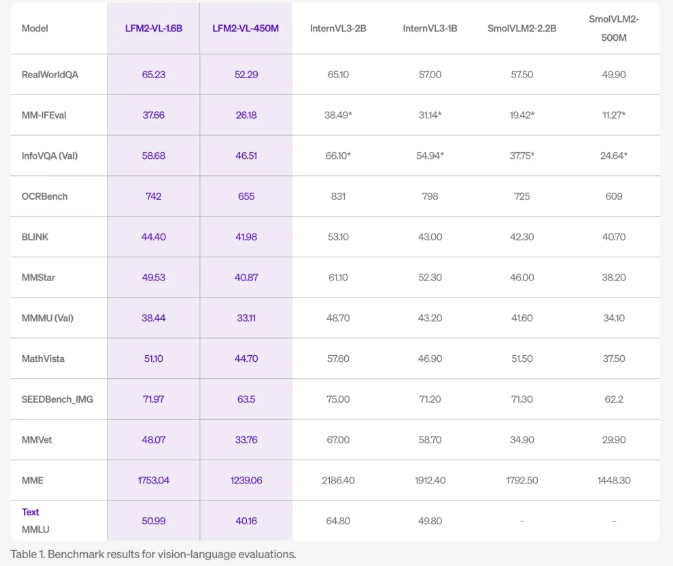

LFM2-VL 模型經過精心設計,相比現有的視覺語言模型,其 GPU 推理速度提高了兩倍,同時在圖像描述、視覺問答和多模態推理等任務上保持了競爭力的基準表現。450M 參數的版本專爲資源受限的環境而設計,而1.6B 參數的版本則在保持輕量級的同時,提供更強大的能力,適合單 GPU 或高端移動設備使用。

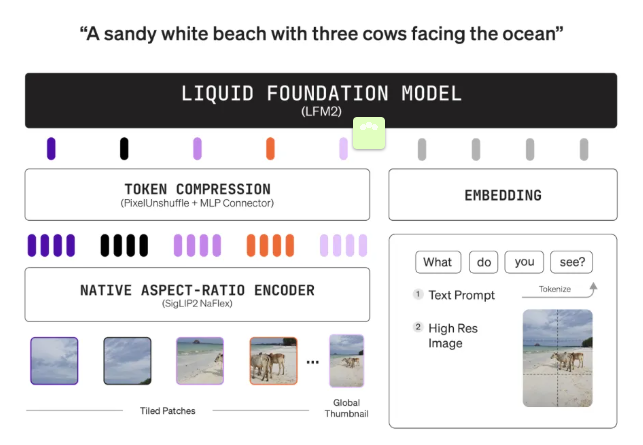

在技術創新方面,LFM2-VL 採用模塊化架構,結合了語言模型主幹(LFM2-1.2B 或 LFM2-350M)、SigLIP2NaFlex 視覺編碼器(400M 或86M 參數)和多模態投影器,使用 “像素解混” 技術動態減少圖像標記數量,以實現更快的處理速度。此外,模型能夠以原始分辨率處理圖像,最高可達512×512像素,避免了因放大而造成的失真。較大的圖像會被分割爲不重疊的512×512補丁,確保細節和長寬比的保留。1.6B 版本還會編碼全圖的縮小縮略圖,以便提供全球上下文理解。

LFM2-VL 模型的靈活推理能力使用戶能夠在推理時調整速度和質量的平衡,適應設備能力和應用需求。模型經過預訓練、聯合中訓練以融合視覺和語言能力,最終在大約1000億個多模態標記上進行了微調,確保了其在圖像理解方面的出色表現。

在公共基準測試中,LFM2-VL 的表現與 InternVL3和 SmolVLM2等大型模型相媲美,但內存佔用更小、處理速度更快,非常適合邊緣和移動應用。兩種模型均爲開放權重,並可在 Hugging Face 上下載,適用於研究和商業使用。對於大型企業,則需聯繫 Liquid AI 以獲取商業許可證。這些模型與 Hugging Face Transformers 無縫集成,並支持量化,以進一步提升在邊緣硬件上的效率。

LFM2-VL 旨在幫助開發者和企業快速、準確且高效地在設備上部署多模態 AI,減少對雲的依賴,推動機器人、物聯網、智能攝像頭和移動助手等新應用的出現。

huggingface:https://huggingface.co/collections/LiquidAI/lfm2-vl-68963bbc84a610f7638d5ffa

劃重點:

🌟 LFM2-VL 模型提供超高效的 GPU 推理速度,比現有模型快兩倍,適合各種設備使用。

🖼️ 支持原始分辨率處理圖像,並且能夠處理大圖像,確保細節不失真。

🚀 兩種模型均爲開放權重,可在 Hugging Face 上下載,適合研究和商業應用。