Liquid AI は、低遅延およびデバイス適応性のための最適化を施した新しい視覚言語ベースモデルシリーズ「LFM2-VL」を正式にリリースしました。今回の発表では、LFM2-VL-450M と LFM2-VL-1.6B の2つの効率的なバージョンが含まれており、スマートフォン、ノートブック、ウェアラブルデバイス、埋め込みシステムでのマルチモーダルAIの応用において重要な進展を示しています。速度と正確性を犠牲にすることなく実現しています。

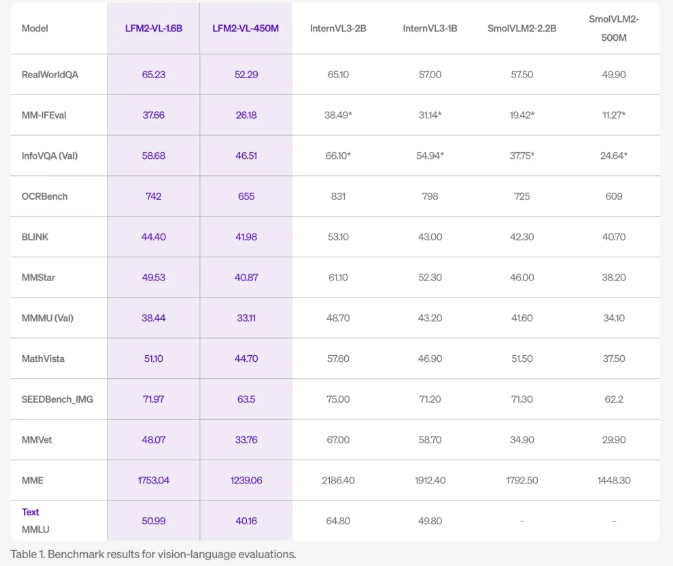

LFM2-VL モデルは、既存の視覚言語モデルと比較して、GPU推論速度が2倍に向上し、画像記述、視覚質問応答、マルチモーダル推論などのタスクで競争力のある基準性能を維持しています。450Mパラメータのバージョンはリソース制限された環境向けに設計されており、1.6Bパラメータのバージョンは軽量ながらもより強力な能力を提供し、単一GPUまたはハイエンドモバイルデバイスでの使用に適しています。

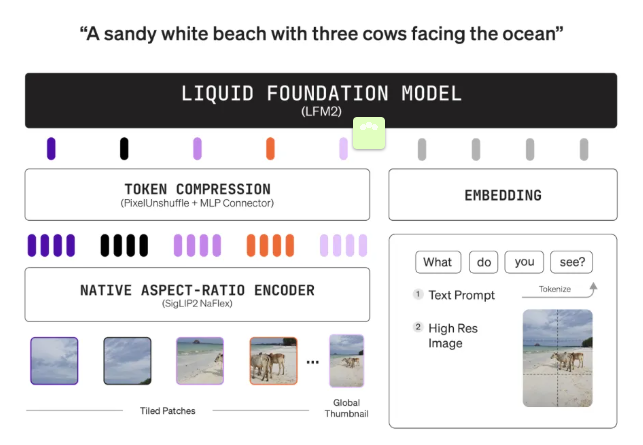

技術革新の面では、LFM2-VLはモジュール式アーキテクチャを採用しており、言語モデルのメイン(LFM2-1.2B または LFM2-350M)、SigLIP2NaFlexビジョンエンコーダー(400M または 86Mパラメータ)およびマルチモーダルプロジェクターから構成されています。「ピクセルデミックスング」技術を使用して、画像トークン数を動的に減らすことで、処理速度を向上させています。また、画像を元の解像度で処理でき、最大512×512ピクセルまで対応し、拡大による歪みを回避します。大きな画像は重ならない512×512のパッチに分割され、細部やアスペクト比が保持されます。1.6Bバージョンでは、全体の縮小サムネイルをコード化し、グローバルな文脈理解を提供します。

LFM2-VLモデルの柔軟な推論能力により、ユーザーはデバイスの能力とアプリケーションのニーズに応じて、速度と品質のバランスを調整できます。モデルは事前学習され、視覚と言語能力を統合するための共同学習を行った後、約1000億個のマルチモーダルマーカーで微調整され、画像理解における優れた性能を確保しています。

公開ベンチマークテストでは、LFM2-VLはInternVL3やSmolVLM2などの大規模モデルと同等の性能を発揮しますが、メモリ使用量が少なく、処理速度が速く、エッジおよびモバイルアプリケーションに非常に適しています。この2つのモデルはオープンウェイトであり、Hugging Faceでダウンロード可能で、研究および商業用途に適しています。大規模企業の場合、商用ライセンスが必要な場合はLiquid AIに連絡してください。これらのモデルはHugging Face Transformersとシームレスに統合され、さらにエッジハードウェアでの効率を向上させるために量化もサポートしています。

LFM2-VLは、開発者や企業がデバイス上でマルチモーダルAIを迅速かつ正確、そして効率的に展開できるようにするためのものです。クラウドへの依存を減らし、ロボット、IoT、スマートカメラ、モバイルアシスタントなどの新しい応用の登場を促進することを目指しています。

huggingface:https://huggingface.co/collections/LiquidAI/lfm2-vl-68963bbc84a610f7638d5ffa

ポイント:

🌟 LFM2-VL モデルは超効率的な GPU 推論速度を提供し、既存モデルの2倍の速度で動作し、さまざまなデバイスに適しています。

🖼️ 元の解像度で画像を処理でき、大きな画像にも対応し、細部を失わずに行えます。

🚀 2つのモデルはオープンウェイトで、Hugging Faceでダウンロード可能です。研究および商業用途に適しています。