近日,中山大學、鵬城實驗室與美團聯合發佈了一項名爲 X-SAM 的新型圖像分割多模態大模型,標誌着圖像分割技術的一次重要進步。該模型的出現,不僅提高了圖像分割的精度,還實現了從 “分割萬物” 到 “任意分割” 的重大飛躍。

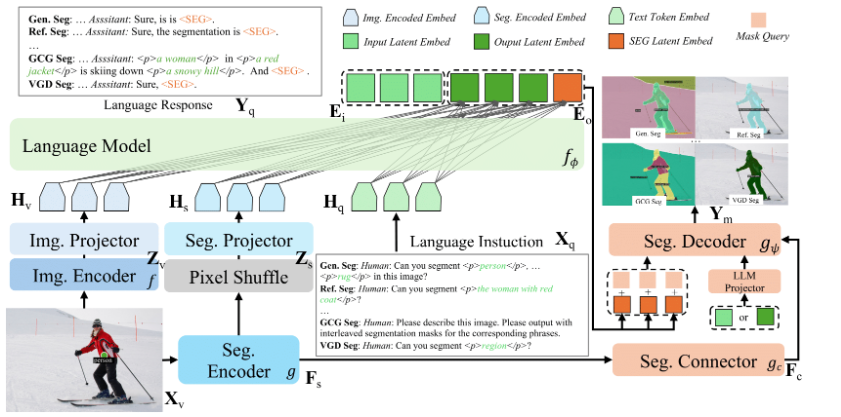

X-SAM 的核心在於其創新的設計理念,首先引入了統一的輸入和輸出格式,以適應不同的分割需求。用戶可以通過文本查詢或視覺查詢的方式進行操作,前者適用於通用分割等任務,後者則可通過點、塗鴉等視覺提示實現交互式分割。此外,X-SAM 的輸出採用統一表示,使得分割結果能夠被有效解讀。

爲了提升分割效果,X-SAM 採用了雙編碼器架構,其中一個負責提取全局特徵,另一個則關注細粒度特徵。這種設計不僅增強了模型的圖像理解能力,還確保了分割的精細化。同時,模型還引入了分割連接器和統一分割解碼器,前者能夠處理多尺度特徵,後者則替換了傳統的解碼器架構,進一步提高了分割性能。

X-SAM 的訓練過程分爲三個階段,第一階段爲分割器微調,旨在提升模型的基礎分割能力;第二階段進行對齊預訓練,使語言與視覺的嵌入對齊;第三階段則是混合微調,通過在多個數據集上進行協同訓練來優化模型的整體性能。實驗結果顯示,X-SAM 在20多個分割數據集上均達到了最先進的性能,展現了其卓越的多模態視覺理解能力。

隨着 X-SAM 的問世,研究團隊希望未來能夠將其應用擴展到視頻領域,結合時間信息,推動視頻理解技術的發展。這一新型模型的成功,不僅爲圖像分割研究開闢了新方向,也爲構建更爲通用的視覺理解系統奠定了基礎。

代碼地址:https://github.com/wanghao9610/X-SAM

Demo地址: https://47.115.200.157:7861

劃重點:

🌟 X-SAM 模型實現了從 “分割萬物” 到 “任意分割” 的重大飛躍,提升了圖像分割的精度和應用範圍。

💡 該模型引入統一輸入輸出格式,支持文本和視覺查詢,提升用戶交互體驗。

🚀 經過三階段訓練,X-SAM 在20多個數據集上達到了最先進性能,爲未來的視覺理解系統奠定基礎。