最近、中山大学、鹏城ラボラトリーおよびメイドゥーは、X-SAMと呼ばれる新しい画像セグメンテーションマルチモーダル大規模モデルを共同で発表しました。これは、画像セグメンテーション技術における重要な進歩を示しています。このモデルの登場により、画像セグメンテーションの精度が向上し、「万物をセグメントする」から「任意にセグメントする」への大きな飛躍が実現されました。

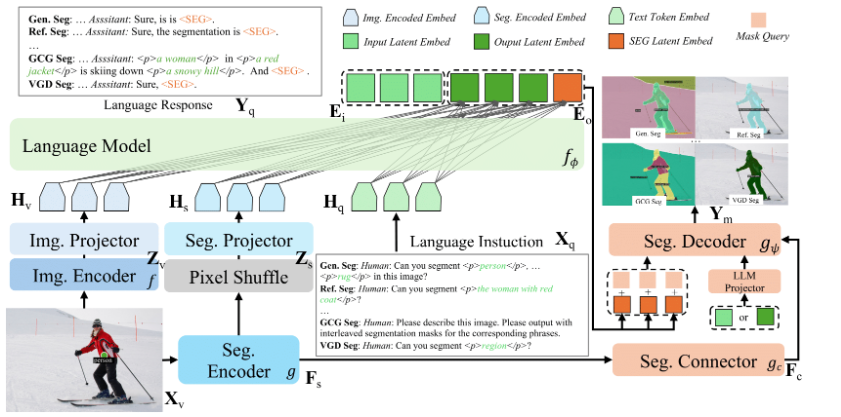

X-SAMのコアは、独自の設計理念にあります。まず、統一された入力および出力形式を導入し、さまざまなセグメンテーションのニーズに対応します。ユーザーはテキストクエリまたはビジュアルクエリの方法で操作できます。前者は一般的なセグメンテーションなどのタスクに適しており、後者はポイントやスケッチなどのビジュアルヒントを通じてインタラクティブなセグメンテーションを実現します。さらに、X-SAMの出力は統一された表現を使用しており、セグメンテーション結果が効果的に解釈できるようにしています。

セグメンテーションの効果を向上させるために、X-SAMは二つのエンコーダー構造を採用しています。一方は全体的な特徴を抽出し、もう一方は細粒度特徴に焦点を当てます。この設計により、モデルの画像理解能力が強化され、セグメンテーションがより詳細になります。また、モデルにはセグメンテーションコンネクターと統一されたセグメンテーションデコード器が導入されており、前者は多スケール特徴を処理し、後者は従来のデコード構造を置き換えて、セグメンテーション性能をさらに向上させています。

X-SAMのトレーニングプロセスは3段階に分けられます。第一段階はセグメンターの微調整であり、モデルの基本的なセグメンテーション能力を向上させることが目的です。第二段階ではアライメントプリトレーニングを行い、言語と視覚の埋め込みを一致させます。第三段階は混合微調整であり、複数のデータセットで協調トレーニングを行うことでモデル全体の性能を最適化します。実験の結果、X-SAMは20以上のセグメンテーションデータセットで最先端の性能を達成し、優れたマルチモーダルビジョン理解能力を示しました。

X-SAMの登場により、研究チームは今後、その応用を動画分野に拡張し、時間情報を組み合わせて動画理解技術の発展を推進したいと考えています。この新しいモデルの成功は、画像セグメンテーション研究に新たな方向性を開拓し、より汎用的なビジョン理解システムの構築に基礎を築くことになりました。

コードアドレス: https://github.com/wanghao9610/X-SAM

Demoアドレス: https://47.115.200.157:7861

ポイント:

🌟 X-SAMモデルは、「万物をセグメントする」から「任意にセグメントする」への大きな飛躍を実現し、画像セグメンテーションの精度と応用範囲を向上させました。

💡 このモデルは統一された入力・出力形式を導入し、テキストおよびビジュアルクエリをサポートし、ユーザーのインタラクション体験を向上させます。

🚀 三段階のトレーニングを経て、X-SAMは20以上のデータセットで最高のパフォーマンスを達成し、将来のビジョン理解システムの基盤を築きました。