騰訊近期正式開源了全新的文檔理解與語義檢索框架WeKnora(維娜拉)。這是一套專爲結構複雜、內容異構的文檔場景打造的智能問答解決方案,旨在爲企業級文檔問答提供高效、可控的端到端流程。

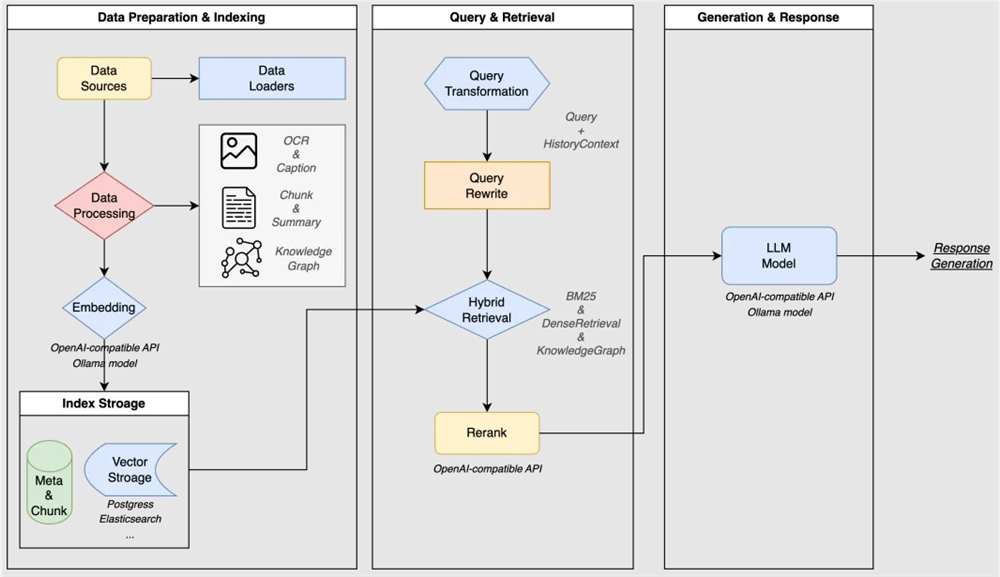

WeKnora採用現代化模塊化設計,構建了一條完整的文檔理解與檢索流水線,涵蓋文檔處理、知識建模、檢索引擎、推理生成以及交互展示等核心模塊。文檔處理層負責多種格式文檔的解析與預處理,將非結構化內容轉換爲結構化數據;知識建模層通過向量化、分塊、知識圖譜和索引等技術構建知識表示;檢索引擎層集成多種檢索策略,實現高效精準的內容召回;推理生成層利用大語言模型對檢索結果進行理解和生成;交互展示層則提供直觀的用戶界面和標準API接口。

WeKnora基於大語言模型(LLM)構建,融合了多模態預處理、語義向量索引、智能召回與大模型生成推理等技術。其技術亮點包括強大的多模態認知引擎,能夠精準解析PDF、Word、圖片中的圖文混排內容,提取文本、表格及圖像語義信息,並融合OCR與跨模態建模技術構建統一的結構化知識中樞。模塊化RAG流水線設計支持自由組合檢索策略、大語言模型與向量數據庫,能夠無縫集成Ollama等平臺,靈活切換Qwen、DeepSeek等主流模型,滿足企業知識庫的高效定製需求。精準推理與可信決策保障結合私有化部署、多輪上下文深度理解與全鏈路可視化評估,爲高敏感場景提供可靠的知識支撐。此外,WeKnora還支持本地化部署和Docker鏡像,兼容私有云及離線環境,內置監控日誌體系,提供全鏈路可觀測性,幫助運維人員高效管理。開箱即用的交互體驗包括一鍵啓動腳本和直觀的Web UI界面,非技術用戶也可以快速完成文檔索引、智能問答等服務的部署與應用。

WeKnora廣泛適用於多種企業級文檔問答場景,包括企業知識管理、科研文獻分析、產品技術支持、法律合規審查以及醫療知識輔助等。它提供了直觀易用的Web界面,支持拖拽上傳各類文檔,自動識別文檔結構並提取核心知識,建立索引。系統還支持知識圖譜可視化,能夠將文檔轉化爲知識圖譜,展示文檔中不同段落之間的關聯關係,提升檢索結果的相關性和廣度。

WeKnora的部署方式靈活多樣。本地部署方面,它提供了完整的Docker化部署方案,用戶只需通過簡單的命令即可快速啓動服務。此外,WeKnora作爲微信對話開放平臺的核心技術框架,還支持零代碼部署,用戶只需上傳知識,即可在微信生態中快速部署智能問答服務,實現“即問即答”的體驗。通過微信對話開放平臺,WeKnora的智能問答能力可無縫集成到公衆號、小程序等微信場景中,提升用戶交互體驗。

WeKnora採用MIT協議開源,歡迎社區用戶參與貢獻,無論是Bug修復、功能開發、文檔改進還是用戶體驗優化,騰訊都期待大家的參與與反饋。項目地址爲https://github.com/Tencent/WeKnora,感興趣的開發者可以訪問GitHub倉庫,瞭解更多詳情,共同構建更智能、更高效的文檔理解與檢索新範式。