騰訊は最近、新しいドキュメント理解およびセマンティック検索フレームワークのWeKnora(ウェイナラ)を正式にオープンソース化しました。これは構造が複雑で内容が異質なドキュメントのシナリオ専用のスマートQ&Aソリューションであり、企業向けドキュメントQ&Aに効率的かつ制御可能なエンドツーエンドプロセスを提供することを目的としています。

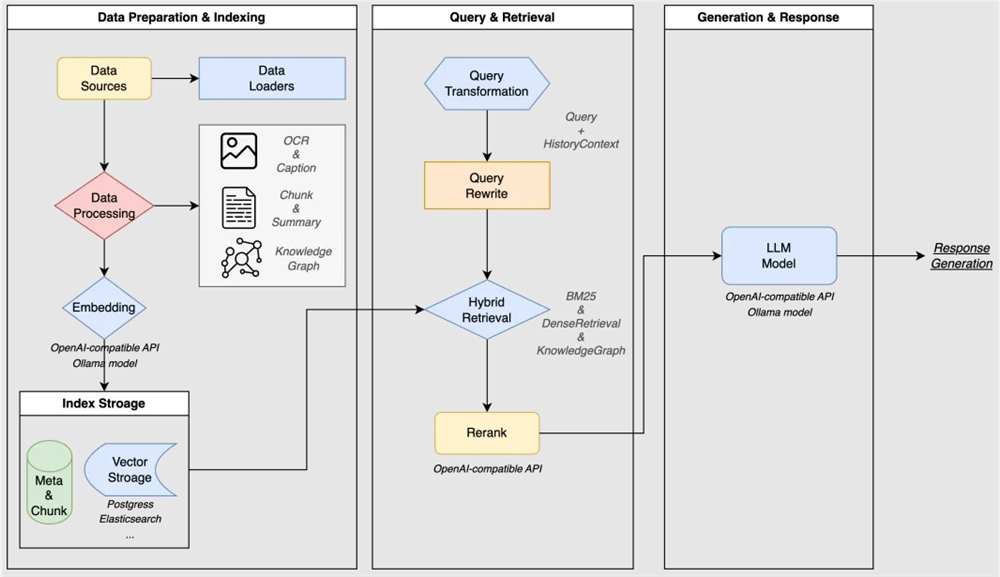

WeKnoraは現代的なモジュール化設計を採用しており、ドキュメント理解と検索の完全なパイプラインを構築しています。このパイプラインには、ドキュメント処理、知識モデリング、検索エンジン、推論生成、インタラクティブな表示などのコアモジュールが含まれています。ドキュメント処理層では、さまざまな形式のドキュメントの解析と前処理を行い、非構造化コンテンツを構造化データに変換します。知識モデリング層では、ベクトル化、ブロック分割、知識グラフ、インデックスなどの技術を用いて知識表現を構築します。検索エンジン層では、多様な検索戦略を統合し、効率的で正確なコンテンツの呼び出しを実現します。推論生成層では、大規模言語モデルを用いて検索結果を理解し生成します。インタラクティブな表示層では、直感的なユーザーインターフェースと標準APIインターフェースを提供します。

WeKnoraは大規模言語モデル(LLM)に基づいており、マルチモーダルプレプロセッシング、セマンティックベクトルインデックス、スマートなコールバック、大規模モデルの推論生成などの技術を統合しています。その技術的な特徴には、PDF、Word、画像中のテキストと図形の混在内容を正確に解析できる強力なマルチモーダル認知エンジンがあります。このエンジンは、テキスト、テーブル、画像の意味情報を抽出し、OCRとクロスモーダルモデリング技術を組み合わせて統一された構造化知識中枢を構築します。モジュール化されたRAGパイプライン設計により、検索戦略、大規模言語モデル、ベクトルデータベースを自由に組み合わせることができます。Ollamaなどのプラットフォームとシームレスに統合でき、QwenやDeepSeekなどの主要モデルを簡単に切り替えることができます。これにより、企業の知識ベースに対する効率的なカスタマイズが可能です。精度の高い推論と信頼性のある意思決定を確保するためには、プライベート配置、複数の文脈の深い理解、全チェーンの可視評価が組み合わされています。高機密な場面での信頼できる知識サポートを提供します。さらに、WeKnoraはローカル配置とDockerイメージをサポートしており、プライベートクラウドやオフライン環境にも対応しています。内蔵された監視ログシステムにより、全チェーンの観測可能性を提供し、運用担当者が効率的に管理できるようにします。開封即使用可能なインタラクティブな体験には、ワンクリック起動スクリプトと直感的なWeb UIインターフェースが含まれており、技術的な知識を持たないユーザーでもドキュメントインデックスやスマートQ&Aなどのサービスの設定とアプリケーションを迅速に行うことができます。

WeKnoraは多くの企業向けドキュメントQ&Aシナリオに適用できます。それは企業の知識管理、研究文献分析、製品技術支援、法律・コンプライアンス審査、医療知識補助などです。このツールは直感的で使いやすいWebインターフェースを提供し、さまざまなドキュメントのドラッグ&ドロップアップロードをサポートします。自動的にドキュメント構造を認識し、核心知識を抽出してインデックスを作成します。システムは知識グラフのビジュアライゼーションもサポートしており、ドキュメントを知識グラフに変換し、ドキュメント内の異なるセグメント間の関係性を表示することで、検索結果の関連性と幅を向上させます。

WeKnoraの配置方法は多様です。ローカル配置に関しては、完全なDocker化配置方案を提供しており、ユーザーは簡単なコマンドでサービスを素早く起動できます。また、WeKnoraはWeChatチャットオープンプラットフォームのコア技術フレームワークであり、コードなしの配置もサポートしています。ユーザーは知識をアップロードするだけで、WeChatエコシステム内でスマートQ&Aサービスを迅速に配置し、「即問即答」の体験を実現できます。WeChatチャットオープンプラットフォームを通じて、WeKnoraのスマートQ&A機能は公式アカウント、ミニアプリなどWeChatのシーンにシームレスに統合され、ユーザーのインタラクション体験を向上させます。