據國外媒體報道, 一項最新研究對阿里巴巴Qwen2.5模型的高數學分數提出了質疑,指出其看似卓越的數學推理能力,可能主要來源於對訓練數據的記憶,而非真正的推理。研究人員通過一系列嚴謹的測試發現,數據污染可能是導致Qwen2.5在某些基準測試中表現優異的關鍵因素。

數據污染浮出水面:乾淨基準下性能急劇下降

該研究的核心發現是,當Qwen2.5模型在訓練期間從未見過的“乾淨”基準上進行測試時,其性能出現了急劇下降。這表明模型在“受污染”的基準測試中取得的進步,很大程度上是由於其在訓練過程中已經接觸過這些數據。

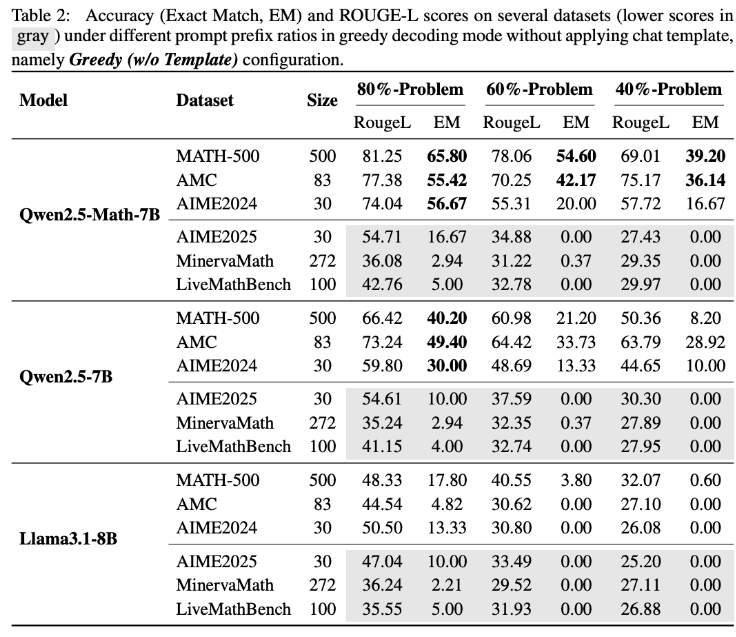

爲了驗證這一假設,研究團隊進行了一項創新性實驗:他們僅向Qwen2.5-Math-7B模型提供了MATH500基準測試的前60%題目,並要求其補全剩餘的40%。結果令人震驚:Qwen2.5-Math-7B竟能以高達54.6%的準確率(53.6%的正確率)成功重建缺失部分。相比之下,Llama3.1-8B的準確率僅爲3.8%(正確率爲2.4%)。這一顯著差異強烈暗示Qwen2.5在訓練過程中已經“見過”這些問題。

LiveMathBench測試:Qwen2.5完成率降至零

研究人員隨後使用LiveMathBench(版本202505)對Qwen2.5進行了測試。LiveMathBench是一個在Qwen2.5發佈後纔出現的“乾淨”基準測試,這意味着Qwen2.5不可能在訓練過程中接觸過其中的數據。在這一全新的數據集上,Qwen2.5的完成率驟降至零,與Llama模型表現相當,其答案准確率也僅剩2%。

研究指出,Qwen2.5可能已在大型在線數據集上進行了預訓練,其中包括了包含基準問題及其解決方案的GitHub代碼庫。因此,即使在訓練期間接收到隨機或錯誤的獎勵信號,模型也能因爲事先接觸過這些數據而提升其在MATH-500上的表現。

響應模板變化與合成數據驗證

進一步的實驗表明,當響應模板發生變化時,Qwen2.5模型在MATH-500上的性能會急劇下降,而Llama-3.1-8B幾乎不受影響。這進一步支持了Qwen2.5對特定數據模式的依賴性。

爲徹底排除記憶效應,研究團隊還創建了RandomCalculation數據集,其中包含Qwen2.5發佈後生成的完全合成的算術問題。在這些新問題上,Qwen2.5的準確率隨着問題複雜度的增加而下降。只有正確的獎勵信號才能提高模型表現,而隨機獎勵會導致訓練不穩定,反向獎勵甚至會降低其數學技能。受控的RLVR(可驗證獎勵的強化學習)實驗也證實了這些結果:只有正確的獎勵才能帶來穩定的性能提升,隨機或反向獎勵則無法提高或主動降低性能。

對未來AI研究的啓示

這些發現對Qwen2.5的數學能力是否反映真實推理能力提出了嚴重質疑,反而表明該模型嚴重依賴於記憶數據。阿里巴巴於2024年9月推出了Qwen2.5,隨後又推出了Qwen3系列。這項研究的發現是否適用於Qwen3系列,仍有待觀察。

該研究的作者警告稱,受污染的基準測試可能導致關於人工智能進展的誤導性結論。他們強調,未來的研究應依賴於乾淨、未受污染的基準,並評估多個模型系列以獲得更可靠的結果。

基準測試的“遊戲規則”

研究結果再次凸顯了在大型語言模型中區分真實推理與記憶的難度,以及爲何嚴謹、清晰的評估方法對於可靠的人工智能研究至關重要。此前已有研究表明,基準測試可能被操縱或“玩弄”。例如,Meta曾提交一個經過專門調優的Llama4版本,通過使用自定義響應格式在LMArena基準測試中表現優異。其他研究也顯示,Gemini2.5Pro和Claude3.5Sonnet等模型能夠以高達95%的準確率識別測試場景並調整其響應,這引發了對當前評估方法有效性的更廣泛質疑。