在人工智能領域,又一重磅消息傳來。今天凌晨,知名大模型訓練平臺 Together.ai 與 Agentica 聯合推出了開源 AI Agent框架 DeepSWE。這一創新系統是基於阿里最新開源的 Qwen3-32B 模型,完全通過強化學習進行訓練。

DeepSWE 的開源信息可在 Hugging Face 上獲取,除了模型權重外,訓練方法、日誌和數據集等所有相關內容也一併公開,旨在幫助開發者更深入地學習和改進這一代理系統。

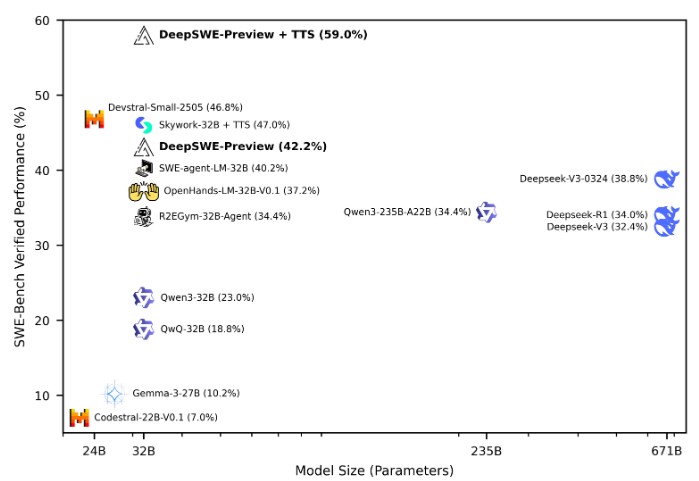

根據 SWE-Bench-Verified 測試結果,DeepSWE 在64k 的最大上下文長度和100的最大環境步驟下評估,經過16次運行,Pass@1準確率達到了42.2%。經過混合測試後,其性能更是提升至59%,使其在所有開源代理框架中位列榜首。

DeepSWE 的訓練採用了 rLLM 框架,這是一個專門用於語言智能體後期訓練的系統。它在64個 H100GPU 上,對來自 R2E-Gym 訓練環境的4500個真實世界軟件工程任務進行了爲期6天的訓練。這些任務包括解決 GitHub 問題、實現新代碼功能和調試等,展示了現實世界軟件工程的多樣性。

在訓練過程中,DeepSWE 通過與環境的互動,學習如何在廣泛的代碼庫中進行瀏覽、針對性編輯代碼、運行構建和測試的 shell 命令,並在處理實際拉取請求時優化解決方案。數據集管理方面,使用了 R2E-Gym 子集中的4500個問題,確保了訓練數據的純淨性和相關性。

訓練環境圍繞 R2E-Gym 構建,支持可擴展的高質量可執行軟件工程環境。獎勵機制則採用稀疏結果獎勵模型,只有當生成的補丁通過所有測試時纔給予正獎勵,促進了更有效的學習。

DeepSWE 的訓練還採用了改進版的 GRPO++ 算法,通過整合多項創新,實現了更穩定和高效的訓練過程。此外,研究人員還發現,在針對軟件工程任務時,增加輸出 token 數量的效果不明顯,而通過滾動數量擴展則顯著提升了模型性能。

這一系列的努力,使得 DeepSWE 成爲了一款極具潛力的 AI 代理系統,推動了強化學習在實際應用中的進步。

開源地址:https://huggingface.co/agentica-org/DeepSWE-Preview

劃重點:

🌟 DeepSWE 是基於 Qwen3-32B 模型,完全通過強化學習訓練而成,開源信息已全面發佈。

🏆 在 SWE-Bench-Verified 測試中,DeepSWE 表現出色,Pass@1準確率達到了59%,成爲所有開源代理中的佼佼者。

💡 採用了 rLLM 框架和改進的 GRPO++ 算法,DeepSWE 在實際軟件工程任務中展現了其強大的學習能力和應用潛力。