人工知能分野で新たな大きなニュースが届きました。本日午前、有名な大規模モデルトレーニングプラットフォームである Together.ai と Agentica は、オープンソースのAIエージェントフレームワーク DeepSWE を共同でリリースしました。このイノベーションシステムは、アリババが最新に公開した Qwen3-32B モデルを基盤としており、完全に強化学習によってトレーニングされています。

DeepSWE のオープンソース情報は Hugging Face で入手可能です。モデルの重みだけでなく、トレーニング方法やログ、データセットなど、すべての関連内容も公開されており、開発者がこのエージェントシステムをより深く学び、改善するための支援を目的としています。

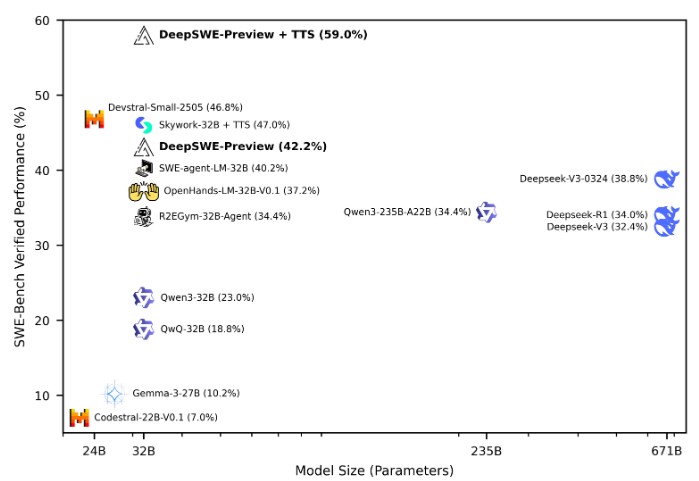

SWE-Bench-Verified テスト結果によると、DeepSWE は最大のコンテキスト長が64k、最大の環境ステップ数が100で評価され、16回の実行を通じて Pass@1 の正確度は42.2%に達しました。混合テスト後には性能がさらに向上し、59%まで上昇し、すべてのオープンソースエージェントフレームワークの中でトップを誇っています。

DeepSWE のトレーニングには rLLM フレームワークが採用されており、これは言語エージェントの後期トレーニングに特化したシステムです。このシステムは、R2E-Gym のトレーニング環境から得られた4,500件のリアルワールドソフトウェアエンジニアリングタスクを6日間、64台の H100 GPU でトレーニングしました。これらのタスクには GitHub の問題解決、新しいコード機能の実装、デバッグなどが含まれており、現実世界のソフトウェアエンジニアリングの多様性を示しています。

トレーニング中に DeepSWE は環境との相互作用を通じて、広範囲なコードベースでのブラウジング、ターゲットコードの編集、ビルドおよびテストのシェルコマンドの実行、実際に処理されるプルリクエストにおいて最適な解決策の最適化などを学びました。データセット管理では R2E-Gym のサブセットに含まれる4,500件の問題を使用しており、トレーニングデータの純粋性と関連性を確保しています。

トレーニング環境は R2E-Gym を中心に構築されており、拡張可能な高品質な実行可能なソフトウェアエンジニアリング環境をサポートしています。報酬メカニズムとしては、生成されたパッチがすべてのテストを通過した場合にのみ正の報酬を与える、スパースな結果報酬モデルが採用されています。これにより、より効率的な学習が促進されます。

DeepSWE のトレーニングには改良版の GRPO++ アルゴリズムが採用されており、いくつかの革新を統合することで、より安定かつ効率的なトレーニングプロセスを実現しました。また、研究者たちはソフトウェアエンジニアリングタスクに対して出力トークン数を増やす効果はそれほど大きくない一方、ローリング数の拡張によりモデルの性能が顕著に向上することを発見しました。

こうした取り組みにより、DeepSWE は非常に有望な AI エージェントシステムとなり、強化学習の実際応用における進歩を推進しています。

オープンソースの場所: https://huggingface.co/agentica-org/DeepSWE-Preview

重要なポイント:

🌟 DeepSWE は Qwen3-32B モデルに基づいており、完全に強化学習によってトレーニングされており、オープンソース情報が全面的に公開されています。

🏆 SWE-Bench-Verified テストにおいて、DeepSWE は優れた性能を発揮し、Pass@1 の正確度は59%に達し、すべてのオープンソースエージェントの中でもトップクラスとなっています。

💡 rLLM フレームワークと改良された GRPO++ アルゴリズムを採用している DeepSWE は、現実的なソフトウェアエンジニアリングタスクにおいてその強い学習能力と応用可能性を示しています。