字節跳動旗下PICO-MR團隊正式開源了**EX-4D**,一款突破性的4D視頻生成框架。這款工具能夠從單一視角(單目)視頻生成高質量、多視角的4D視頻序列(3D空間+時間維度),標誌着視頻生成技術邁向了新的里程碑。EX-4D不僅在技術指標上超越現有開源方法,還爲沉浸式3D內容創作和“世界模型”構建提供了關鍵支持。以下是AIbase對這一前沿技術的深入解讀。

**技術突破:從單目視頻到自由視角**

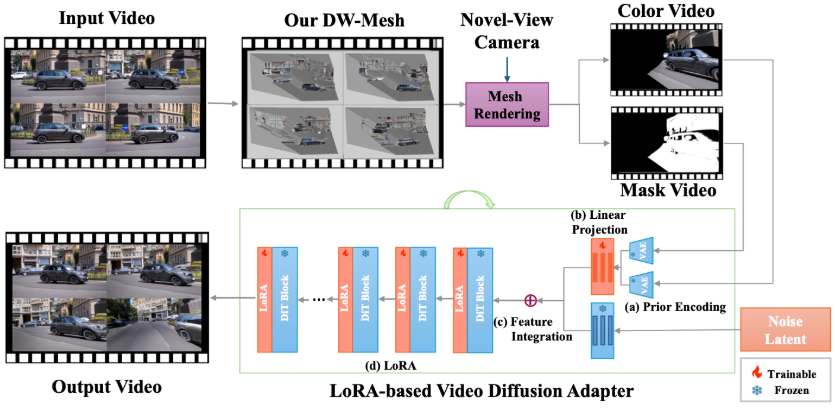

傳統視頻生成技術在多視角生成方面面臨兩大挑戰:一是需要昂貴的多視角相機和數據集進行訓練;二是難以處理遮擋區域,導致生成的視頻在極端視角下出現物體穿幫或細節失真。EX-4D通過創新的**深度密閉網格(DW-Mesh)**表示和輕量級適配架構,成功解決了這些問題。

DW-Mesh是EX-4D的核心技術,它通過構建全密閉網格結構,記錄場景中的可見和隱形面片,無需多視角監督即可統一處理複雜場景拓撲。結合預訓練深度預測模型,EX-4D將單幀像素投影到3D空間,形成網格頂點,並根據幾何關係精準標記遮擋區域。這種方法確保了生成視頻在極端視角(如±90°)下仍能保持物理一致性和細節完整性。

此外,EX-4D引入了兩種模擬mask生成策略——**渲染mask**和**跟蹤mask**,通過模擬視角移動和幀間一致性,破解了多視角訓練數據的稀缺難題。這些策略使EX-4D僅憑單目視頻即可“腦補”全視角數據,極大降低了數據採集成本。

**性能表現:指標全面領先**

EX-4D在性能測試中展現了卓越表現。基於包含150個網絡視頻的數據集,EX-4D在**FID(弗雷歇距離)**、**FVD(弗雷歇視頻距離)**和**VBench**等行業標準指標上全面超越現有開源方法。尤其在極端視角(如接近90°)的生成任務中,EX-4D的性能優勢尤爲明顯,生成的視頻在物體細節和遮擋邏輯上表現更爲真實。

在一項由50位志願者參與的主觀評估中,70.7%的參與者認爲EX-4D在極端視角下的物理一致性遠超其他開源方法。這表明EX-4D不僅在技術指標上領先,也在實際應用中獲得了用戶的高度認可。

字節跳動將EX-4D完全開源,代碼和相關文檔已發佈在GitHub上,爲全球開發者提供了免費訪問的機會。這一舉措不僅體現了字節跳動對開源社區的貢獻,也爲沉浸式3D電影、虛擬現實(VR)、增強現實(AR)等領域的創新應用奠定了基礎。

EX-4D基於預訓練的WAN-2.1模型,結合**LoRA-based Adapter**架構,在保持計算效率的同時,融入了DW-Mesh的幾何先驗信息,確保生成視頻的幾何一致性和幀間連貫性。這種輕量級設計使得EX-4D在資源受限的環境下也能高效運行,適合廣泛的開發場景。

EX-4D的發佈被視爲構建“世界模型”的重要進展。相比傳統的單向視頻生成模型,EX-4D賦予了用戶自由探索視頻內容的能力,類似在“平行宇宙”中切換視角。這種相機可控的4D生成技術爲沉浸式內容創作提供了無限可能,例如交互式3D電影、虛擬旅遊和遊戲開發。

字節跳動PICO-MR團隊負責人表示,EX-4D是團隊在3D重建與4D場景生成領域多年研究的結晶,未來將繼續優化模型性能,探索更廣泛的應用場景。AIbase認爲,EX-4D的開源將加速AI視頻生成技術的普及,推動多模態AI在創意產業中的落地。

網站:https://github.com/tau-yihouxiang/EX-4D