在人工智能領域,尤其是生成式對抗網絡(AIGC)方面的不斷進展,語音交互已成爲一個重要的研究方向。傳統的大語言模型(LLM)主要專注於文本處理,無法直接生成自然語音,這在一定程度上影響了人機音頻交互的流暢性。

爲了突破這一侷限,Step-Audio 團隊開源了一款全新的端到端語音大模型 ——Step-Audio-AQAA。該模型能夠直接從原始音頻輸入生成自然流暢的語音輸出,使得人機交流更加自然。

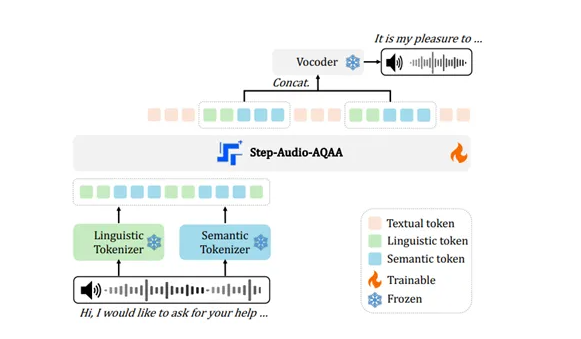

Step-Audio-AQAA 的架構由三個核心模塊組成:雙碼本音頻標記器、骨幹 LLM 和神經聲碼器。其中,雙碼本音頻標記器負責將輸入的音頻信號轉化爲結構化的標記序列。這個模塊分爲語言標記器和語義標記器,前者提取語言的結構化特徵,後者則捕捉語音的情感和語調等副語言信息。通過這種雙碼本設計,Step-Audio-AQAA 能夠更好地理解語音中的複雜信息。

接下來,這些標記序列會被送入骨幹 LLM,即 Step-Omni。這是一款預訓練的1300億參數的多模態模型,具備處理文本、語音和圖像的能力。該模型採用瞭解碼器架構,可以高效地處理來自雙碼本音頻標記器的標記序列,通過深度的語義理解和特徵提取,爲後續生成自然語音做好準備。

最後,生成的音頻標記序列會被送入神經聲碼器。該模塊的作用是將離散的音頻標記合成爲高質量的語音波形,採用了 U-Net 架構,以確保在音頻處理中的高效性和準確性。通過這種創新的架構設計,Step-Audio-AQAA 能夠在聽懂音頻問題後,迅速合成自然、流暢的語音回答,爲用戶提供了更好的交互體驗。

這項技術的發展代表着人機音頻交互的一個重要進步,開源的 Step-Audio-AQAA 不僅爲研究者提供了一個強大的工具,也爲未來的智能語音應用打下了堅實的基礎。

開源地址:https://huggingface.co/stepfun-ai/Step-Audio-AQAA

劃重點:

🔊 Step-Audio 團隊開源的 Step-Audio-AQAA 可以直接從音頻輸入生成自然語音,提升人機交互體驗。

📊 模型架構由雙碼本音頻標記器、骨幹 LLM 和神經聲碼器三個模塊組成,能夠高效捕捉語音中的複雜信息。

🎤 Step-Audio-AQAA 的推出標誌着語音交互技術的重要進展,爲未來智能語音應用提供了新思路。