人工知能分野において、特に生成型対抗ネットワーク(AIGC)に関する進展により、音声インタラクションは重要な研究分野となっています。従来の大規模言語モデル(LLM)は主にテキスト処理に焦点を当てており、直接自然な音声を生成することはできません。これは人間と機械の音声インタラクションのスムーズさに一定の影響を与えています。

この制限を打破するために、Step-Audioチームは、新たなエンドツーエンドの音声大規模モデルであるStep-Audio-AQAAをオープンソースとして公開しました。このモデルは、元の音声入力から自然で滑らかな音声出力を直接生成することができ、人間と機械のコミュニケーションをより自然にしています。

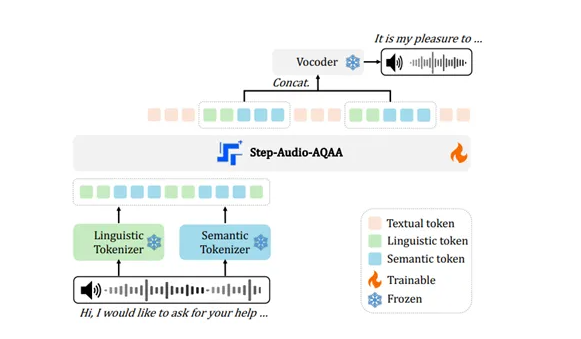

Step-Audio-AQAAのアーキテクチャは、3つのコアモジュールで構成されています:ダブルコードブック音声タグラー、骨格LLM、ニューラルボイサー。そのうち、ダブルコードブック音声タグラーは、入力された音声信号を構造化されたタグシーケンスに変換します。このモジュールは言語タグラーと意味タグラーの2つに分けられ、前者は言語の構造的特徴を抽出し、後者は音声の感情やトーンなどの副言語情報を捉えます。このようなダブルコードブック設計により、Step-Audio-AQAAは音声内の複雑な情報をよりよく理解することができます。

次に、これらのタグシーケンスは、骨格LLMであるStep-Omniに送られます。これは、1300億パラメータを持つマルチモーダルモデルであり、テキスト、音声、画像の処理が可能です。このモデルはデコーダー構造を採用しており、ダブルコードブック音声タグラーからのタグシーケンスを効率的に処理します。深い意味理解と特徴抽出を通じて、後の自然な音声生成のために準備されます。

最後に、生成された音声タグシーケンスはニューラルボイサーに送られます。このモジュールは、離散的な音声タグを高品質な音声波形に合成することを目的としており、U-Netアーキテクチャを使用して音声処理における効率性と正確性を確保しています。このような革新的なアーキテクチャ設計により、Step-Audio-AQAAは音声質問を理解した後に、自然で滑らかな音声回答を迅速に合成でき、ユーザーにとってより良いインタラクティブ体験を提供します。

この技術の発展は、人間と機械の音声インタラクションにおける重要な進歩を示しています。オープンソースのStep-Audio-AQAAは、研究者に強力なツールを提供するだけでなく、将来のスマート音声アプリケーションの基盤を築くことにも貢献しています。

オープンソースの場所: https://huggingface.co/stepfun-ai/Step-Audio-AQAA

ポイント:

🔊 Step-Audioチームがオープンソースとして公開したStep-Audio-AQAAは、音声入力から自然な音声を直接生成でき、人間と機械のインタラクション体験を向上させます。

📊 モデルアーキテクチャは、ダブルコードブック音声タグラー、骨格LLM、ニューラルボイサーの3つのモジュールからなり、音声中の複雑な情報を効率的に捉えます。

🎤 Step-Audio-AQAAの登場は、音声インタラクション技術における重要な進歩を示しており、今後のスマート音声アプリケーションに対して新しいアイデアを提供しています。