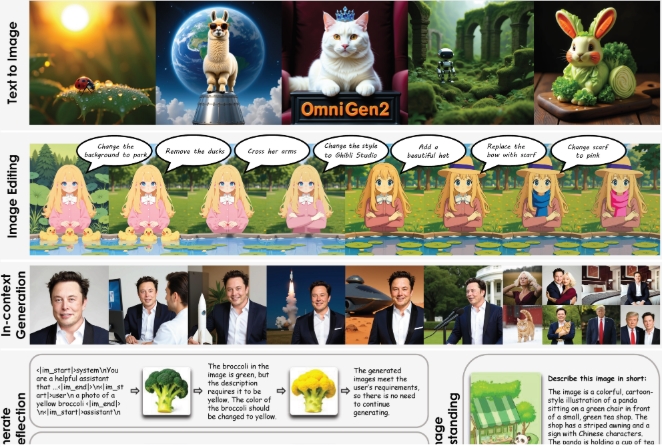

近日,北京人工智能研究院推出了全新的開源系統 ——OmniGen2。這一系統專注於文本到圖像的生成、圖像編輯和上下文圖像創作。

與2024年發佈的第一代 OmniGen 相比,OmniGen2採用了兩條獨立的解碼路徑:一條用於文本生成,另一條用於圖像生成,且各自擁有獨立的參數和解耦的圖像標記器。這種設計讓模型在保持文本生成能力的同時,有效地提升了多模態語言模型的表現。

OmniGen2的核心是一個基於 Qwen2.5-VL-3B 變換器的大型多模態語言模型(MLLM)。在圖像生成方面,該系統使用了一種自定義的擴散變換器,參數量達到約40億。模型在遇到特殊的 “<|img|>” 標記時會自動切換到圖像生成模式。值得一提的是,OmniGen2能夠處理多種提示和藝術風格,但其生成的照片級圖像在清晰度上仍有待提升。

爲了訓練 OmniGen2,研究團隊使用了大約1.4億張來自開源數據集和專有集合的圖像。此外,他們還開發了新技術,通過提取視頻中的相似幀(例如,一個微笑和不微笑的面孔),並利用語言模型生成相應的編輯指令。

OmniGen2的另一大亮點是其反思機制,能夠讓模型自我評估生成的圖像,並在多個輪次中進行改進。該系統可以發現生成圖像中的缺陷,並提出具體的修正建議。

爲了評估該系統的性能,研究團隊引入了 OmniContext 基準測試,包括角色、物體和場景三大類,每類下有八個子任務和各50個示例。評估是通過 GPT-4.1進行的,主要打分標準包括提示的準確性和主題的一致性。OmniGen2的總分爲7.18,超越了所有其他開源模型,而 GPT-4o 的得分爲8.8。

儘管 OmniGen2在多個基準測試中表現優異,但仍存在一些不足之處:英文提示的效果優於中文,身體形態的變化較爲複雜,輸出質量也受到輸入圖像的影響。對於模糊的多圖像提示,系統需要明確的對象放置指示。

研究團隊計劃將模型、訓練數據和構建管道發佈到 Hugging Face 平臺。https://huggingface.co/OmniGen2/OmniGen2

劃重點:

🌟 OmniGen2是一個開源的圖文生成系統,採用獨立的文本和圖像解碼路徑。

🎨 它能夠處理多種藝術風格的圖像生成,並具備自我反思和改進功能。

📈 OmniGen2在多個基準測試中表現出色,特別是在圖像編輯方面創下了新的開放源代碼模型紀錄。