近日,VectorSpaceLab在Hugging Face平臺正式開源全能多模態模型OmniGen2,以創新性雙組件架構和強大的視覺處理能力,爲研究者和開發者提供了高效的可控生成式AI基礎工具。

這款模型由30億參數的視覺語言模型(VLM)Qwen-VL-2.5與40億參數的擴散模型組合而成,通過凍結的VLM解析視覺信號和用戶指令,結合擴散模型實現高質量圖像生成,在視覺理解、文本生成圖像、指令引導圖像編輯和上下文生成四大核心場景中展現出領先性能。

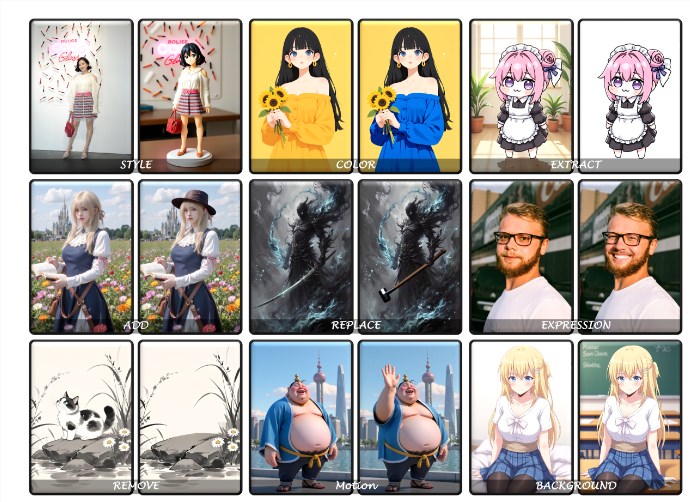

作爲開源項目,OmniGen2的視覺理解能力繼承自Qwen-VL-2.5的強大基礎,可精準解析圖像內容;其文本生成圖像功能支持從文本提示生成高保真、符合美學標準的圖像;在指令引導圖像編輯領域,該模型以高精度完成複雜修改任務,性能達到開源模型中的前沿水平;而上下文生成能力更可靈活處理人物、物體、場景等多元輸入,生成連貫新穎的視覺輸出。

例如,用戶既能通過自然語言指令讓熊貓手持茶杯的卡通場景變換風格,也能爲奇幻精靈角色添加動態背景,甚至修正圖像中物體數量或顏色衝突等細節。

目前,OmniGen2已開放模型權重下載,並提供Gradio和Jupyter在線演示,支持用戶通過調整採樣步數、文本引導強度、圖像參考權重等超參數優化生成效果。

項目團隊計劃後續開源訓練代碼、數據集及構建流程,並推出上下文生成基準測試OmniContext,進一步完善CPU負載優化和多框架集成。隨着多模態AI應用場景的持續擴展,OmniGen2憑藉其資源效率與功能全面性,正爲個性化視覺創作、智能設計輔助等領域開闢新的技術路徑。

地址:https://huggingface.co/OmniGen2/OmniGen2