このたび、VectorSpaceLabはHugging Faceプラットフォームで、全能型のマルチモーダルモデル「OmniGen2」を正式にオープンソース化しました。イノベーティブな二部構造アーキテクチャと強力な視覚処理能力により、研究者や開発者に効率的な制御可能な生成AIのベースツールを提供しています。このモデルは、30億パラメータを持つ視覚言語モデル(VLM)であるQwen-VL-2.5と、40億パラメータを持つ拡散モデルから構成されており、固定されたVLMによって視覚信号とユーザーの指示を解析し、拡散モデルを使って高品質な画像生成が可能です。視覚理解、テキストによる画像生成、指示に基づく画像編集、文脈生成という4つの主要なシナリオにおいて、優れた性能を発揮しています。

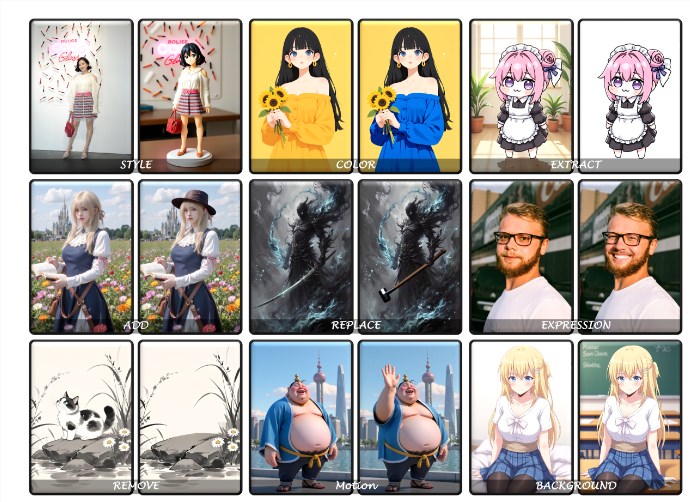

オープンソースプロジェクトとして、OmniGen2の視覚理解能力はQwen-VL-2.5の強力な基盤を引き継いでおり、画像コンテンツを正確に解析できます。テキストによる画像生成機能では、テキストプロンプトから高精細で美学基準に合った画像を生成できます。指示に基づく画像編集分野では、このモデルは高い精度で複雑な修正作業を実行し、オープンソースモデルの中でも先進的な性能を持っています。また、文脈生成機能は人物、物体、場面など多様な入力を柔軟に処理し、一貫性があり新鮮な視覚出力を生成できます。

例えば、ユーザーは自然言語の指示によって、パンダが茶カップを持っているコマーシャル風のシーンを別のスタイルに変換したり、ファンタジーの精霊キャラクターに動的な背景を追加したり、あるいは画像内のオブジェクトの数や色の衝突などの詳細を修正したりすることができます。