在人工智能領域,DeepSeek 團隊於近日發佈了最新研究成果,推出了一種名爲 NSA(Native Sparse Attention)的創新稀疏注意力機制。這項技術的核心目標是提升長上下文訓練和推理的速度,特別是針對現代硬件進行了優化,使得訓練和推理的效率大幅提升。

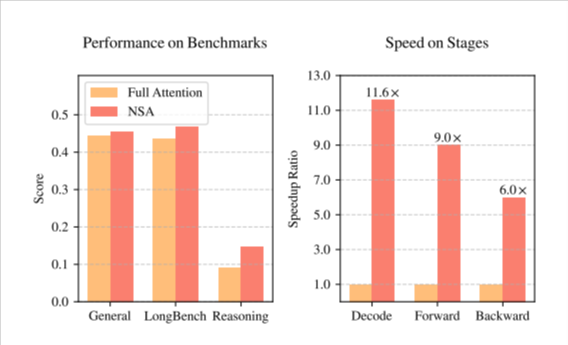

NSA 技術的推出,爲人工智能模型的訓練帶來了顯著的變化。首先,它通過一系列針對現代計算硬件特性的設計優化,顯著提升了推理速度,並有效降低了預訓練的成本。更重要的是,在提升速度和降低成本的同時,NSA 仍然保持了高水平的模型性能,確保了模型在多種任務中的表現不受影響。

DeepSeek 團隊在其研究中採用了一種分層的稀疏策略,將注意力機制劃分爲三個分支:壓縮、選擇和滑動窗口。這種設計使得模型能夠同時捕捉全局上下文和局部細節,從而提高了模型對長文本的處理能力。此外,NSA 在內存訪問和計算調度方面的優化,使得長上下文訓練的計算延遲和資源消耗得以大幅降低。

在一系列通用基準測試中,NSA 展示了其優異的性能。特別是在長上下文任務和基於指令的推理上,NSA 的表現甚至與完全注意力模型相當,部分情況下更勝一籌。這一技術的發佈,標誌着 AI 訓練和推理技術的又一次飛躍,將爲未來的人工智能發展帶來新的動力。

NSA 論文(https://arxiv.org/pdf/2502.11089v1)。

劃重點:

🌟 NSA 技術的推出顯著提升了長上下文訓練和推理的速度,並降低了預訓練成本。

🛠️ 採用分層稀疏策略,將注意力機制分爲壓縮、選擇和滑動窗口,增強了模型對長文本的處理能力。

📈 在多項基準測試中,NSA 表現優異,部分情況下超過了傳統的完全注意力模型。