2025年1月20日,DeepSeek 宣佈推出其首個通過強化學習 (RL) 訓練的推理模型 DeepSeek-R1,該模型在多個推理基準測試中取得了與 OpenAI-o1-1217相當的性能。 DeepSeek-R1基於 DeepSeek-V3-Base 模型,並採用了多階段訓練和冷啓動數據來提高推理能力。

DeepSeek 的研究人員首先開發了 DeepSeek-R1-Zero,這是一個完全通過大規模強化學習訓練的模型,沒有任何監督微調的預備步驟。DeepSeek-R1-Zero 在推理基準測試中展現出卓越的性能,例如在 AIME2024考試中,其 pass@1分數從15.6% 提升至71.0%。然而,DeepSeek-R1-Zero 也存在一些問題,例如可讀性差和語言混雜。

爲了解決這些問題並進一步提升推理性能,DeepSeek 團隊開發了 DeepSeek-R1。DeepSeek-R1在強化學習之前引入了多階段訓練和冷啓動數據。 具體而言,研究人員首先收集了數千個冷啓動數據對 DeepSeek-V3-Base 模型進行微調。 然後,他們像訓練 DeepSeek-R1-Zero 一樣進行了面向推理的強化學習。 在強化學習過程接近收斂時,他們通過對強化學習檢查點進行拒絕抽樣創建了新的監督微調數據,並結合 DeepSeek-V3在寫作、事實問答和自我認知等領域中的監督數據,然後重新訓練 DeepSeek-V3-Base 模型。 最後,使用所有場景的提示對微調後的檢查點進行額外的強化學習。

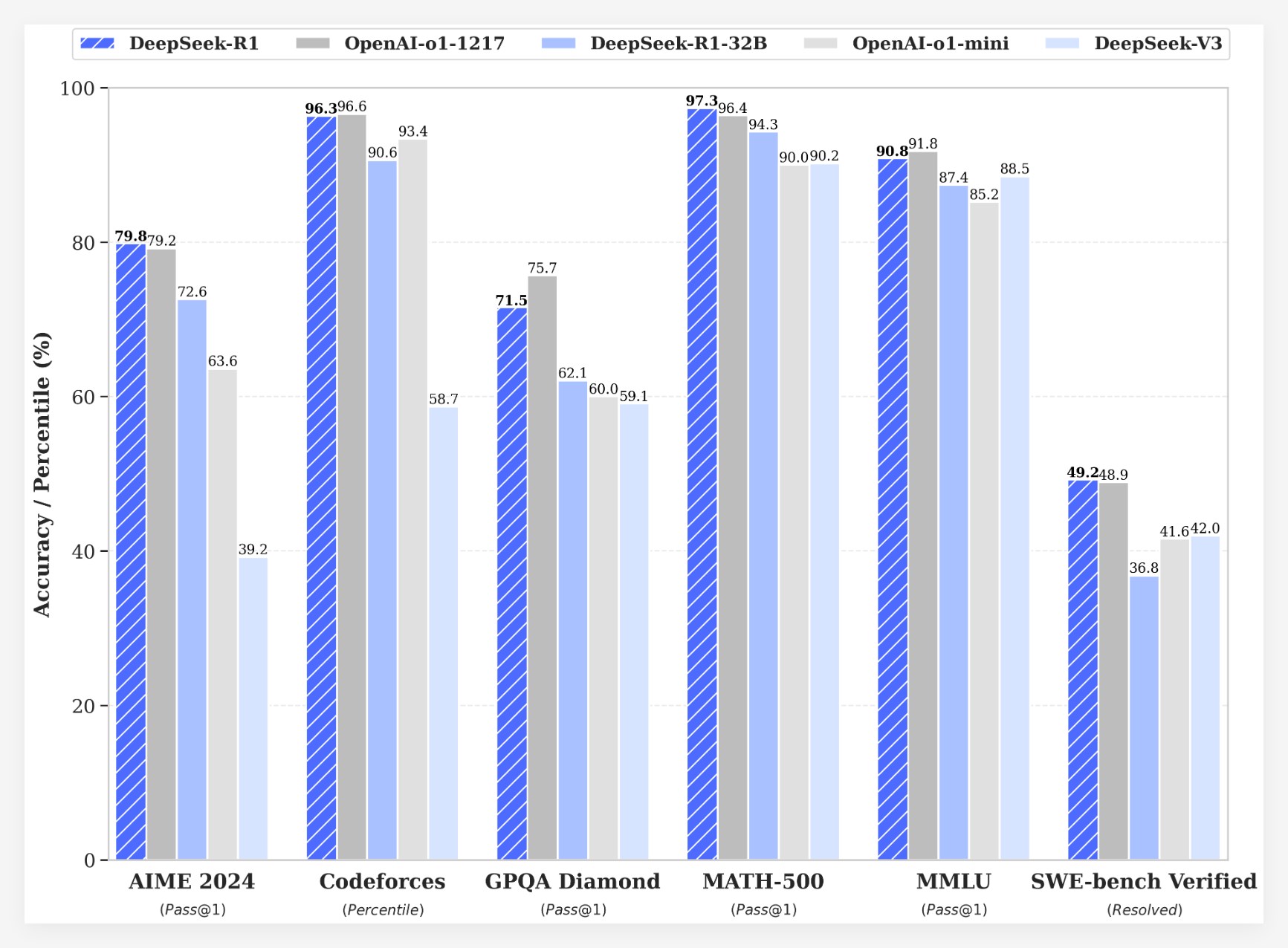

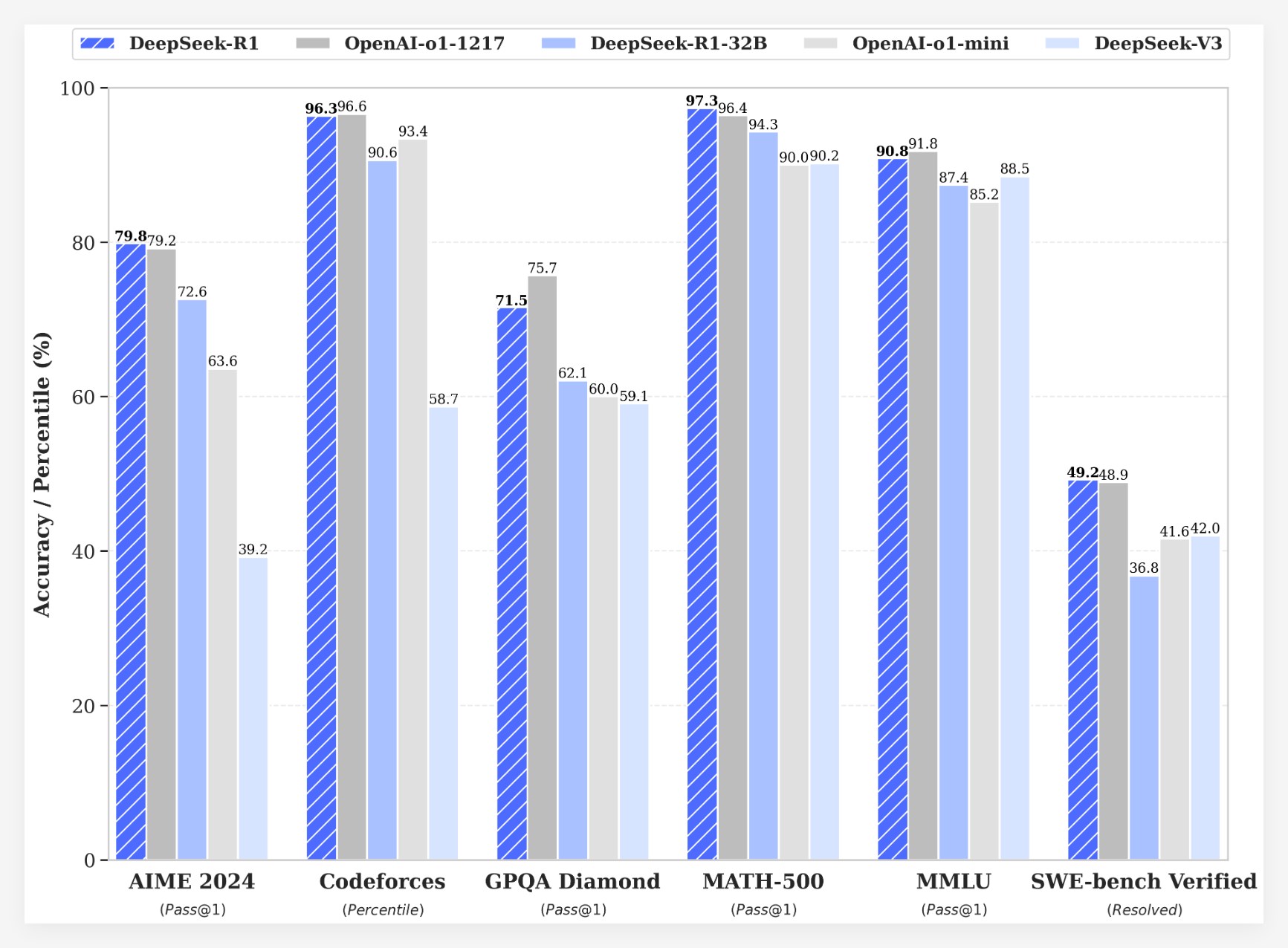

DeepSeek-R1在多個基準測試中取得了令人矚目的成績:

•在 AIME2024考試中,DeepSeek-R1的 pass@1分數達到了79.8%,略高於 OpenAI-o1-1217。

•在 MATH-500考試中,DeepSeek-R1的 pass@1分數達到了97.3%,與 OpenAI-o1-1217持平。

•在代碼競賽任務中,DeepSeek-R1在 Codeforces 上獲得了2029的 Elo 評級,超過了96.3% 的人類參賽者。

•在知識基準測試(如 MMLU、MMLU-Pro 和 GPQA Diamond)中,DeepSeek-R1的得分分別爲90.8%、84.0% 和71.5%,顯著優於 DeepSeek-V3。

•在其他任務(如創意寫作、一般問答、編輯、摘要等)中,DeepSeek-R1也表現出色。

此外,DeepSeek 還探索了將 DeepSeek-R1的推理能力蒸餾到更小的模型中。研究發現,直接從 DeepSeek-R1進行蒸餾比在小型模型上應用強化學習的效果更好。 這表明大型基礎模型發現的推理模式對於提高推理能力至關重要。DeepSeek 已開源了 DeepSeek-R1-Zero、DeepSeek-R1以及基於 Qwen 和 Llama 的六個從 DeepSeek-R1蒸餾的密集模型(1.5B、7B、8B、14B、32B、70B)。 DeepSeek-R1的推出,標誌着強化學習在提高大型語言模型推理能力方面取得了重大進展。

成本優勢

在成本方面,DeepSeek-R1提供了極具競爭力的定價策略。其 API 訪問定價爲每百萬輸入令牌0.14美元(緩存命中)和0.55美元(緩存未命中),輸出令牌每百萬2.19美元。這一價格策略相比其他同類產品更具吸引力,被用戶形容爲“遊戲規則改變者”。目前官方網站和 API 現已上線!訪問 https://chat.deepseek.com 就可以體驗 DeepThink!

社區反饋與未來展望

DeepSeek-R1的發佈引發了社區的熱烈討論。許多用戶對模型的開源特性和成本優勢表示讚賞,認爲其爲開發者提供了更多的選擇和自由。然而,也有用戶對模型的上下文窗口大小提出疑問,希望未來版本能夠進一步優化。

DeepSeek 團隊表示,他們將繼續致力於提升模型的性能和用戶體驗,同時計劃在未來推出更多功能,包括高級數據分析,以滿足用戶對 AGI(通用人工智能)的期待。