Mistral公司近日宣佈推出其最新的開源編碼模型——Codestral25.01,這是其備受歡迎的編碼模型Codestral的升級版。這一版本在架構上進行了優化,顯著提升了性能,成爲其“重量級編碼的明顯領導者”,速度比前版提升了兩倍。

與原版Codestral相似,Codestral25.01依然專注於低延遲和高頻率操作,支持代碼校正、測試生成以及中間填充任務。Mistral公司表示,這一版本特別適合需要更多數據和模型駐留的企業。基準測試顯示,Codestral25.01在Python編碼測試中的表現超出預期,HumanEval測試得分爲86.6%,遠超前版、Codellama70B Instruct以及DeepSeek Coder33B Instruct。

開發人員可以通過Mistral IDE插件以及本地部署工具Continue來訪問該模型,此外,Mistral還提供了通過Google Vertex AI和Mistral la Plateforme訪問API的方式。該模型目前在Azure AI Foundry上提供預覽,並將在不久後登陸Amazon Bedrock平臺。

自去年發佈以來,Mistral的Codestral已成爲以代碼爲核心的開源模型中的佼佼者。其首版Codestral是一個22B參數的模型,支持多達80種語言,並在編碼性能上優於許多同類產品。緊接着,Mistral推出了Codestral-Mamba,這是一個基於Mamba架構的代碼生成模型,能夠處理更長的代碼串並應對更多的輸入需求。

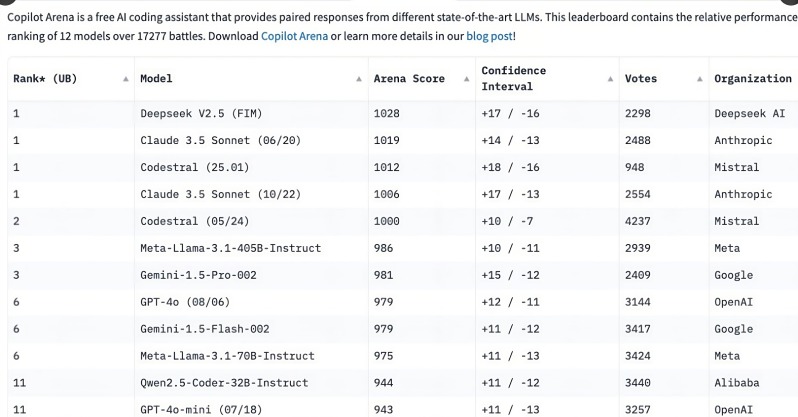

Codestral25.01的推出引發了開發者的廣泛關注,在發佈後的短短几個小時內便在C o pilot Arena排行榜上位居前列。這一趨勢表明,專門化的編碼模型正在迅速成爲開發人員的首選,尤其是在編碼任務領域,相較於多功能通用模型,專注型編碼模型的需求愈加明顯。

儘管像OpenAI的o3和Anthropic的Claude這樣的通用模型也能進行編碼,但專門優化的編碼模型在性能上往往更爲出色。過去一年內,多個企業發佈了針對編碼的專用模型,例如阿里巴巴的Qwen2.5-Coder和中國DeepSeek Coder,後者更是成爲首個超越GPT-4Turbo的模型。此外,微軟也推出了基於專家混合模型(MOE)的GRIN-MoE,該模型不僅能編碼,還能解決數學問題。

儘管開發者仍在爭論選擇通用模型還是專注模型,但編碼模型的快速崛起顯現了對於高效、精準編碼工具的巨大需求。憑藉專爲編碼任務訓練的優勢,Codestral25.01無疑在未來的編碼領域佔據了一席之地。