根據雲安全公司Checkmarx發佈的一項全球研究顯示,儘管15%的公司明確禁止使用AI編程工具,但幾乎所有的開發團隊(99%)仍在使用這些工具。這種現象反映了在實際開發過程中,控制生成式AI使用的難度。

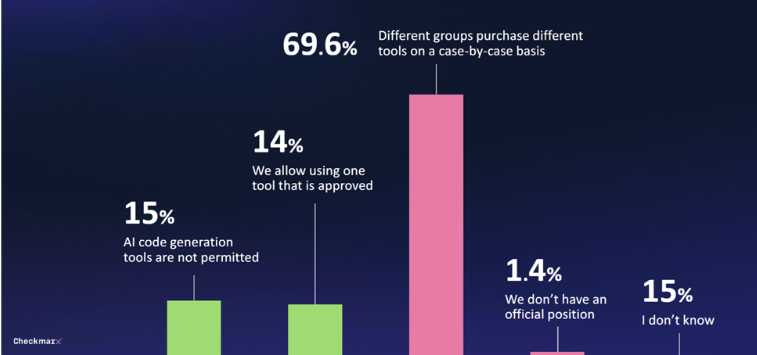

研究發現,僅有29%的公司對生成式AI工具建立了任何形式的治理體系。70%的公司沒有制定中央策略,各個部門的採購決策往往是臨時性的,缺乏統一的管理。

隨着越來越多的開發者使用AI編程工具,安全問題也日益引起關注。80%的受訪者擔心開發者使用AI可能帶來的潛在威脅,其中60%特別擔憂AI可能出現的“幻覺”問題。

儘管存在這些擔憂,許多人仍對AI的潛力抱有興趣。47%的受訪者願意讓AI在無人監督的情況下進行代碼更改,而只有6%的人表示完全不信任AI在軟件環境中的安全措施。

Checkmarx的首席產品官Kobi Tzruya指出:“全球CISO的迴應揭示了開發者正在使用AI進行應用開發,儘管這些AI工具無法可靠地創建安全代碼,這意味着安全團隊要應對大量新產生的、可能存在漏洞的代碼。”

微軟的工作趨勢指數報告也顯示,許多員工在沒有提供AI工具的情況下,會使用自己的AI工具,往往不會公開討論這一點,這阻礙了生成式AI在業務流程中的系統性實施。

劃重點:

1. 🚫 **15%的公司禁止AI編程工具,但99%的開發團隊仍在使用**

2. 📊 **只有29%的公司對生成式AI工具建立了治理體系**

3. 🔐 **47%的受訪者願意讓AI進行無人監督的代碼更改**