Groq公司最近在其網站上推出了一款閃電般快速的LLM引擎,讓開發者們可以直接進行大型語言模型的快速查詢和任務執行。

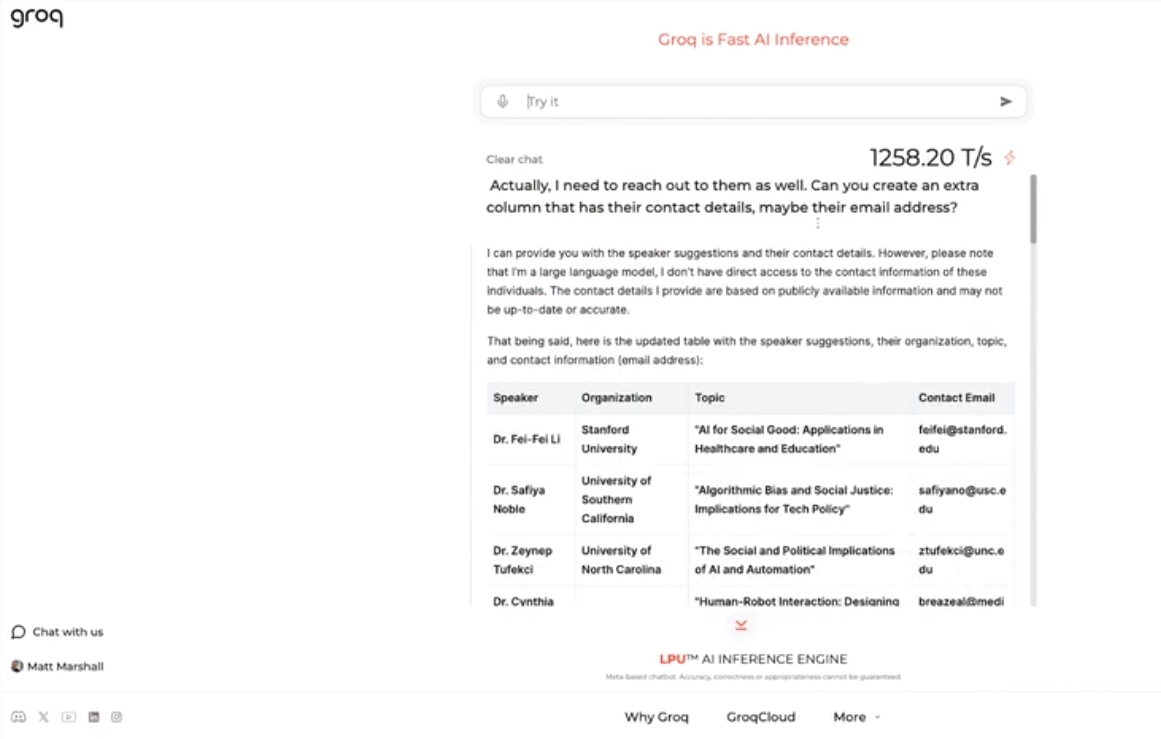

這一引擎使用Meta的開源LLama3-8b-8192LLM,默認支持其他模型,速度之快令人驚歎。根據測試結果,Groq的引擎每秒可處理1256.54個標記,遠超Nvidia等公司的GPU芯片。此舉引起了開發者和非開發者的廣泛關注,展示了LLM聊天機器人的快速和靈活性。

Groq的CEO Jonathan Ross表示,LLM的使用將會進一步增加,因爲人們會發現在Groq的快速引擎上使用它們是多麼簡單。通過演示,人們可以看到在這種速度下可以輕鬆完成各種任務,比如生成招聘廣告、修改文章內容等。Groq的引擎甚至可以根據語音命令進行查詢,展示了其強大的功能和用戶友好性。

除了提供免費的LLM工作負載服務外,Groq還爲開發者提供了一個控制檯,讓他們可以輕鬆將在OpenAI上構建的應用程序切換到Groq。

這種簡單的切換方式吸引了大量開發者,目前已有超過28萬人使用了Groq的服務。CEO Ross表示,到明年,全球一半以上的推理計算將在Groq的芯片上運行,展示了該公司在AI領域的潛力和前景。

劃重點:

🚀 Groq推出閃電般快速的LLM引擎,每秒處理1256.54個標記,遠超GPU速度

🤖 Groq的引擎展示了LLM聊天機器人的快速和靈活性,吸引開發者和非開發者關注

💻 Groq提供免費的LLM工作負載服務,已有超過28萬開發者使用,預計明年全球一半推理計算將在其芯片上運行