本日、小米は身体的モデルMiMo-Embodiedを正式に発表し、このモデルが全面的にオープンソースとなることを発表しました。この動きは、小米が汎用的身体的知能研究分野で重要な一歩を踏み出したことを示しています。

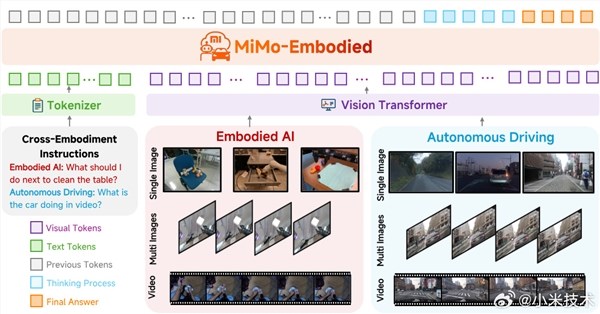

身体的知能が家庭環境での実装が進み、自動運転技術がスケールアップする中で、ロボットと車両がどのように認知と能力の共有をより良く行えるか、室内作業の知能と室外運転の知能がお互いに促進できるかという問題が業界内で急務となっています。今回の小米が発表したMiMo-Embodiedモデルはこれらの課題に対応して開発され、自動運転と身体的知能の二つの分野をつなぎ、タスクの統一モデリングを実現し、「垂直領域専用」から「領域間能力協調」への重要な飛躍を果たしました。

MiMo-Embodiedモデルには3つの主要な技術的な特徴があります。まず、このモデルは領域間の能力をカバーしており、身体的知能の三大コアタスクである可用性推論、タスク計画、空間理解、そして自動運転の三大キーワークである環境認識、状態予測、ドライビングプランニングを同時にサポートし、すべてのシーンにおけるスマートさを強力に支えています。次に、このモデルは室内インタラクション能力と道路意思決定能力の知識移転協調効果を検証し、シナリオ間のスマート融合に新たなアイデアを提供しています。最後に、MiMo-Embodiedは「身体的/自動運転能力学習CoT推論強化RL細かい強化学習」の多段階トレーニング戦略を使用し、リアルな環境での展開の信頼性を効果的に向上させています。

パフォーマンスにおいて、MiMo-Embodiedは感知、意思決定、および計画を含む29の主要ベンチマークテストでオープンソースベースモデルの性能の新しい基準を確立し、既存のオープンソースモデル、クローズドソースモデル、および専用モデルを全面的に上回っています。身体的知能分野では、このモデルは17のベンチマークテストでSOTAの成績を収め、タスク計画、可用性予測、空間理解の能力の境界を再定義しました。自動運転分野では、12のベンチマークテストで優れた性能を発揮し、環境認識、状態予測、ドライビングプランニングの全フローでのパフォーマンスの突破を実現しました。さらに、一般視覚言語分野でも優れた汎化性を示し、一般的な認識と理解能力を固めた上で、複数の主要ベンチマークで顕著なパフォーマンスの飛躍を達成しました。

オープンソースの場所:

https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B