小米のマルチモーダル大規模モデルチームは、最新のマルチモーダル大規模モデル「Xiaomi MiMo-VL-7B-2508」をオープンソース化したことを発表しました。このモデルにはRLとSFTの2つのバージョンが含まれています。

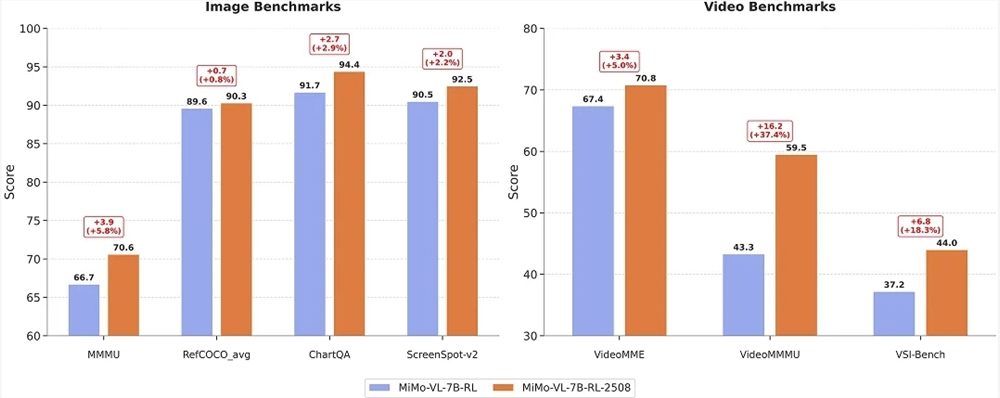

公式データによると、新バージョンのモデルは学問的推論、ドキュメント理解、グラフィックインターフェースの位置特定、ビデオ理解の4つの主要な能力において記録をすべて更新しました。その中で、MMMUベンチマークは初めて70点を超え、ChartQAは94.4に達し、ScreenSpot-v2は92.5、VideoMMEは70.8に上昇しました。

今回のアップデートにより、強化学習の安定性と監督型微調整プロセスが最適化され、モデルの内部VLM Arenaスコアは1093.9から1131.2へと急騰しました。

特に注目すべきは、ユーザーが質問する際、「/no_think」というコマンドを使用して「思考モード」と「非思考モード」を自由に切り替えることができる点です。前者ではすべての推論プロセスを表示し、制御成功率は100%ですが、後者では直接答えを生成し、応答が速く、成功率は99.84%です。

MiMo-VL-7B-RL-2508

ほとんどの場合でこのモデルを体験することをお勧めします。

オープンソースのアドレス: https://huggingface.co/XiaomiMiMo/MiMo-VL-7B-RL-2508

MiMo-VL-7B-SFT-2508

ユーザーは実際のニーズに応じて、このモデルを基にSFTやRLを行うことができます。前のバージョンのSFTモデルと比較して、このモデルはより高いRLの安定性を持っています。

オープンソースのアドレス: https://huggingface.co/XiaomiMiMo/MiMo-VL-7B-SFT-2508