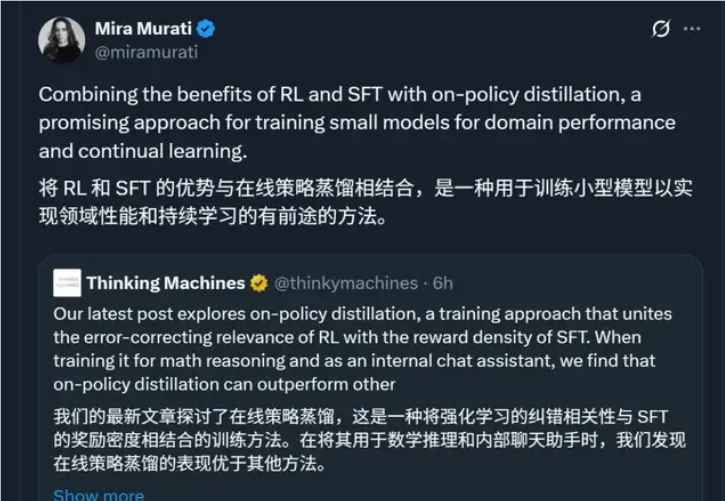

最近、AIの新興チームであるThinking Machineは、画期的なトレーニング方法である「オンライン戦略蒸留(On-Policy Distillation)」を発表しました。これにより、特定のタスクにおいて小規模モデルのトレーニング効率が最大で50〜100倍向上しました。この成果は発表された瞬間から、元OpenAIのCTOであるMira Murati氏によって直接リツイートされ、学界と産業界からの高い注目を集めました。

強化学習と監督学習を融合し、「AIコーチ」の新しいモデルを構築

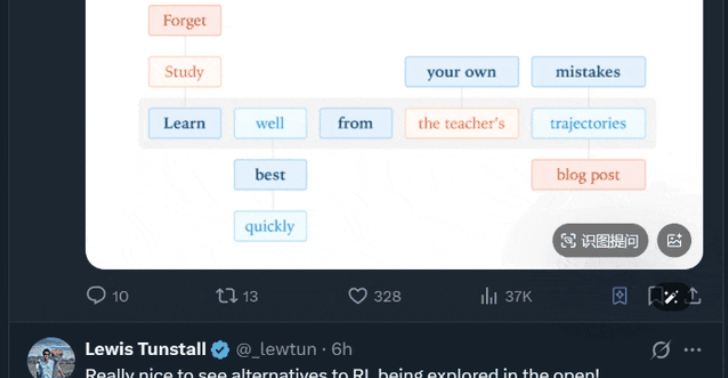

従来のAIトレーニングでは二律背反に直面していました。強化学習は試行錯誤を通じてモデルを自己学習させますが、柔軟性はあるものの効率が低いです。一方、監督微調整は標準的な答えを直接提供するため効率的ですが、柔軟性がありません。一方、オンライン戦略蒸留はこれらの両方を巧みに融合します。まるで学生モデルに「リアルタイムのコーチ」をつけるようなものです。学生モデルが自らコンテンツを生成しながら、強力な教師モデルがその出力を動的に評価・指導し、両者のKLダイバージェンスを最小限に抑えることで、正確で安定した知識移転を実現します。

このメカニズムは、従来の蒸留で「結果だけ学び、プロセスは学ばない」という欠点を回避し、モデルが「裏技」や過適合に陥るのを効果的に防ぎ、汎化能力を大幅に向上させます。

実測効果は驚異的:ステップ数が7〜10分の1、効率が100倍に向上

数学的推論タスクにおいて、研究チームは従来の強化学習法の1/7〜1/10のトレーニングステップ数で、8Bの小さなモデルを32Bの大規模モデルに近い性能レベルに達成させました。全体の計算コストは最大で2桁減少しました。これは、資源が限られている中小企業や研究チームでも、大手企業と同等の専門モデルを効率的にトレーニングできるようになったことを意味しています。

さらに重要なのは、この方法が企業でのAI導入における「災害的忘却(Catastrophic Forgetting)」の問題を成功裏に解決したことです。ある企業アシスタントの実験では、モデルが新しい業務知識を学ぶ同時にもとの会話やツール呼び出しの能力を完全に保持していたのです。これは、継続的なアップデートが可能な業界向けAIシステムにとって実現可能な道を示しています。

核心チームの背景は厚く、技術はOpenAIの実戦経験から生まれたもの

この研究はKevin Luによって主導されました。彼は以前、OpenAIで複数の重要なプロジェクトを率いていました。現在、Thinking Machineの核心メンバーとして、大規模モデルのトレーニングの最新知見を効率的な小規模モデル生態系に還元しています。そのチームは、AIが垂直化・シーン化していく今、「小規模だが専門的」なモデルこそがビジネスの実装の主力であり、オンライン戦略蒸留はその道を開く鍵であると考えています。

算力のボトルネックがますます顕在化する中、業界は「大規模モデル一辺倒」から「効率的でスマートな」新たな範式へと移行しています。Thinking Machineのこの突破は、AI開発の障壁を大幅に低減するだけでなく、高コストパフォーマンスの専門モデルの時代が加速して訪れる兆しだと示唆しています。

論文:https://thinkingmachines.ai/blog/on-policy-distillation/