大規模言語モデルの競争において、数学およびコード推論能力は重要な評価基準となっています。快手が最近公開したKlear-Reasonerモデルは、Qwen3-8B-Baseを基盤としており、複数の権威あるベンチマークテストで優れた成績を収めています。数学的推論の正確率は90%を突破し、同規模のモデルの中で最も優れたものとなっています。

Klear-Reasonerの成功は、GPPO(Gradient-Preserving Clipping Policy Optimization)アルゴリズムの採用にあります。このアルゴリズムは、トレーニングの安定性を保ちながら、モデルの探索能力を著しく向上させました。従来のカット戦略は、モデルの更新幅を制御し、トレーニングプロセスの安定性を確保するものの、「重要な情報を失う」問題があり、モデルが保守的になる傾向がありました。一方、GPPOは「やさしい」方法で、すべての勾配を逆伝播に参加させ、探索の可能性を保持しつつ、誤りの修正速度を速めています。

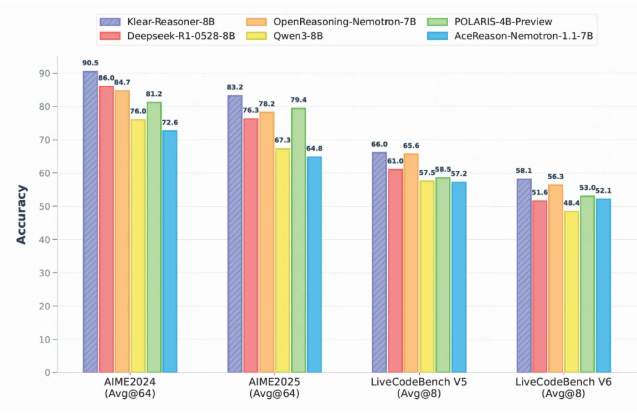

さまざまなベンチマークテストにおいて、Klear-Reasonerは他の同規模のオープンソースモデルを上回る実力を示しています。例えば、AIME2024テストでは90.5%の高い点数を獲得し、AIME2025テストでも83.2%という優れた成績を収めました。Klearチームは、トレーニングの詳細なプロセスを共有しており、データ品質への注力、難易度の高いサンプルでのエラーの保持戦略、ソフト報酬を使ってモデルの学習効率を高めるなど、重要な要素について述べています。

注目すべきは、Klearチームが実験で優れたデータソースの質が量よりも重要であることに気づいたことです。SFT段階では、誤ったデータをフィルタリングし、高品質なサンプルに焦点を当てることで、モデルのトレーニング効率を向上させることができます。また、チームは強化学習段階でソフト報酬戦略を使用することがハード報酬よりも効果的であり、モデルの学習安定性を高めることができると指摘しました。

Klear-Reasonerの公開は、快手がAI分野で技術進歩を遂げていることを示すだけでなく、推論モデルのトレーニングに対して再現可能な道を提供しています。この成果は、今後の研究と開発にとって貴重な経験と洞察を提供します。

Hugging Faceアドレス:https://huggingface.co/Suu/Klear-Reasoner-8B

GitHubアドレス:https://github.com/suu990901/KlearReasoner/tree/main

ポイント:

🌟 Klear-Reasonerモデルは数学的推論の正確率が90%を超え、8Bモデルの中でリーダーとなっています。

🧠 GPPOアルゴリズムはモデルの探索能力を向上させ、従来のカット戦略の隠れた問題を解決しました。

📈 データ品質とトレーニング戦略に注目し、Klearチームの研究は推論モデルに対する効果的なトレーニング方法を提供しています。