在大語言模型的競爭中,數學和代碼推理能力已成爲一項重要的評估標準。快手最近發佈的 Klear-Reasoner 模型基於 Qwen3-8B-Base 打造,其在多個權威基準測試中表現出色,數學推理的準確率甚至突破了90%,成爲同規模模型中的佼佼者。

Klear-Reasoner 的成功源於其採用的 GPPO(Gradient-Preserving Clipping Policy Optimization)算法。這種算法在保證訓練穩定性的同時,顯著提升了模型的探索能力。傳統的裁剪策略雖然能控制模型的更新幅度,確保訓練過程的穩定性,但也存在着 “丟棄重要信息” 的問題,導致模型變得保守。而 GPPO 則通過一種 “溫和” 的方式,讓所有梯度參與反向傳播,既保留了探索的可能性,又加快了模型對錯誤的修正速度。

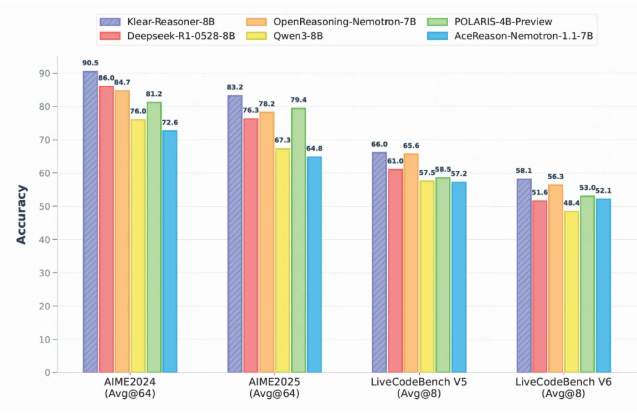

在各類基準測試中,Klear-Reasoner 都展現出超越其他同規模開源模型的強勁實力。例如,在 AIME2024測試中,該模型取得了90.5% 的高分,而在 AIME2025測試中,也達到了83.2% 的優秀成績。Klear 團隊還分享了其訓練的詳細流程,包括對數據質量的重視、在高難樣本中保留錯誤的策略、使用軟獎勵來提高模型的學習效率等關鍵環節。

值得注意的是,Klear 團隊在實驗中發現,優質數據源的質量往往比數量更爲重要。在 SFT 階段,通過過濾錯誤數據並專注於高質量樣本,可以提升模型的訓練效率。此外,團隊還指出在強化學習階段,使用軟獎勵策略比硬獎勵更爲有效,能夠增強模型的學習穩定性。

Klear-Reasoner 的發佈不僅展示了快手在 AI 領域的技術進步,也爲推理模型的訓練提供了一條可復現的道路。這一成果爲未來的研究和開發提供了寶貴的經驗和啓示。

Hugging Face地址:https://huggingface.co/Suu/Klear-Reasoner-8B

GitHub地址:https://github.com/suu990901/KlearReasoner/tree/main

劃重點:

🌟 Klear-Reasoner 模型在數學推理準確率上突破90%,成爲8B 模型中的領軍者。

🧠 GPPO 算法提升了模型的探索能力,解決了傳統裁剪策略的隱性問題。

📈 關注數據質量和訓練策略,Klear 團隊的研究爲推理模型提供了有效的訓練方法。