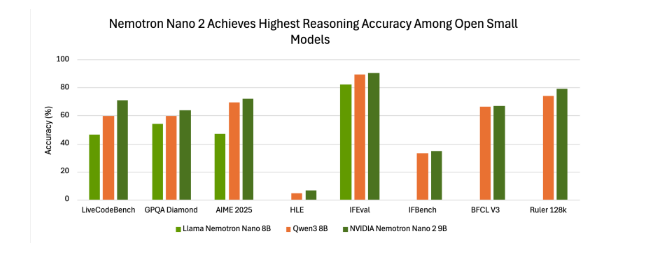

小規模モデルが大きな波を巻き起こしており、NVIDIAも後れを取ることはありません。マサチューセッツ工科大学とグーグルがスマートウォッチやスマートフォンで動作する小さなAIモデルを発表した後、NVIDIAは最新の小規模言語モデル(SLM)であるNemotron-Nano-9B-V2をリリースしました。このモデルは複数のベンチマークテストで優れた性能を示し、特定のテストでは業界最高水準に達しています。

効率性と推論のために設計されたモデル

Nemotron-Nano-9B-V2は90億パラメータを持ち、一部の数百万パラメータのマイクロモデルよりも大きく、以前の120億パラメータバージョンより大幅に小さくなっています。また、これは単一のNVIDIA A10 GPUに特化して最適化されています。NVIDIA AIモデルの後学習責任者であるOleksii Kuchiaev氏は、この調整が人気のあるA10というデプロイGPUに対応させるためであると説明しています。さらに、Nemotron-Nano-9B-V2は混合モデルであり、より大きなバッチ処理が可能で、同規模のTransformerモデルより6倍速く動作します。

このモデルは最大9つの言語をサポートしており、中国語、英語、ドイツ語、フランス語、日本語、韓国語などが含まれます。また、コマンドトラッキングやコード生成タスクにも強みを持っています。予トレーニングデータセットおよびモデル自体は、Hugging FaceとNVIDIAのモデルディレクトリで公開されています。

TransformerとMambaアーキテクチャの統合

Nemotron-Nano-9B-V2はNemotron-Hシリーズに基づいており、このシリーズはMambaとTransformerのアーキテクチャを統合しています。従来のTransformerモデルは強力ですが、長文の処理には大量のメモリと計算リソースを消費します。一方、Mambaアーキテクチャは選択的な状態空間モデル(SSM)を導入し、線形複雑さで長文情報を処理できるため、メモリや計算コストにおいて優れた利点を持っています。Nemotron-Hシリーズは、大部分の注意層を線形状態空間層に置き換えることで、長い文脈処理において2〜3倍のスループット向上を実現しつつ、高い精度を維持しています。

独自の推論制御機能

このモデルの大きな革新点は、ユーザーがモデルが出力する最終的な答えの前に自己チェックを行うことができる「推論」機能が内蔵されていることです。ユーザーは簡単なコントロール文字(例:`/think` または `/no_think`)を使ってこの機能を有効・無効にすることができます。また、モデルは実行中の「思考予算」管理をサポートしており、開発者は内部推論に使用されるトークン数を制限することで、正確性と遅延のバランスを取ることができます。この機能は、カスタマーサポートや自律エージェントなど、応答速度が求められる用途にとって非常に重要です。

厳格なオープンライセンス、企業向けに設計

NVIDIAはそのオープンモデルライセンス協定に基づいてNemotron-Nano-9B-V2をリリースしました。この協定は企業に対して親切で、非常に柔軟です。NVIDIAは明確に、企業がこのモデルを商業目的で自由に使用このモデルを使用する際の費用や著作権料を支払う必要がない