Qwen3-4Bシリーズモデルのリリースを発表しました。この新しいモデルはコンパクトなサイズと強力な性能により、人工知能のエッジデバイスへの展開に新たな可能性をもたらします。

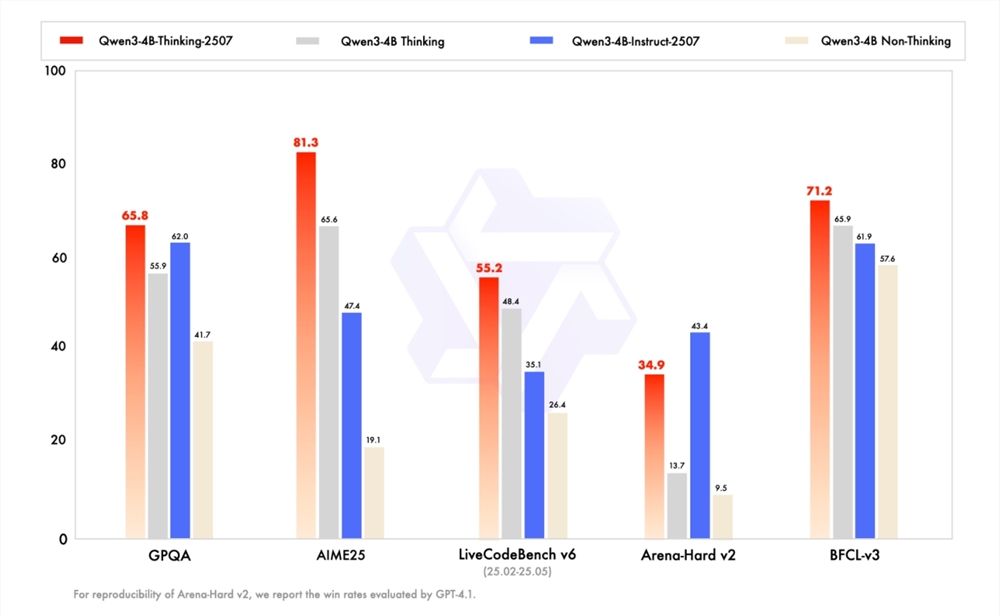

前週に続いてQwen3-235B-A22BおよびQwen3-30B-A3BのInstruct/Thinking「2507」バージョンを更新した後、研究開発チームはさらに力を入れて、より小型のQwen3-4B-Instruct-2507およびQwen3-4B-Thinking-2507モデルをリリースしました。これらの新モデルは性能面で大幅な向上を遂げており、特に非推論分野ではQwen3-4B-Instruct-2507が閉鎖的なGPT4.1-Nanoを全面的に上回っています。また、推論分野ではQwen3-4B-Thinking-2507の性能は目覚ましく、中規模のQwen3-30B-A3B(thinking)と同等の推論能力を備えています。

研究開発チームは、小規模言語モデル(SLM)がエージェント型人工知能(Agentic AI)の発展において非常に重要な価値を持つと考えています。今回のリリースされた「2507」バージョンのQwen3-4Bモデルは、小さくて高性能であり、スマートフォンなどのエッジデバイスでの展開に非常に適しています。現在、新モデルは魔搭コミュニティとHugging Faceで公開されており、多くの開発者から注目されています。

Qwen3-4B-Instruct-2507の汎用性は大幅に向上し、商業的な閉鎖型の小規模モデルであるGPT-4.1-nanoを上回り、中規模のQwen3-30B-A3B(non-thinking)とほぼ同等の性能を発揮しています。さらに、このモデルはより多くの言語の長尾知識をカバーしており、主観的かつオープンなタスクにおいて人間の好みの一致を強化し、人々のニーズに合った回答を提供することができます。驚くべきことに、その文脈理解能力は256Kまで拡張され、小さなモデルでも長文を簡単に処理できます。

一方で、Qwen3-4B-Thinking-2507の推論能力も大幅に向上しました。数学能力に焦点を当てたAIME25テストでは、4Bパラメータで驚異的なスコアである81.3点を達成し、中規模モデルのQwen3-30B-Thinkingと同等の性能を示しています。また、汎用性も大幅に向上し、エージェントスコアはより大きなQwen3-30B-Thinkingモデルを上回っています。同じく256Kトークンの文脈理解能力を持ち、複雑なドキュメント分析や長文の生成、段落を超えた推論などのシナリオに対応できます。

Qwen3-4Bシリーズモデルのリリースにより、人工知能のエッジデバイスでの応用の将来性はさらに広がりました。近い将来、このモデルに基づく多くのイノベーションアプリケーションが登場し、人々の生活や仕事に多くの利便性をもたらすことを信じています。