通義千問宣佈Qwen3-4B系列模型的發佈。這一新模型以其小巧的體積和強大的性能,爲人工智能的端側部署帶來了新的可能性。

在前兩週相繼更新了Qwen3-235B-A22B和Qwen3-30B-A3B的Instruct/Thinking「2507」版本後,研發團隊再次發力,推出了更小尺寸的Qwen3-4B-Instruct-2507和Qwen3-4B-Thinking-2507模型。這些新模型在性能上取得了顯著提升,特別是在非推理領域,Qwen3-4B-Instruct-2507全面超越了閉源的GPT4.1-Nano,而在推理領域,Qwen3-4B-Thinking-2507的表現更是令人矚目,其推理能力可與中等規模的Qwen3-30B-A3B(thinking)相媲美。

研發團隊堅信,小型語言模型(SLM)對代理人工智能(Agentic AI)的發展具有極其重要的價值。此次發佈的「2507」版本Qwen3-4B模型,不僅體積小,性能強勁,而且對手機等端側硬件部署極爲友好。目前,新模型已在魔搭社區和Hugging Face正式開源,吸引了衆多開發者的關注和體驗。

Qwen3-4B-Instruct-2507的通用能力得到了顯著提升,其表現超越了商業閉源的小尺寸模型GPT-4.1-nano,甚至與中等規模的Qwen3-30B-A3B(non-thinking)性能接近。此外,該模型還覆蓋了更多語言的長尾知識,在主觀和開放性任務中增強了人類偏好對齊,能夠提供更符合人們需求的答覆。更令人驚喜的是,其上下文理解能力擴展至256K,即使是小模型,也能輕鬆處理長文本。

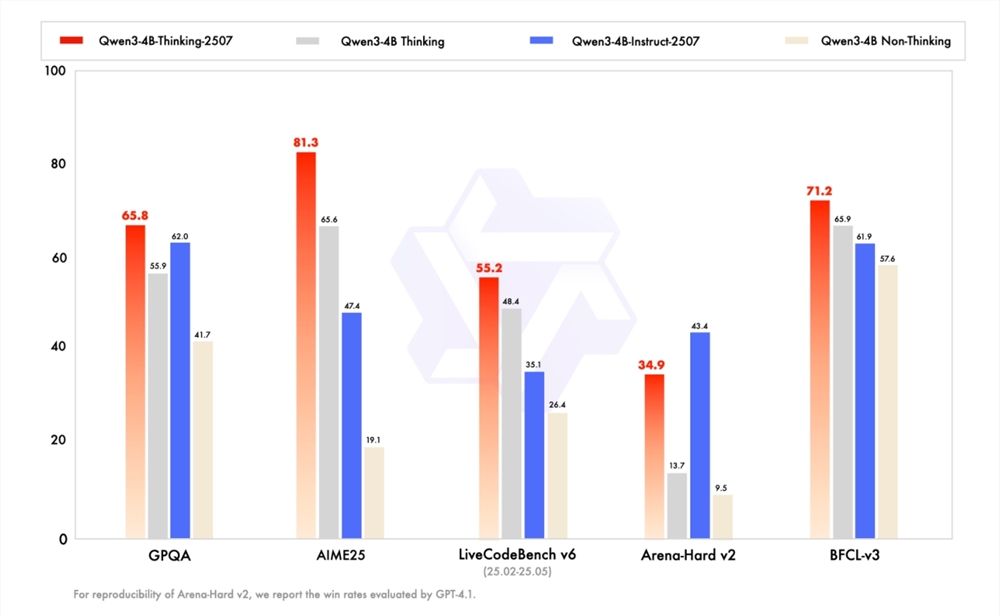

與此同時,Qwen3-4B-Thinking-2507的推理能力也大幅增強。在聚焦數學能力的AIME25測評中,該模型以4B參數量斬獲了81.3分的驚人成績,這一表現足以媲美中等模型Qwen3-30B-Thinking。此外,其通用能力也顯著提升,Agent分數更是超越了更大尺寸的Qwen3-30B-Thinking模型。同樣具備256K tokens的上下文理解能力,支持更復雜的文檔分析、長篇內容生成以及跨段落推理等場景。

隨着Qwen3-4B系列模型的發佈,人工智能在端側應用的前景變得更加廣闊。相信在不久的將來,我們會看到更多基於這一模型的創新應用,爲人們的生活和工作帶來更多便利。