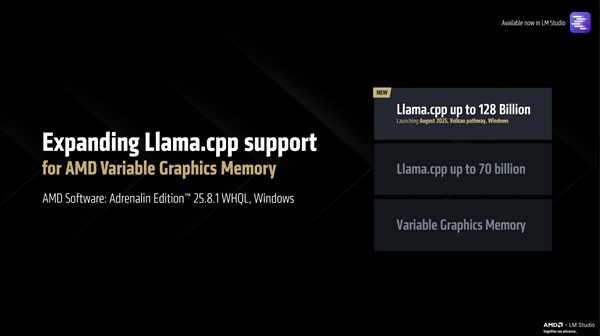

技術が急速に発展する現代において、AMDは再びトレンドをリードし、Zen5アーキテクチャを基盤とするRyzen AI Max+395を発表しました。このプロセッサは業界の先駆けであり、ローカルで700億パラメータの大規模AIモデルを実行できる最初のプラットフォームです。そして現在、AMDは重要なアップグレードを発表し、Ryzen AI Max+395は最大で1280億パラメータの大規模モデルをローカルで実行することが可能となりました。これにより、AI分野での応用可能性がさらに広がりました。

このような性能を実現するためには、Ryzen AI Max+395は128GBの統一メモリを搭載する必要があります。そのうち96GBはVRAMとして割り当てられる必要があります。また、Vulkan llama.cpp環境で動作する必要があり、これにより開発者にとってより大きな柔軟性が提供されます。新たなアップグレードにより、Ryzen AI Max+395は最初に1090億パラメータのMeta Llama4Sout大規模モデルを実行できるプラットフォームとなりました。このモデルは66GBのサイズを持ち、VisionやMCPなどの高度な機能をサポートしています。

今回のアップグレードの核となるのは、混合エキスパート(MoE)モードです。このモードでは、モデルの一部のみがアクティブ化されるため、パフォーマンスを維持しつつ、リソース消費を大幅に削減できます。実際のテストでは、Ryzen AI Max+395は秒間15トークンの処理速度を達成しており、非常に優れた性能を発揮しています。また、68GBのサイズ、1230億パラメータのMistral Largeモデル、および他のいくつかの小規模モデル、例えば18GB、300億パラメータのQwen3A3Bや17GB、270億パラメータのGoogle Gemmaもサポートしています。

さらに驚くべき点は、Ryzen AI Max+395がコンテキスト処理において質的な飛躍を遂げたことです。最大で256,000トークンのコンテキスト長をサポートしており、より複雑なデータ情報を処理・分析することが可能になります。一般的な大規模モデルでは32,000トークンのコンテキストで十分ですが、今回のアップグレードにより、以前は高価な機器が必要だった超大規模なコンテキスト処理も、AMD製品で簡単に実現できるようになりました。

価格面では、Ryzen AI Max+395と128GBメモリを搭載したミニAIワークステーションの価格は現在1万3000元前後まで下がっており、コストパフォーマンスが大幅に向上しています。これは、高級AIアプリケーションへのアクセス障壁を大きく低下させています。