大規模言語モデル(LLM)の分野において、テキストデータの分解は常に重要な研究テーマです。従来のトークン化技術、例えばバイトペアエンコーディング(Byte Pair Encoding)は、通常、テキスト処理前に固定された単位に分割し、それに基づいて静的な語彙リストを構築します。この方法は広く使用されていますが、限界もあります。トークン化が完了すると、モデルの処理方法は柔軟に調整できず、低リソース言語や特殊な文字構造を持つテキストに対しては効果が不十分であることが多いです。

これらの問題を解決するために、Metaの研究チームはAU-Netという革新的なアーキテクチャを発表しました。AU-Netは、自己回帰的なU-Net構造により、従来のテキスト処理パターンを変革し、直接元のバイトから学習し、バイトを柔軟に単語や語句、さらには最大4つの単語の組み合わせにまとめ、多層的な順序表現を形成することができます。

AU-Netの設計は、医療画像セグメンテーションの分野で知られるU-Netアーキテクチャからインスピレーションを得ています。収縮パスと拡張パスという独自の構造を持ち、収縮パスは入力のバイトシーケンスを圧縮し、より高次の意味ユニットに統合して、テキストの全体的な意味を抽出します。一方、拡張パスはこれらの高次の情報を段階的に復元し、元のシーケンス長に戻しながら、局所的な詳細情報を融合させ、モデルがさまざまなレベルでテキストの重要な特徴を捉えることを可能にします。

AU-Netの収縮パスは複数の段階に分けられています。最初の段階では、モデルは直接元のバイトを処理し、計算の実行可能性を保つために制限された注目メカニズムを使用します。次の段階では、モデルは単語境界でプーリングを行い、バイト情報から単語レベルの意味情報を抽象化します。さらに第三段階では、2つの単語間でプーリング操作を行い、より広範囲の意味情報を捉え、テキストの意味理解を強化します。

拡張パスは圧縮された情報を段階的に復元し、多線形アップサンプリング戦略を採用することで、各位置のベクトルがシーケンス内の相対位置に基づいて調整され、高次の情報と局所的細部の融合が最適化されます。また、ジャンプ接続の設計により、復元中に重要な局所的細部情報を失うことがなくなり、モデルの生成能力と予測精度が向上します。

推論フェーズでは、AU-Netは自己回帰的な生成メカニズムを採用し、生成されたテキストが一貫性があり、正確であることを保証しながら、推論効率も向上させます。この革新的なアーキテクチャは、大規模言語モデルの発展に新しい考え方を提供し、より高い柔軟性と適用性を示しています。

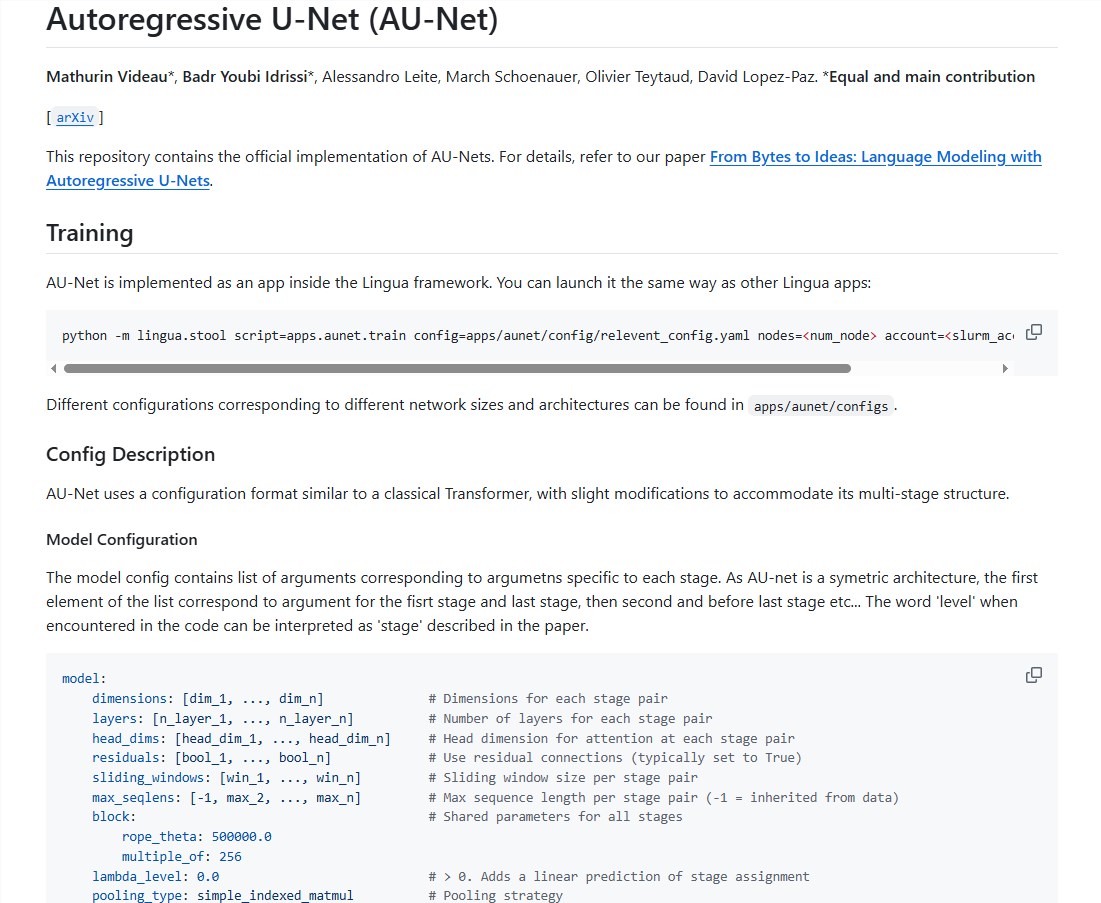

オープンソースの場所: https://github.com/facebookresearch/lingua/tree/main/apps/aunet

ポイント:

- 🚀 AU-Netアーキテクチャは、自己回帰方式を用いて、バイトを動的に組み合わせて多層的な順序表現を形成します。

- 📊 収縮および拡張パスを採用し、全体的な意味情報と局所的な細部の効果的な融合を確保します。

- ⏩ 自己回帰生成メカニズムにより、推論効率を向上させ、テキスト生成の一貫性と正確性を保証します。