国外メディアの報道によると、最新の研究ではアリババのQwen2.5モデルが得た高い数学スコアに疑問を投げかけており、その見かけ上の優れた数学的推論能力が、実際に推論によるものではなく、訓練データへの記憶に起因している可能性があると指摘しています。研究者は一連の厳密なテストを通じて、データ汚染がQwen2.5が特定のベンチマークで優れた性能を発揮する要因であることを明らかにしました。

データ汚染が浮き彫りに:クリーンなベンチマークでの性能急落

この研究の核心的な発見は、Qwen2.5モデルが訓練中に一度も見たことがない「クリーン」なベンチマークでテストされた場合、その性能が急激に低下したことです。これは、モデルが「汚染された」ベンチマークで向上したのは、訓練中にそれらのデータにすでに触れていたためであることを示しています。

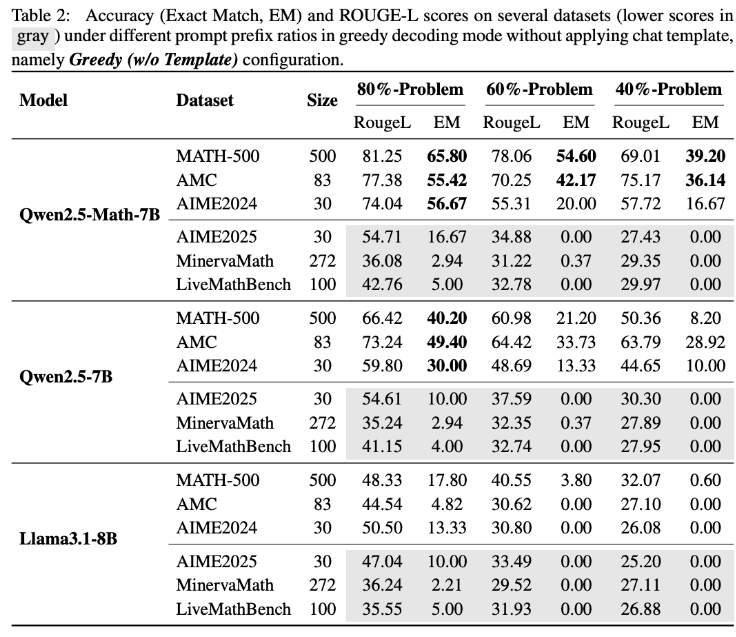

この仮説を検証するために、研究チームは独自の実験を行いました。彼らはQwen2.5-Math-7BモデルにMATH500ベンチマークの前60%の問題のみを提供し、残りの40%を補完させました。その結果は驚くべきものでした。Qwen2.5-Math-7Bは、54.6%(正解率53.6%)の正確さで欠損部分を成功裏に再構築できました。一方、Llama3.1-8Bはわずか3.8%(正解率2.4%)にとどまりました。この大きな差は、Qwen2.5が訓練中にこれらの問題にすでに出会っていたことを強く示唆しています。

LiveMathBenchテスト:Qwen2.5の完成率がゼロに

研究者たちはその後、LiveMathBench(バージョン202505)を使用してQwen2.5をテストしました。LiveMathBenchはQwen2.5のリリース後に登場した「クリーン」なベンチマークであり、Qwen2.5が訓練中にそれらのデータに触れることは不可能です。この新たなデータセットにおいて、Qwen2.5の完成率は急激にゼロになり、Llamaモデルと同様の性能となり、答えの正確率もわずか2%にとどまりました。

研究では、Qwen2.5が大規模なオンラインデータセットで事前学習されており、その中にはベンチマークの問題とその解決策を含むGitHubコードベースが含まれている可能性があると指摘しています。したがって、訓練中にランダムまたは誤った報酬信号を受け取ったとしても、モデルは事前にそれらのデータに触れていたことでMATH-500でのパフォーマンスを向上させることができたと考えられます。

応答テンプレートの変化と合成データの検証

さらに実験の結果、応答テンプレートが変化すると、Qwen2.5モデルのMATH-500でのパフォーマンスが急激に低下する一方、Llama-3.1-8Bはほとんど影響を受けないことが示されました。これは、Qwen2.5が特定のデータパターンに依存していることをさらに支持しています。

記憶効果を完全に排除するため、研究チームはRandomCalculationデータセットを作成しました。このデータセットには、Qwen2.5リリース後に生成された完全な合成算術問題が含まれています。これらの新しい問題に対して、Qwen2.5の正確度は問題の複雑さが増すにつれて低下しました。正しい報酬信号のみがモデルのパフォーマンスを向上させ、ランダムな報酬はトレーニングの不安定さを引き起こし、逆の報酬は数学スキルを低下させることが確認されました。制御されたRLVR(検証可能な報酬を持つ強化学習)実験でも、正しい報酬のみが安定したパフォーマンス向上をもたらすことが確認され、ランダムまたは逆の報酬はパフォーマンスを向上させることも、あるいは悪化させることもできないことが示されました。

今後のAI研究への示唆

これらの発見は、Qwen2.5の数学的能力が本物の推論能力を反映しているのか、それとも単にデータを記憶していたのかに重大な疑問を投げかけています。アリババは2024年9月にQwen2.5をリリースし、その後Qwen3シリーズをリリースしました。この研究の結果がQwen3シリーズにも適用されるかどうかは、今後の観察が必要です。

この研究の著者たちは、汚染されたベンチマークテストが人工知能の進展に関する誤った結論を導く可能性があると警告しています。彼らは、将来の研究がクリーンで汚染されていないベンチマークに依拠すべきであり、複数のモデルシリーズを評価することでより信頼性のある結果を得るべきだと強調しています。