据国外媒体报道, 一项最新研究对阿里巴巴Qwen2.5模型的高数学分数提出了质疑,指出其看似卓越的数学推理能力,可能主要来源于对训练数据的记忆,而非真正的推理。研究人员通过一系列严谨的测试发现,数据污染可能是导致Qwen2.5在某些基准测试中表现优异的关键因素。

数据污染浮出水面:干净基准下性能急剧下降

该研究的核心发现是,当Qwen2.5模型在训练期间从未见过的“干净”基准上进行测试时,其性能出现了急剧下降。这表明模型在“受污染”的基准测试中取得的进步,很大程度上是由于其在训练过程中已经接触过这些数据。

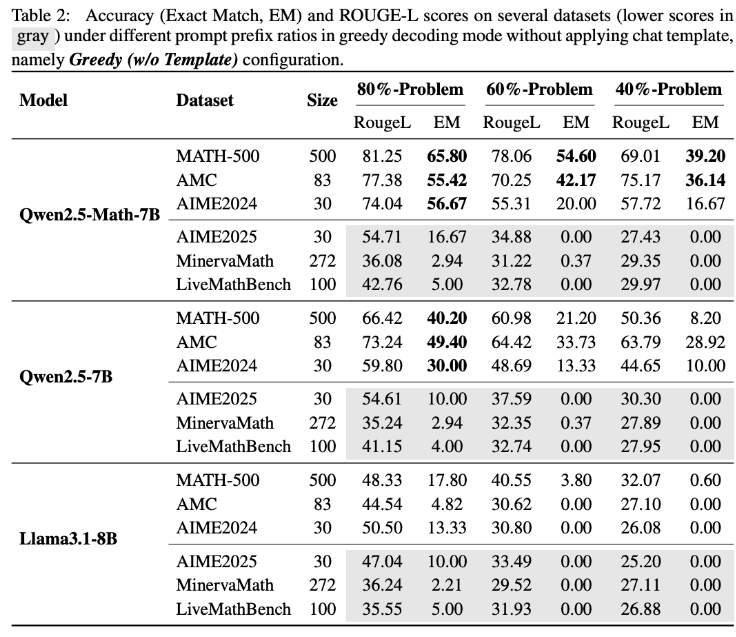

为了验证这一假设,研究团队进行了一项创新性实验:他们仅向Qwen2.5-Math-7B模型提供了MATH500基准测试的前60%题目,并要求其补全剩余的40%。结果令人震惊:Qwen2.5-Math-7B竟能以高达54.6%的准确率(53.6%的正确率)成功重建缺失部分。相比之下,Llama3.1-8B的准确率仅为3.8%(正确率为2.4%)。这一显著差异强烈暗示Qwen2.5在训练过程中已经“见过”这些问题。

LiveMathBench测试:Qwen2.5完成率降至零

研究人员随后使用LiveMathBench(版本202505)对Qwen2.5进行了测试。LiveMathBench是一个在Qwen2.5发布后才出现的“干净”基准测试,这意味着Qwen2.5不可能在训练过程中接触过其中的数据。在这一全新的数据集上,Qwen2.5的完成率骤降至零,与Llama模型表现相当,其答案准确率也仅剩2%。

研究指出,Qwen2.5可能已在大型在线数据集上进行了预训练,其中包括了包含基准问题及其解决方案的GitHub代码库。因此,即使在训练期间接收到随机或错误的奖励信号,模型也能因为事先接触过这些数据而提升其在MATH-500上的表现。

响应模板变化与合成数据验证

进一步的实验表明,当响应模板发生变化时,Qwen2.5模型在MATH-500上的性能会急剧下降,而Llama-3.1-8B几乎不受影响。这进一步支持了Qwen2.5对特定数据模式的依赖性。

为彻底排除记忆效应,研究团队还创建了RandomCalculation数据集,其中包含Qwen2.5发布后生成的完全合成的算术问题。在这些新问题上,Qwen2.5的准确率随着问题复杂度的增加而下降。只有正确的奖励信号才能提高模型表现,而随机奖励会导致训练不稳定,反向奖励甚至会降低其数学技能。受控的RLVR(可验证奖励的强化学习)实验也证实了这些结果:只有正确的奖励才能带来稳定的性能提升,随机或反向奖励则无法提高或主动降低性能。

对未来AI研究的启示

这些发现对Qwen2.5的数学能力是否反映真实推理能力提出了严重质疑,反而表明该模型严重依赖于记忆数据。阿里巴巴于2024年9月推出了Qwen2.5,随后又推出了Qwen3系列。这项研究的发现是否适用于Qwen3系列,仍有待观察。

该研究的作者警告称,受污染的基准测试可能导致关于人工智能进展的误导性结论。他们强调,未来的研究应依赖于干净、未受污染的基准,并评估多个模型系列以获得更可靠的结果。

基准测试的“游戏规则”

研究结果再次凸显了在大型语言模型中区分真实推理与记忆的难度,以及为何严谨、清晰的评估方法对于可靠的人工智能研究至关重要。此前已有研究表明,基准测试可能被操纵或“玩弄”。例如,Meta曾提交一个经过专门调优的Llama4版本,通过使用自定义响应格式在LMArena基准测试中表现优异。其他研究也显示,Gemini2.5Pro和Claude3.5Sonnet等模型能够以高达95%的准确率识别测试场景并调整其响应,这引发了对当前评估方法有效性的更广泛质疑。