最近、アップル社とコロンビア大学の研究チームは、SceneScoutという名前の人工知能プロトタイプシステムを開発しました。このシステムは視覚障害者や低視力者(BLV)向けに街並みのナビゲーションを補助する目的で設計されており、日常的な移動をより簡単にすることを目的としています。

SceneScoutシステムは、アップルマップ(Apple Maps)APIと多モードの大規模言語モデル(GPT-4oを基盤とする)を組み合わせ、パーソナライズされた環境説明を生成します。この革新的な技術により、ユーザーはより直感的で具体的なナビゲーション情報を得ることができ、移動体験が向上します。関連する研究論文は、プレプリントプラットフォームであるarXivに掲載されていますが、まだ同業者による査読は受けていません。

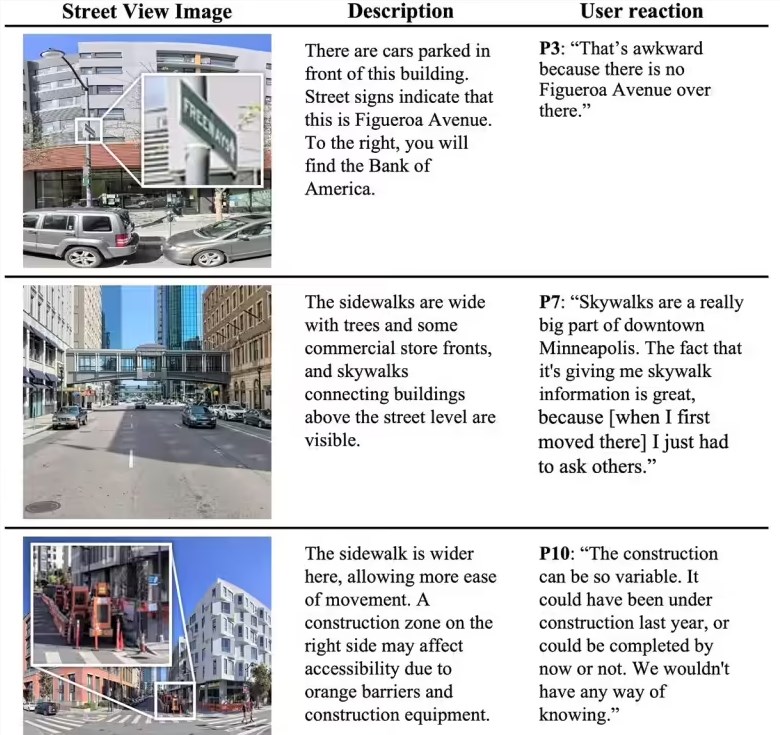

このシステムのコア機能は以下の2つです:まず「ルートプレビュー(Route Preview)」です。この機能により、ユーザーは移動中の道路状況、例えば歩道の状態、交差点の特徴、および近隣のバス停の状況などを見えるようにすることができます。これらの情報は視覚障害者にとって特に重要であり、移動中に周囲の環境を事前に理解するのに役立ちます。

次に、「仮想探索(Virtual Exploration)」機能があります。この機能により、ユーザーは自身のニーズに応じてオープンなシーンを探索できます。例えば、ユーザーが「公園に近い静かな住宅地」を尋ねると、システムはそのニーズに基づいて適切な方向案内を提供します。SceneScoutは歩行者の視点から見える内容を解釈し、構造化されたテキスト情報を生成し、短時間・中距離・長距離の形式に対応した出力をサポートします。これはさまざまなスクリーンリーダーに適応でき、視覚障害者が読みやすくなるように設計されています。

テスト段階では、10人の視覚障害者ユーザーが参加しました。これらのユーザーは多くがテクノロジー業界に関わっていました。テスト結果によると、AIが生成した72%の説明が正確であると評価されました。仮想探索モードにおいては、ユーザーからのフィードバックが非常に好意的で、この機能が伝統的な情報取得方法に効果的に代わることができ、日常的な移動に大きな利便性をもたらすと述べました。

ポイント:

🌍 アップルとコロンビア大学が共同開発したSceneScoutシステムは視覚障害者に街並みのナビゲーションを補助します。

📊 このシステムはApple Maps APIと多モードの大規模言語モデルを組み合わせ、パーソナライズされた環境説明を生成します。

👥 テスト結果では72%のAI生成説明が正確であり、仮想探索機能はユーザーから高い評価を得ています。