近日,蘋果公司與哥倫比亞大學的研究團隊共同開發了一款名爲 SceneScout 的人工智能原型系統。這一系統旨在爲盲人及低視力羣體(BLV)提供街景導航的輔助功能,幫助他們更好地進行日常出行。

SceneScout 系統通過結合蘋果地圖(Apple Maps)API 與多模態大語言模型(基於 GPT-4o 內核),生成個性化的環境描述。這一創新的技術使得用戶能夠獲得更加直觀和具體的導航信息,從而提升他們的出行體驗。相關的研究論文已經在預印平臺 arXiv 上發表,儘管尚未經過同行評審。

該系統的核心功能包括兩大部分:首先是路線預覽(Route Preview)。通過這一功能,用戶能夠預判行程中的道路狀況,例如人行道的質量、交叉口的特徵以及附近公交站的情況等。這些信息對於盲人用戶而言,尤其重要,可以幫助他們在出行時提前瞭解周圍環境。

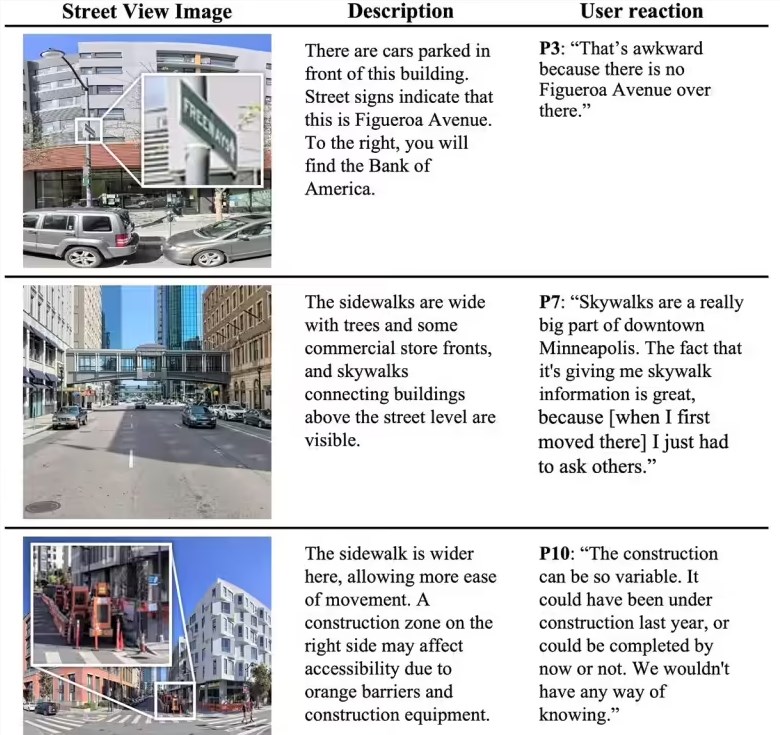

其次是虛擬探索(Virtual Exploration)功能。該功能允許用戶根據自己的需求進行開放場景的探索。例如,用戶可以詢問系統 “臨近公園的安靜居住區”,系統則會根據用戶的需求提供相應的方向指引。SceneScout 通過模擬行人的視角解讀可見內容,並生成結構化的文本信息,支持短、中、長不同格式的輸出,能夠適配多種讀屏軟件,方便盲人用戶閱讀。

在測試階段,SceneScout 招募了10名視障用戶進行使用,這些用戶大多具有科技行業的背景。測試結果顯示,72% 的 AI 生成描述被認爲是準確的。而在虛擬探索模式中,用戶反饋非常積極,稱這一功能可以有效替代傳統的信息獲取方式,爲他們的日常出行帶來了極大的便利。

劃重點:

🌍 蘋果與哥倫比亞大學共同開發的 SceneScout 系統爲盲人用戶提供街景導航輔助。

📊 該系統結合 Apple Maps API 與多模態大語言模型,生成個性化環境描述。

👥 測試顯示72% 的 AI 生成描述準確,虛擬探索功能受到用戶高度評價。