6月17日、上海市のAIユニコーン企業であるMiniMaxは、新たに開発したMiniMax-M1シリーズモデルを発表しました。これは世界初のオープンソースの大規模なハイブリッドアーキテクチャ推論モデルと称されており、文脈処理能力とコスト削減において大きな進展を遂げています。

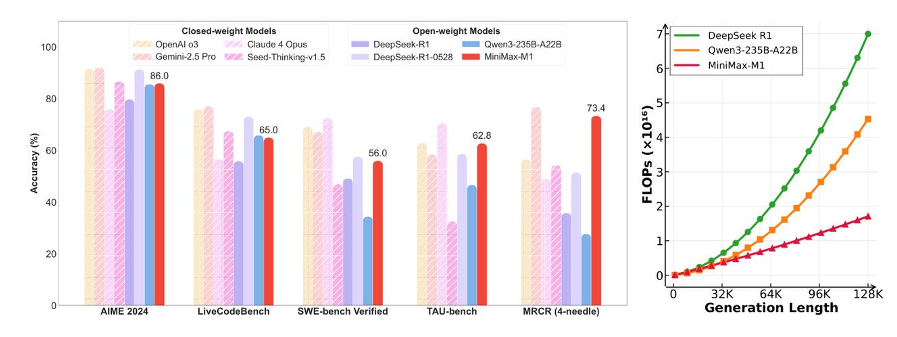

MiniMax-M1モデルの最大の特長は、最大100万トークンの文脈ウィンドウをネイティブでサポートし、推論出力では業界最長となる8万トークンまで対応していることです。この技術革新により、GoogleのGemini2.5Proと同等の水準を達成しています。また、ツール利用シナリオ(TAU-bench)でのパフォーマンスでは、MiniMax-M1-40kがGemini-2.5Proを上回り、その強力な能力を示しました。さらに、MiniMaxはM1モデルの強化トレーニングコストがわずか53.5万ドルであり、従来のモデルと比べて桁違いに少ないことを明らかにしました。

価格戦略では、MiniMaxは段階的な価格設定を採用しており、入力テキストの長さに応じて費用も増加します。具体的には、0〜32kトークンの入力は1百万トークンあたり0.8元、出力は8元です;32k〜128kトークンではそれぞれ1.2元と16元;128k〜1Mトークンでは入力と出力ともに2.4元と24元となっています。この価格設定により、MiniMax-M1は市場競争力が向上し、特に最初の2つのバンドでの価格設定はDeepSeek-R1よりも低いです。

注目すべきは、MiniMaxが今回CISPOアルゴリズムを導入したことです。その収束速度は、字節跳動が最近発表したDAPOアルゴリズムの2倍速く、強化学習段階での計算量はDeepSeek R1の30%以下に抑えられています。これにより、MiniMax-M1モデルのトレーニング効率が大幅に向上し、計算資源の使用量が減少し、さらなる運用コストの削減につながりました。

「AI六小虎」と呼ばれる競合他社に対して、MiniMaxの今回の発表は、大規模モデル競争におけるさらなる前進を意味しています。DeepSeek R2が間もなく登場するため、今後の市場の状況はより複雑になるでしょう。MiniMaxは引き続きオープンソース技術の更新を進め、今後数日以内にさらなる技術や製品が発表される予定です。