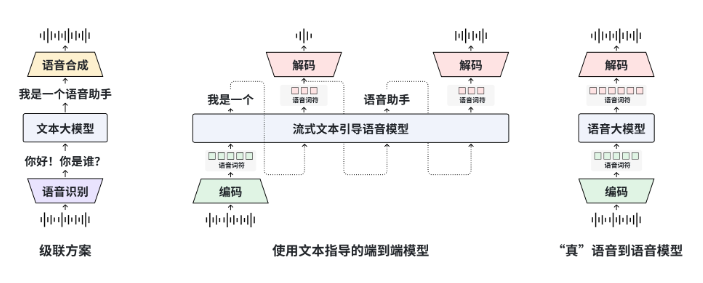

復旦大學MOSS團隊推出MOSS-Speech,首次實現端到端Speech-to-Speech對話,模型已上線Hugging Face Demo並同步開源權重與代碼。MOSS-Speech採用“層拆分”架構:凍結原MOSS文本大模型參數,新增語音理解、語義對齊與神經聲碼器三層,可一次性完成語音問答、情緒模仿與笑聲生成,無需ASR→LLM→TTS三段流水線。

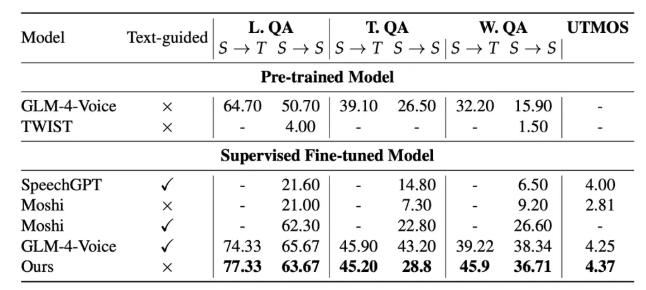

評測顯示,MOSS-Speech在ZeroSpeech2025無文本語音任務中WER降至4.1%,情感識別準確率91.2%,均優於Meta的SpeechGPT與Google AudioLM;中文口語測試主觀MOS分達4.6,接近真人錄音4.8。項目提供48kHz超採樣版與16kHz輕量版,後者可在單張RTX4090實時推理,延遲<300ms,適合移動端部署。

團隊透露,下一步將開源“語音控制版”MOSS-Speech-Ctrl,支持通過語音指令動態調整語速、音色與情感強度,預計2026年Q1發佈。MOSS-Speech已開放商用許可,開發者可通過GitHub獲取訓練與微調腳本,在本地完成私有聲音克隆與角色語音化。