近日,摩爾線程的 AI 研究團隊在國際頂級學術會議 AAAI2026上發佈了其最新研究成果,提出了一種名爲 URPO(統一獎勵與策略優化)的創新框架。這項技術旨在簡化大語言模型的訓練過程,並突破其性能的瓶頸,爲 AI 領域帶來新的技術路徑。

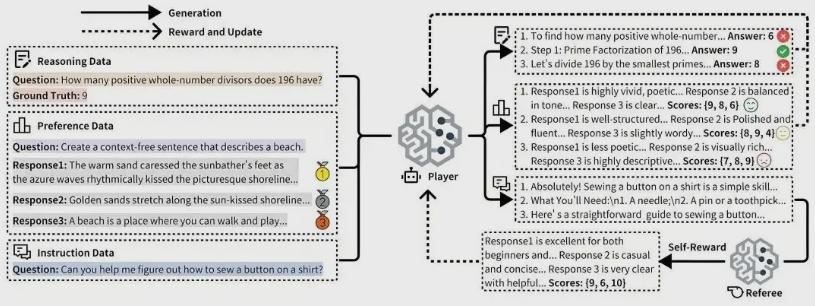

在題爲《URPO:A Unified Reward & Policy Optimization Framework for Large Language Models》的論文中,研究團隊將傳統的 “大模型訓練” 方法進行了重塑。URPO 框架獨特之處在於,它將 “指令遵循” 和 “獎勵評判” 兩種角色合二爲一,讓一個單一模型在訓練階段實現同步優化。這意味着模型不僅能聽懂指令,還能自己打分,從而提升了訓練的效率和效果。

URPO 框架在三個關鍵技術方面攻克了當前的挑戰。首先是數據格式統一,研究團隊成功地將不同類型的數據(如偏好數據、可驗證推理數據和開放式指令數據)轉化爲適用於 GRPO 訓練的統一信號格式。其次,通過自我獎勵循環,模型在生成多個候選回答後,可以自主評分,將其結果用作 GRPO 訓練的獎勵信號,從而形成高效的自我改進循環。最後,協同進化機制通過混合處理三類數據,實現了模型生成能力與評判能力的雙向提升。

實驗結果顯示,基於 Qwen2.5-7B 模型的 URPO 框架,在多個性能指標上均超越了依賴獨立獎勵模型的傳統基線。例如,在 AlpacaEval 指令跟隨榜單上得分提升至44.84,綜合推理能力測試的平均分也從32.66提升至35.66。同時,該模型在 RewardBench 獎勵模型評測中獲得了85.15的高分,表現優於專用獎勵模型的83.55分,充分展現了 URPO 的優越性。

值得一提的是,摩爾線程已經在其自主研發的計算卡上實現了 URPO 框架的高效運行,並完成了與主流強化學習框架 VERL 的深度適配。這一突破不僅標誌着摩爾線程在大模型訓練領域的領先地位,也爲未來的 AI 發展指明瞭方向。