OpenAI 近日發佈了兩款新型開放式權重模型,分別是 gpt-oss-safeguard-120b 和 gpt-oss-safeguard-20b,專注於 AI 安全領域的應用。這些模型在之前發佈的 gpt-oss 系列基礎上進行了優化,依舊遵循 Apache2.0許可證,允許任何人自由使用、修改和部署。

新模型的一個顯著特點是,它爲開發者提供了根據自定義安全政策進行推理分類的能力,打破了傳統 “一刀切” 的安全系統。開發者可以在推斷時輸入自己的安全政策和待檢測內容,模型將根據這些政策進行分類,並提供相應的推理理由。安全政策可以靈活調整,以提高模型的表現。這使得 gpt-oss-safeguard 模型能夠對用戶消息、聊天回覆甚至完整對話進行分類,適應不同的需求。

OpenAI 指出,這種新模型特別適合幾種特定情況。例如,當潛在危害正在出現或演變時,安全政策需要快速適應;在某些高度細分的領域中,傳統小型分類器難以有效應對;以及在開發者缺乏大量高質量樣本的情況下,難以訓練出高水平的分類器。此外,對於那些希望在分類結果的質量和可解釋性上優先於處理速度的場景,這些新模型也是一個理想選擇。

然而,gpt-oss-safeguard 也存在一些侷限性。OpenAI 指出,如果平臺擁有大量標註樣本並能訓練傳統分類器,那麼在複雜或高風險的場景中,後者可能依然表現更佳,定製化模型的精準度更高。同時,這種新模型在處理速度和資源消耗方面較大,因此不太適合用於大規模的實時內容篩查。

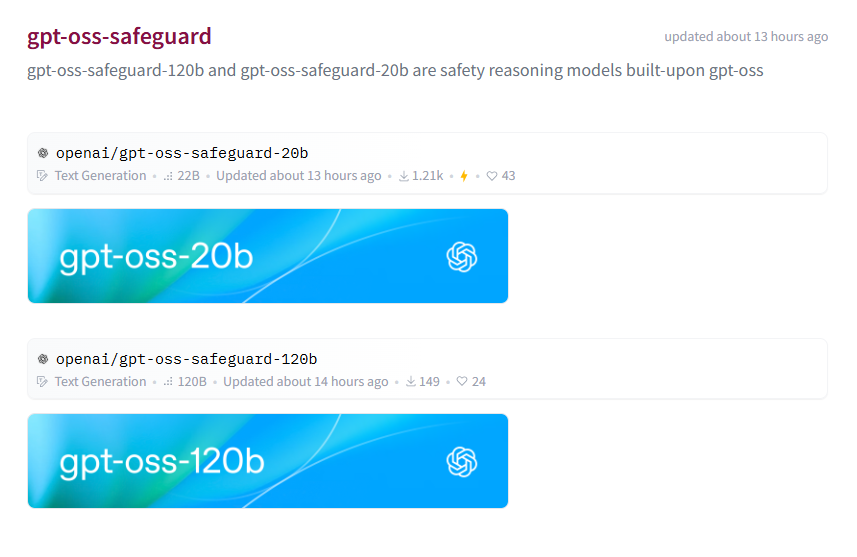

目前,gpt-oss-safeguard-120b 和 gpt-oss-safeguard-20b 已經可以在 Hugging Face 平臺上免費下載,方便廣大開發者進行探索和應用。

https://huggingface.co/collections/openai/gpt-oss-safeguard

劃重點:

🛡️ OpenAI 推出了 gpt-oss-safeguard-120b 和 gpt-oss-safeguard-20b 兩款新型安全模型,允許靈活自定義安全政策。

⚙️ 新模型能夠根據輸入的安全政策對用戶消息和對話進行分類,並提供推理理由。

📊 儘管新模型具有優勢,但在某些情況下,傳統分類器可能更有效,且新模型資源消耗較大。