8月28日,騰訊混元宣佈開源端到端視頻音效生成模型HunyuanVideo-Foley,這一模型能夠通過輸入視頻和文字爲視頻匹配電影級音效,爲視頻創作帶來了新的突破。用戶只需輸入相應的文本描述,HunyuanVideo-Foley就能生成與畫面精準匹配的音頻,從而打破AI生成視頻只能“看”不能“聽”的侷限,讓無聲AI視頻成爲歷史。

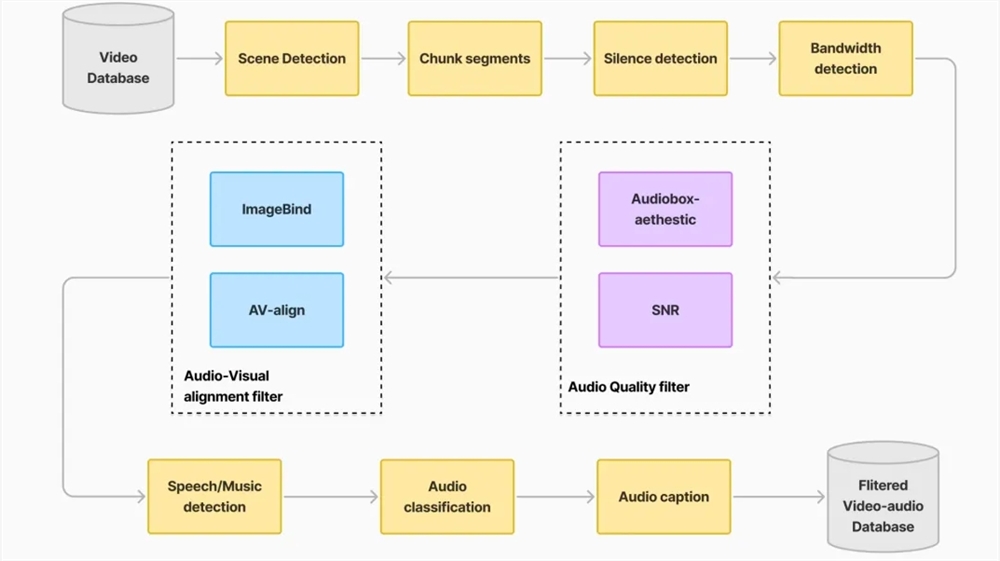

HunyuanVideo-Foley的出現解決了現有音頻生成技術面臨的三大痛點。首先,它通過構建大規模高質量TV2A(文本-視頻-音頻)數據集,提升了模型的泛化能力,使其能夠適配人物、動物、自然景觀、卡通動畫等各類視頻,並生成與畫面精準匹配的音頻。其次,該模型採用創新的雙流多模態擴散變換器(MMDiT)架構,能夠平衡文本和視頻語義,生成層次豐富的複合音效,避免了因過度依賴文本語義而導致的音頻與場景脫節問題。最後,HunyuanVideo-Foley通過引入表徵對齊(REPA)損失函數,提升了音頻生成的質量和穩定性,保證了專業級的音頻保真度。

在多個權威評測基準上,HunyuanVideo-Foley的性能表現全面領先,其音頻質量指標PQ從6.17提升至6.59,視覺語義對齊指標IB從0.27提升至0.35,時序對齊指標DeSync從0.80優化至0.74,均達到了新的SOTA水平。在主觀評測中,該模型在音頻質量、語義對齊和時間對齊三個維度的平均意見得分均超過4.1分(滿分5分),展現了接近專業水準的音頻生成效果。

HunyuanVideo-Foley的開源爲行業提供了可複用的技術範式,將加速多模態AI在內容創作領域的落地。短視頻創作者可以一鍵生成場景化音效,電影團隊能夠快速完成環境音設計,遊戲開發者可以高效構建沉浸式聽覺體驗。

目前,用戶可以在Github、HuggingFace下載模型,也可以在混元官網直接體驗。

體驗入口:https://hunyuan.tencent.com/video/zh?tabIndex=0

項目官網:https://szczesnys.github.io/hunyuanvideo-foley/

代碼:https://github.com/Tencent-Hunyuan/HunyuanVideo-Foley

技術報告:https://arxiv.org/abs/2508.16930

Hugging Face:https://huggingface.co/tencent/HunyuanVideo-Foley