8月28日、テンセント・ハニユアンはエンドツーエンドの動画サウンドジェネレーションモデル「HunyuanVideo-Foley」をオープンソース化することを発表しました。このモデルは、ビデオとテキストを入力することで映画級のサウンドエフェクトをビデオにマッチングし、ビデオクリエーションに新たな突破をもたらします。ユーザーは必要なテキストの説明を入力するだけで、HunyuanVideo-Foleyは画面に正確に一致する音声を生成することができ、AIが生成した動画が「見られるだけ」で「聞こえない」限界を打ち破り、無音のAI動画を過去のものにします。

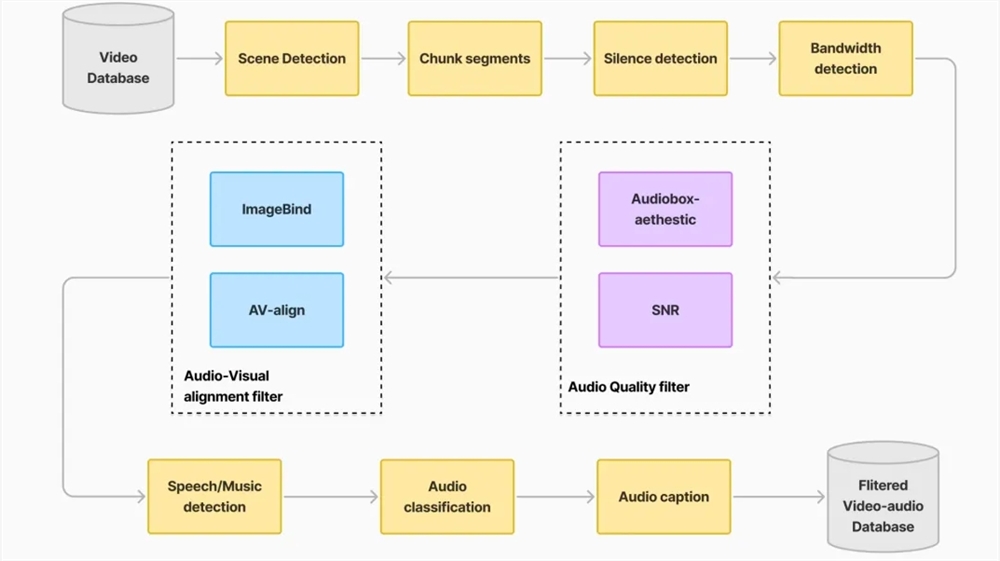

HunyuanVideo-Foleyの登場により、既存の音声生成技術が直面している3つの課題が解決されました。まず、大規模で高品質なTV2A(テキスト-ビデオ-音声)データセットを構築することで、モデルの汎化能力が向上し、人物、動物、自然風景、アニメなどあらゆる種類のビデオに対応し、画面に正確に一致する音声を生成できます。次に、イノベーティブな二重ストリームマルチモーダルディフュージョントランスフォーマー(MMDiT)アーキテクチャを採用しており、テキストとビデオの意味をバランスよく処理し、階層的な複合サウンドエフェクトを生成し、テキストの意味に過度に依存することで音声とシーンがずれてしまう問題を回避できます。最後に、HunyuanVideo-Foleyは表現対齊(REPA)損失関数を導入し、音声生成の品質と安定性を向上させ、プロ仕様の音声の正確さを保証しています。

多くの権威ある評価基準において、HunyuanVideo-Foleyの性能は全面的に優れており、音声品質指標PQは6.17から6.59に上昇し、視覚的意味対応指標IBは0.27から0.35に上昇し、時系列対応指標DeSyncは0.80から0.74に改善され、すべて新しいSOTAレベルに達しました。主観的な評価では、このモデルは音声品質、意味対応、時間対応の3つの次元での平均意見得点が4.1点(満点5点)を超えており、プロ仕様に近い音声生成効果を示しています。

HunyuanVideo-Foleyのオープンソース化により、業界に再利用可能な技術モデルが提供され、マルチモーダルAIのコンテンツ制作分野への実装が加速されます。ショートビデオクリエーターはワンクリックでシーンに適したサウンドエフェクトを生成でき、映画チームは環境音の設計を迅速に行うことができ、ゲーム開発者は効率的に没入型の聴覚体験を構築できます。

現在、ユーザーはGithubやHuggingFaceからモデルをダウンロードしたり、ハニユアン公式サイトで直接体験することができます。

体験入口:https://hunyuan.tencent.com/video/zh?tabIndex=0

プロジェクト公式サイト:https://szczesnys.github.io/hunyuanvideo-foley/

コード:https://github.com/Tencent-Hunyuan/HunyuanVideo-Foley

技術報告:https://arxiv.org/abs/2508.16930

Hugging Face:https://huggingface.co/tencent/HunyuanVideo-Foley